80.000 Saat ekibi / Haziran 2025’te yayınlandı ·

16 Temmuz 1945’te insanlık rahatsız edici bir ilk yaşadı: Bilim insanları, medeniyetin yok olmasına yol açabilecek bir teknolojiyi, yani nükleer silahları test ettiler .

Hiroşima ve Nagazaki saldırılarından bu yana insanlık bir daha nükleer saldırı gerçekleştirmedi. Bunun bir nedeni de, kurumlarımızın kusurlu da olsa daha fazla nükleer saldırıyı engellemeyi başaran uluslararası normlar geliştirmiş olmasıdır.

Gelişmiş yapay zekanın teknolojik ilerlemeleri hızlandıracağını, hatta bazılarının on yıl içinde bir asırlık bilimsel ilerleme beklediklerini düşünüyoruz . Daha hızlı bilimsel ilerleme, ölümcül hastalıkların tedavisinden uzay araştırmalarına kadar muazzam faydalar sağlayabilir.

Ancak bu baş döndürücü hız, yıkıcı yeni silahlar yaratmanın önündeki engelleri azaltırken, onları kontrol etmek için gereken güvenlik önlemlerini oluşturma yeteneğimizi de geride bırakabilir.

Uygun kontroller olmadan bir ülke, grup veya birey yapay zeka tarafından yaratılan kitle imha silahlarını kullanarak küresel bir felakete yol açabilir.

Özet

Gelişmiş yapay zekâ sistemleri, bilimsel ilerlemeyi önemli ölçüde hızlandırabilir ve onlarca yıllık araştırmaları yalnızca birkaç yıla sıkıştırabilir. Bu hızlı ilerleme, gelişmiş biyolojik silahlar ve tamamen yeni tehlikeli teknoloji kategorileri de dahil olmak üzere, yıkıcı yeni kitle imha silahlarının, yeterli güvenlik önlemlerini oluşturabileceğimizden daha hızlı geliştirilmesini sağlayabilir.

Uygun kontroller olmadan, devlet ve devlet dışı aktörler yapay zeka tarafından geliştirilen silahları küresel felaketlere veya insan neslinin tükenmesine yol açmak için kullanabilirler. Ancak bu riskler, yönetişim yaklaşımları ve teknik önlemlerle azaltılabilir.

Bu, insanların kariyerlerinde çözebilecekleri en acil sorunları bulmalarına yardımcı olmak için yazdığımız birçok profilden biri. Farklı sorunları nasıl karşılaştırdığımızı öğrenin ve bu sorunun şimdiye kadar ele aldığımız diğerleriyle nasıl karşılaştırıldığını görün.

Gelişmiş yapay zeka bilimsel ilerlemeyi hızlandırabilir

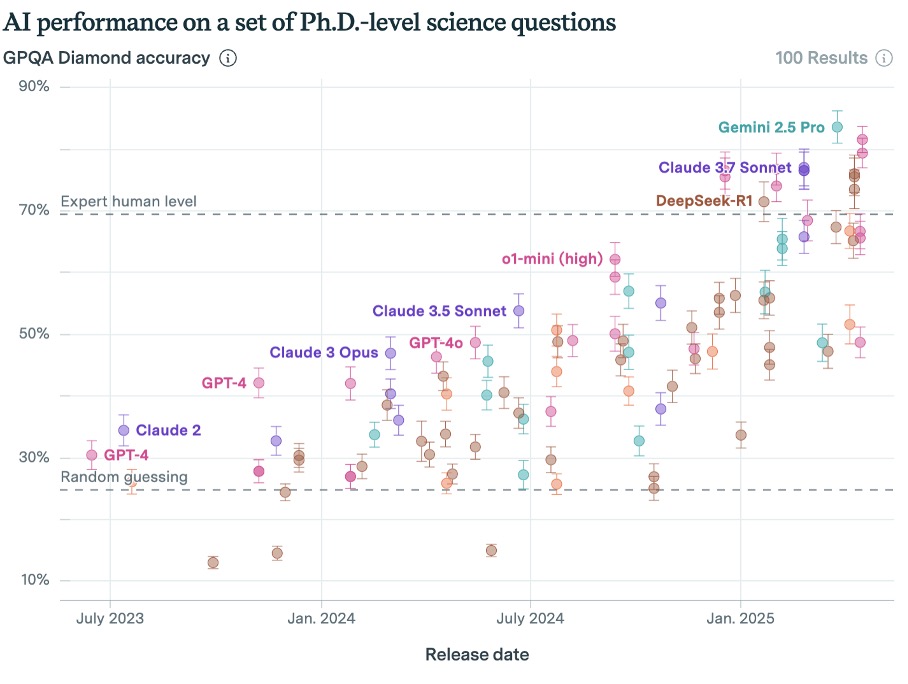

Yapay zeka modelleri ileri bilimsel akıl yürütme testlerinde zaten iyi performans gösteriyor.

Örneğin, GPQA Diamond kıyaslaması, uzman olmayanların Google ile bile cevaplayamayacağı doktora düzeyinde bilim sorularından oluşuyor. Son zamanlarda geliştirilen bazı yapay zeka modelleri, uzman insanlardan daha iyi performans gösteriyor:

Yapay zeka sistemleri, gerçek bilim dünyasında da yankı uyandırdı. Google’ın yapay zeka sistemi AlphaFold, protein katlamanın olağanüstü karmaşık bilimindeki ilerlemelerinden dolayı yaratıcılarına Nobel Ödülü kazandırdı .

Günümüzün yapay zeka sistemleri bilimi tamamen kendi başlarına yürütemez; yine de insan yönlendirmesine ihtiyaç duyarlar. Ancak AlphaFold gibi özel araçlar, yapay zekanın hedeflenen alanlarda ilerlemeyi nasıl hızlandırabileceğini, hatta onlarca yıldır insan çabalarına direnen sorunların çözümüne nasıl yardımcı olabileceğini gösteriyor. Bu, potansiyel olarak tehlikeli uygulamalara sahip alanları da kapsıyor.

Matematik, genetik, kuantum fiziği ve algoritma tasarımı gibi birçok araştırma alanı, büyük ölçekli ve sistematik araştırmalar için olgunlaşmıştır. Bu alanlarda yapay zekâ, hipotezleri hızla üretip test ederek, insanların yıllar hatta on yıllar alabilecek atılımları hızlandırabilir.

Gelecekteki gelişmiş yapay zeka sistemleri, talep üzerine gerçek keşifler üretebilir ve bu da bilgiyi nasıl yarattığımız ve bilimi nasıl yürüttüğümüz konusunda büyük bir değişime işaret edebilir.

Yapay zekâ şirketleri, minimum insan gözetimiyle çalışabilen yapay zekâ sistemleri geliştiriyor. Bu sistemler kendi başlarına yapay zekâ araştırmaları yürütebilir hale gelirse , yapay zekâ alanındaki ilerlemeyi önemli ölçüde hızlandırabilir ve potansiyel olarak yapay genel zekânın (AGI) ortaya çıkışını hızlandırabilirler: çoğu görevde insan performansına eşit veya daha üstün performans gösteren sistemler. Bu tür sistemler, sonunda bilimsel araştırmaları otonom olarak yürüterek insanları devre dışı bırakabilir.

Başka bir yerde AGI’nin pek çok kişinin düşündüğünden çok daha erken gelebileceğini savunmuştuk .

Yani, yakında kendimizi, bilimsel araştırmalar yürütebilen Yapay Zeka (YZ) sistemlerinin iş gücüne katılarak teknolojik sınırları zorlayan çaba miktarını önemli ölçüde artırdığı bir dünyada bulabiliriz. Ancak daha uzun sürse bile, YZ geldiğinde, bilimsel araştırma sürecinde devrim yaratması muhtemeldir.

Bu, salgın hastalıklar ve iklim değişikliği gibi birçok önemli sorunu çözmemize yardımcı olabilir. Ancak bilim, insanlığın kimyasal, biyolojik ve nükleer kitle imha silahları geliştirmesine de yardımcı oldu.

Geçtiğimiz yüzyılda, bu silahlar etrafında uluslararası hukuk ve diplomatik normlar geliştirerek kullanımlarını sınırladık. Yapay zekâ, daha fazla kitle imha silahını daha hızlı geliştirmemize olanak tanırsa, kurumlarımız buna ayak uyduramayabilir.

Gelişmiş yapay zeka ne tür silahlar yaratabilir?

Biyolojik silahlar

En çok endişe duyduğumuz yeni yıkıcı teknoloji kategorisi biyolojik silahlardır. Yapay zeka olmadan bile, ilerleyen biyoteknoloji aşırı riskler doğurur. Patojenlerin enfekte etme, çoğalma, öldürme ve yayılma yetenekleri (çoğunlukla tespit edilemeyerek) onları son derece tehlikeli kılar. Biyomühendislik ürünü pandemiler, insanlık tarihinin en ölümcül olaylarından bazıları olan doğal olarak gelişen pandemilerden çok daha bulaşıcı ve ölümcül olabilir.

Yapay zekanın biyoteknolojik araştırmaları hızla ilerletebileceğini düşünüyoruz. Anthropic CEO’su Dario Amodei şöyle yazdı :

…Temel tahminim, yapay zeka destekli biyoloji ve tıp alanının, insan biyologlarının önümüzdeki 50-100 yılda kat edeceği ilerlemeyi 5-10 yıla sıkıştırmamızı sağlayacağı yönünde. Ben buna “sıkıştırılmış 21. yüzyıl” diyeceğim: Güçlü bir yapay zeka geliştirildikten sonra, birkaç yıl içinde biyoloji ve tıp alanında 21. yüzyılın tamamında kat edeceğimiz tüm ilerlemeyi kaydedeceğimiz fikri.

Ancak yapay zeka biyolojik ve tıbbi araştırmaları hızlandırdıkça, yeni risklerin geliştirilmesini de kolaylaştıracak. Laboratuvar süreçlerinin otomasyonu gibi çift amaçlı araçlar, tehlikeli bir pandemi virüsü üretmeye çalışan haydut aktörlerin önündeki engelleri azaltabilir.

Günümüzün büyük dil modelleri bile teorik olarak biyolojik silah yapımını öğrenmek için kullanılabilir. Bir çalışma , bazı öncü yapay zeka sistemlerinin Viroloji Yetenekleri Testi’nde insan virologlardan daha iyi performans gösterdiğini ortaya koydu; bu da tehlikeli biyolojik deneyler yürüten acemilere yardımcı olabileceklerini gösteriyor .

Yapay zekâlar daha güçlü ve daha otonom hale geldikçe, biyolojik silah yapımında kullanabilecekleri yöntemlerin yelpazesi de genişleyecektir. Örneğin, yapay zekâ tabanlı biyolojik tasarım araçları, gelişmiş aktörlerin tehlikeli patojenlerin genomlarını yeniden programlayarak öldürücülüklerini, bulaşıcılıklarını ve bağışıklık sisteminden kaçma yeteneklerini özel olarak artırmalarına olanak tanıyabilir .

Yapay zeka bilimsel ve teknolojik ilerlemenin hızını artırabilirse, bu riskler artabilir ve hızlanabilir; bu da tehlikeli teknolojinin daha yaygın olarak bulunmasına veya olası yıkıcı gücünün artmasına neden olabilir. 3

2023 yılında yapay zeka uzmanları arasında yapılan bir ankette, katılımcıların % 73’ü , yapay zekanın gelecekte “tehlikeli grupların güçlü araçlar (örneğin tasarlanmış virüsler)” üretmesine olanak sağlayacağı konusunda “aşırı” veya “önemli” endişe duyduklarını söyledi.

Siber silahlar

Yapay zeka, kimlik avı gibi siber saldırılarda halihazırda kullanılabiliyor ve daha güçlü bir yapay zeka, daha büyük bilgi güvenliği sorunlarına yol açabilir (ancak siber savunmada da yararlı olabilir).

Yapay zeka destekli siber savaşın tek başına insanlık için varoluşsal bir tehdit oluşturması pek olası değildir. Toplumsal ölçekte en zararlı ve maliyetli siber saldırılar bile yok oluş düzeyinde bir olaya yaklaşamaz.

Ancak yapay zekâ destekli siber saldırılar, biyolojik silahlar, nükleer cephanelikler veya otonom silahlar gibi diğer tehlikeli teknolojilere erişim sağlayabilir. Dolayısıyla, yapay zekâ ile ilgili siber silahlar gerçek varoluşsal riskler oluşturabilir, ancak büyük olasılıkla başka bir varoluşsal riskle de karşı karşıya kalacaklardır. Örneğin, yapay zekâ destekli bir siber saldırı, nükleer silahların serbest bırakılmasını tetikleyebilir veya kötü niyetli bir grubun biyolojik silah geliştirmek için ihtiyaç duyduğu bilgilere erişmesine olanak tanıyabilir.

Yeni tehlikeli teknolojiler

Yapay zekanın insanların hangi tehlikeli yeni teknolojileri yaratmasına yardımcı olabileceğini tahmin edemeyebiliriz. Nükleer silahların ilk kez Hiroşima ve Nagazaki’ye bomba atılmasından yalnızca on iki yıl önce teorileştirildiğini unutmayın .

Bu uyarıya rağmen, hâlâ bazı potansiyel yeni teknolojiler hakkında spekülasyon yapabiliriz. Bir olasılık , varoluşsal bir tehdit olarak öne sürülen ve bazen nanoteknoloji olarak da adlandırılan atomik hassasiyette üretimdir . Bu, yapay zekanın normalde olduğundan çok daha erken icat etmemize yardımcı olabileceği bilimsel olarak makul bir teknolojidir.

Toby Ord, The Precipice adlı eserinde , 2120 yılına kadar “öngörülemeyen antropojenik riskler” nedeniyle varoluşsal bir felaket yaşanma olasılığının 30’da 1 olduğunu tahmin etti. Bu tahmin, henüz anlaşılmamış fizikle ilgili, felaket sonuçları olabilecek teknolojilerin yaratılmasını sağlayabilecek başka keşiflerin de olabileceğini öne sürüyor.

Bunun nasıl olabileceğine dair bir fikir edinmek için Büyük Hadron Çarpıştırıcısı’nın inşası sırasında ortaya çıkan korkuları düşünün.

Bir grup araştırmacı, ağır iyon çarpışmalarının negatif yüklü garip parçacıklar ve kara delikler üretip üretemeyeceğini araştırmak üzere bir araya geldi. Bu parçacıklar tüm gezegen için potansiyel bir tehdit oluşturabilir. “Akılda kalıcı bir tehdit için hiçbir temel olmadığı” sonucuna vardılar . Ancak, aksi yönde bir bulguya ulaşmış olmaları da mümkün ve fizik alanında gelecekte yapılacak deneylerin aşırı riskler taşıması da mümkün.

Benzer bir örnek, 1942 yılında Los Alamos’taki araştırmacıların, ilk nükleer silah denemesinin durdurulamaz bir zincirleme reaksiyonla Dünya’nın tüm atmosferini tutuşturabileceği riskini göz önünde bulundurmasıdır .

Bu silahlar küresel felaket riskleri yaratabilir

Bu tür silahlar küresel felaket riskini iki şekilde artırabilir:

- Ülkeler arasında tehlikeli silahlanma yarışlarını tetikleyebilir ve potansiyel olarak yıkıcı savaşlara yol açabilirler.

- Terörist gruplar veya kişiler, bu silahları nüfuz elde etmek veya ideolojik amaçlarlakullanabilirler .

Ayrı bir makalede, 2050’den önce büyük güçler arasında bir savaş çıkma ihtimalinin üçte bir olduğunu tahmin ediyoruz . Devletler yeni kitle imha silahlarına erişebilirse, böyle bir savaşın insanlığın yok olmasına yol açma olasılığı daha yüksek görünüyor.

Nükleer silahların yanı sıra, geçmişte hükümetlerin kitle imha silahları için de programlar geliştirdiğini gördük. Örneğin:

- Sovyetler Birliği, uluslararası anlaşmaları ihlal ederek onlarca yıl boyunca büyük ve gizli bir biyolojik silah programı yürüttü.

- II. Dünya Savaşı sırasında Japon ordusunun 731. Birimi Çin’de korkunç insan deneyleri ve biyolojik savaşlar gerçekleştirdi.

Yani bu tür tehditlerin tarihsel bir emsali var.

Haydut devletlerin veya terörist aktörlerin yeni kitle imha silahları üretebilen yapay zekalara erişim sağlama olasılığının daha düşük olduğunu düşünüyoruz. Şu anda, yapay zekanın ABD ve Çin gibi büyük şirketler ve hükümetler tarafından kontrol edilmesi daha olası görünüyor. Ancak, haydut devletlerin veya terörist grupların mevcut yapay zeka modellerindeki güvenlik önlemlerini kırması, modelleri çalıp yeniden kullanması veya açık ağırlık modellerinden faydalanması mümkün.

Stockholm Uluslararası Barış Araştırma Enstitüsü’nün bir raporu, bir silahlanma yarışının istikrarsızlaştırıcı etkilerinin, yapay zekâ alanındaki gelişmeler hayata geçirilmeden önce bile ortaya çıkabileceğini ortaya koydu. Bunun nedeni, bir devletin rakiplerinin yeni nükleer yeteneklere sahip olduğuna inanmasının, caydırıcılıktaki hassas dengeyi bozmaya yetebilmesidir. Benzer dinamikler muhtemelen biyolojik silahlar gibi diğer yeni kitle imha silahları için de geçerlidir.

Neyse ki, yapay zekanın nükleer silahların ve diğer kitle imha silahlarının kullanımını önlemeye yardımcı olabileceği makul yollar da var; örneğin, devletlerin nükleer fırlatmaları tespit etme yeteneğini geliştirerek, 1983’te neredeyse nükleer savaşa yol açan türden yanlış alarmların olasılığını azaltabilir. Yapay zekanın ayrıca istikrar sağlayıcı etkileri de olabilir: örneğin, insanlığın koordinasyon ve doğrulanabilir anlaşmalar oluşturma kapasitesini artırabilir .

Genel olarak, yapay zekanın kısa vadede nükleer veya konvansiyonel çatışma riskini önemli ölçüde artırıp artırmayacağından emin değiliz; ancak olumsuz riskleri azaltmak için daha fazla çalışma yapılmasının önemli olduğunu düşünüyoruz.

Bu riskleri azaltmaya yönelik ümit verici yaklaşımlar mevcuttur

Gelişmiş yapay zekâ, tehlikeli silahların geliştirilmesini hızlandırabilse de, bu tür felaket boyutundaki kötüye kullanım risklerini azaltmak için atabileceğimiz somut adımlar mevcuttur. Bu alandaki çalışmalar genellikle iki kategoriye ayrılır: yönetişim yaklaşımları ve teknik güvenlik önlemleri.

Yönetişim ve politika yaklaşımları

Bu çalışmaya yönelik bazı yaklaşımlar şunlardır:

- Sorumluluk çerçeveleri : Yasal çerçeveler, yapay zeka geliştiricilerini sistemlerinden kaynaklanabilecek öngörülebilir zararlardan sorumlu tutabilir. Bu durum, şirketlerin kötüye kullanıma karşı güçlü güvenlik önlemleri almaları için güçlü teşvikler yaratacaktır.

- Uluslararası anlaşmalar : Tıpkı dünyanın nükleer, kimyasal ve biyolojik silahlar konusunda anlaşmalar geliştirmesi gibi, yapay zekanın geliştirilmesi ve konuşlandırılması konusunda da yeni uluslararası anlaşmalara ihtiyaç duyabiliriz. Bunlar arasında, yapay zeka güvenliği araştırmaları hakkında bilgi paylaşımı veya kötüye kullanım olaylarına verilen yanıtların koordinasyonu gibi anlaşmalar yer alabilir.

- Lisanslama ve denetim : Hükümetler, nükleer teknolojiyi nasıl düzenliyorsak, en gelişmiş yapay zeka sistemlerini geliştirmek veya devreye almak için de lisans talep edebilir. Bu, yetkililerin tehlikeli yetenekler ortaya çıkmadan önce uygun güvenlik önlemlerinin alındığından emin olmalarını sağlayacaktır.

- İhracat kontrolleri ve uluslararası koordinasyon : Hükümetler, gelişmiş yapay zeka sistemlerinin ve bunları çalıştırmak için gereken özel bilgisayar çiplerinin ihracatını düzenleyebilir. ABD, Çin’e çip ihracatına halihazırda bazı kontroller uyguladı ve tehlikeli yapay zeka yeteneklerinin düşman aktörlere ulaşmasını önlemek için benzer yaklaşımlar kullanılabilir.

- Doğrulama ve izleme : Uluslararası Atom Enerjisi Ajansı’nın nükleer programları izlemesine benzer şekilde, yapay zeka anlaşmalarına uyumu izlemek için uluslararası kuruluşlar kurulabilir.

Daha fazla bilgi için yapay zeka yönetişimi ve politika yollarına ilişkin tam kariyer incelememizi okuyabilirsiniz .

Kötüye kullanım risklerini azaltmaya yönelik teknik yaklaşımlar

Bu tür çalışmalardaki yaklaşımlardan bazıları şunlardır:

- Tasarımda Güvenlik : Yapay zeka geliştiricileri, sistemlerini kötüye kullanıma karşı dirençli hale getirmek için doğrudan güvenlik önlemleri oluşturabilirler. Bu, yaratıcı yollarla yönlendirilse bile kitle imha silahları hakkında bilgi vermeyi reddeden modeller geliştirmeyi de içerir. Anthropic ve OpenAI gibi şirketler, bu güvenlik önlemlerinin bazılarını mevcut modellerinde zaten uyguladılar.

- Biyogüvenlik önlemleri : Biyolojik silahlar en ciddi kötüye kullanım risklerinden birini oluşturduğundan, belirli teknik çalışmalar bu tehdide odaklanmaktadır. Örneğin, araştırmacılar, potansiyel olarak tehlikeli dizileri üretilmeden önce tespit etmek için DNA sentez emirlerini tarayabilen yapay zeka sistemleri geliştiriyorlar. Bu “kaynakta tarama” yaklaşımı, kötü niyetli kişilerin biyolojik silahlar için gerekli genetik bileşenleri sipariş etmesini engelleyebilir.

- İzleme ve tespit : Yapay zekâ sistemleri, kötüye kullanım girişimlerini tespit etmek için kullanılabilir. Örneğin, yapay zekâ, şüpheli biyolojik silah geliştirme süreçlerini tespit etmek için bilimsel literatürü, tedarik modellerini veya laboratuvar faaliyetlerini izleyebilir. Benzer şekilde, yapay zekâ, siber saldırıları veya diğer kötü amaçlı faaliyetleri gerçek zamanlı olarak tespit etmeye de yardımcı olabilir.

- Erişim kontrolleri : Teknik önlemler, en tehlikeli yapay zeka yeteneklerine kimin erişebileceğini sınırlayabilir. Bu, belirli istek türleri için özel kimlik doğrulaması gerektirmeyi veya en tehlikeli yeteneklerin yalnızca onaylı kullanıcılar tarafından kullanılabildiği “çift kullanımlı” modeller geliştirmeyi içerebilir.

Daha fazla bilgi için yapay zeka güvenliği teknik araştırma yollarının tam kariyer incelememizi okuyabilirsiniz .

Yapay zeka politikası ve güvenliği alanı hala hızla gelişiyor ve yeni fikir ve yaklaşımlar için önemli bir alan mevcut. Yukarıda listelenenler gibi mevcut fikirlerin daha fazla analiz ve incelemeyi hak eden önemli dezavantajları olabilir. Bu çözümlerin çoğu, teknoloji uzmanları, politika yapıcılar ve uluslararası kuruluşlar da dahil olmak üzere birden fazla paydaş arasında koordinasyon gerektirecektir.

Daha da önemlisi, kötüye kullanım risklerini azaltmak, yapay zeka gelişimini tamamen durdurmayı gerektirmez; bunun yerine, güvenlik önlemlerinin yeteneklerle uyumlu olmasını sağlamayı gerektirir. Nükleer teknolojiyi faydalı amaçlar için kullanmayı ve silahların yayılmasını sınırlamayı öğrendiğimiz gibi, aynı şeyi yapay zeka için de yapabiliriz.

Bu müdahalelerin uygulanması için zaman sınırlı olabilir. Yapay zeka yetenekleri hızla geliştikçe, kilit aktörlerin bu sistemlerin felaket boyutunda kötüye kullanılmasını önlemek için etkili güvenlik önlemleri, uygulamalar ve yönetişim çerçeveleri oluşturmak üzere hızlı hareket etmeleri gerekecektir.

Notlar ve referanslar

- Epoch AI, yapay zekanın biyoriske katkılarına ilişkin mevcut değerlendirmelerin bir analizini yayınladı ve Viroloji Yetenekleri Testi’nin “zorluğu ve viroloji örtük bilgisine odaklanması göz önüne alındığında, günümüz modellerinin amatör biyoteröristleri önemli ölçüde yükseltebileceği iddiasına özel bir güvenilirlik kazandırıyor gibi göründüğünü” buldu. ↩

- Urbina ve diğerleri (2022), ilaç keşfi için mevcut yapay zeka teknolojilerinin biyokimyasal silah tasarlamak amacıyla kötüye kullanılabileceğine dair hesaplamalı bir kanıt geliştirdiler.

Ayrıca bakınız:

Sentetik biyoloji alanında yapay zeka, kötü niyetli aktörlerin özel özelliklere sahip tehlikeli patojenler tasarlamasının önündeki engelleri azaltabilir.

Turchin ve Denkenberger (2020) , bölüm 3.2.3. ↩

- Bu konu hakkında daha fazla bilgi için bkz.: Sandbrink, Jonas B. “Yapay zeka ve biyolojik kötüye kullanım: Dil modelleri ve biyolojik tasarım araçlarının risklerinin ayırt edilmesi.” arXiv ön baskısı arXiv:2306.13952 (2023). ↩

- Grace ve diğerleri (2024),778 katılımcının 1.345’ine (NeurIPS, IMCL veya diğer dört büyük yapay zeka kuruluşunda yayın yapan araştırmacılar) potansiyel olarak endişe verici yapay zeka senaryoları hakkında sorular sordu. (Anketin kısa tutulması için katılımcılara yalnızca birkaç konudan biriyle ilgili sorular rastgele dağıtıldı ve soruların önemi ve büyük bir örneklem büyüklüğünün ne kadar faydalı olacağı gibi faktörlere bağlı olarak daha fazla katılımcıya sorular dağıtıldı.)

Kendilerine aşağıdaki on bir senaryo soruldu:

- Güçlü bir yapay zeka sisteminin hedefleri doğru belirlenmezse felakete yol açar (örneğin güçlü silahlar geliştirir ve kullanır).

- Yapay zeka, tehlikeli grupların güçlü araçlar (örneğin, tasarlanmış virüsler) üretmesine olanak tanır

- Yapay zeka, sahte bilgilerin (örneğin deepfake’ler) yayılmasını kolaylaştırıyor

- Yapay zeka sistemleri geniş çaplı kamuoyu eğilimlerini manipüle ediyor

- Yanlış hedeflere sahip yapay zeka sistemleri çok güçlü hale geliyor ve karar alma sürecinde insanların rolünü azaltıyor

- Yapay zeka sistemleri, belirli kurumlara orantısız fayda sağlayarak ekonomik eşitsizliği daha da kötüleştiriyor

- Otoriter yöneticiler, nüfuslarını kontrol etmek için yapay zekayı kullanıyor

- Yapay zeka sistemlerindeki önyargılar adaletsiz durumları daha da kötüleştirir, örneğin yapay zeka sistemleri işe alım süreçlerinde cinsiyete veya ırka göre ayrımcılık yapmayı öğrenir

- İşgücünün neredeyse tamamen otomasyonu çoğu insanı ekonomik olarak güçsüz bırakıyor

- İşgücünün neredeyse tamamen otomasyona geçmesi, insanların hayatlarında anlam bulma konusunda zorluk çekmelerine neden oluyor.

- İnsanlar yapay zeka sistemleriyle etkileşime girerek daha fazla zaman harcadıkları için diğer insanlarla daha az etkileşime giriyorlar

Katılımcılara her senaryo için “hiç endişe yok”, “biraz endişe”, “önemli endişe” veya “aşırı endişe” ifadeleri soruldu.

Grace ve arkadaşları şunları buldu:

Her senaryo, katılımcıların %30’undan fazlası tarafından önemli veya aşırı endişe verici olarak değerlendirildi. Bir senaryonun “önemli” veya “aşırı” endişe verici olduğunu düşünen katılımcıların yüzdesine göre ölçüldüğünde, en fazla endişe verici senaryolar şunlardı: sahte bilgilerin yayılması (örneğin deepfake’ler), büyük ölçekli kamuoyu eğilimlerinin manipüle edilmesi (%79), yapay zekanın tehlikeli grupların güçlü araçlar (örneğin tasarlanmış virüsler) üretmesine izin vermesi (%73), otoriter yöneticilerin nüfuslarını kontrol etmek için yapay zeka kullanması (%73) ve yapay zeka sistemlerinin belirli bireylere orantısız bir şekilde fayda sağlayarak ekonomik eşitsizliği kötüleştirmesi (%71).

Bir senaryonun neden endişe verici olarak değerlendirilebileceği konusunda bazı belirsizlikler var: özellikle felaketli, özellikle olası veya her ikisi olarak değerlendirilebilir. Sonuçlarımıza göre, bu hususları netleştirmenin bir yolu yok. ↩

- “Jailbreak”, bir yapay zeka sisteminin yerleşik güvenlik kısıtlamalarını aşmak için kullanılan ve sistemin yasaklı veya tehlikeli çıktılar üretmesini sağlayan hızlı manipülasyon tekniklerini ifade eder. ↩

https://80000hours.org/problem-profiles/catastrophic-ai-misuse/