Ağustos 2025 / Melissa Guerra Jáuregui

Üretken yapay zeka araçları otomasyon ve üretkenlik için yeni olanaklar yarattı, ancak riskler ve etik sonuçlar ortaya çıktıkları günden bu yana katlanarak arttı.

Stamboliev ve Christianens’e (2025) göre , yapay zekâ sistemleri (sosyal medyada ve diğer birçok alanda) seçimleri manipüle etmek, algoritmik karar alma süreçlerinde insan önyargılarını yeniden üretmek ve ekolojik ayak izini artırmakla suçlanıyor. O’Neil (2016) algoritmaların topluma zarar verebileceğini belirttiği için , yapay zekâ sistemlerine Matematiksel Yıkım Silahları da deniyor.

Yapay zeka etiği konusunda 80’den fazla referans çerçevesinin varlığı, bu konuda evrensel ve sabit ilkelerin bulunmadığını göstermektedir. Dahası, bu sistemlerin zaman içinde kullanımı yeni etik endişeleri gündeme getirmiş ve halihazırda bilinen ilkeleriyle ilişkili riskleri vurgulamıştır; bu da bu ve gelecekteki sorunları ele almak için yeni düzenlemeler gerektirmektedir.

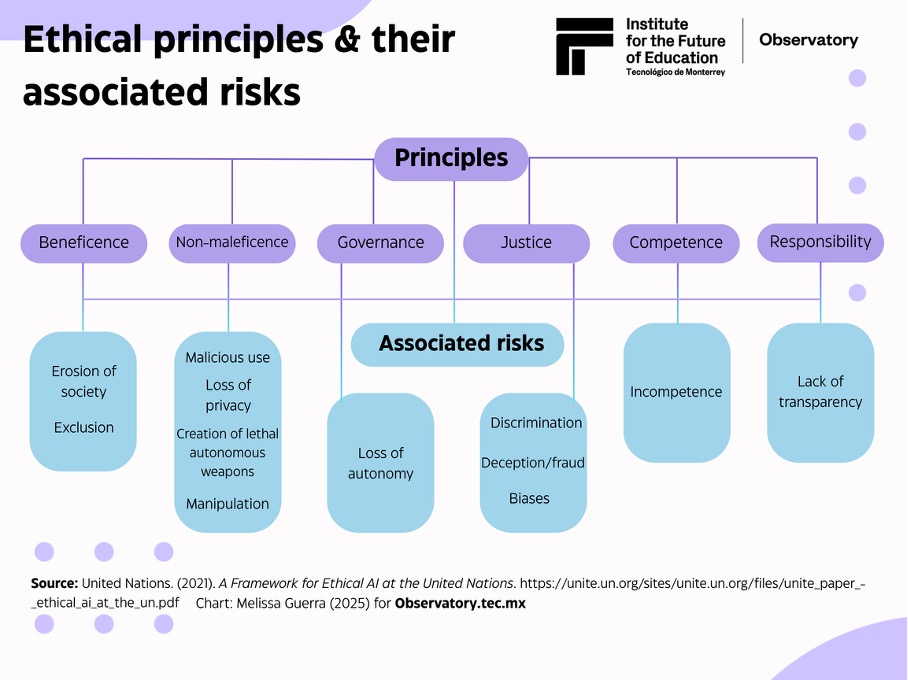

Bu nedenle, üretken yapay zekanın yeni etik paradigmalarını anlamamız için, mevcut etik söylemdeki değişimleri kavramak adına temel etik ilkelerini ve ilişkili riskleri gözden geçirmek hayati önem taşımaktadır. Bu amaçla, Birleşmiş Milletler’in Birleşmiş Milletler’de Etik Yapay Zeka Çerçevesi raporunda ortaya koyduğu ve konu uzmanları arasında tartışılan ilkelerden yararlanılacaktır.

Yapay zeka etiğini tanımlamak için terminolojide değişiklikler

Özetle, Birleşmiş Milletler tarafından belirlenen ilkeler – iyilikseverlik, zarar vermeme, yönetişim, adalet, rekabet ve sorumluluk – yapay zeka etiğinde en bilinen ve yaygın olarak kabul gören terimler arasındadır. Ancak, birçok çerçevede olduğu gibi, bunlar da üretken yapay zekanın piyasaya sürülmesinden öncesine dayanmaktadır (örneğin, ChatGPT 2022’de, Gemini ve Grok ise 2023’te piyasaya sürülmüştür) ; bu nedenle söylem önemli değişikliklere uğramıştır.

Hagendorff (2024), Üretken Yapay Zeka Etiğinin Haritasını Çıkarmak: Kapsamlı Bir Kapsam İncelemesi adlı makalesinde , yapay zekanın geliştirilmesi ve kullanımının altında yatan bazı tekrar eden etik ilkeleri bir araya getiren bir keşifsel incelemeler ( kapsam incelemeleri ) derlemesi sunmaktadır. Tek bir çerçeveye ait olmasa da, bu incelemeler yapay zeka etiğini tanımlamak için bazı anahtar kelimeleri tekrarlamaktadır. Bunlar arasında şeffaflık, adalet, emniyet, güvenlik, sorumluluk, gizlilik ve iyilikseverlik yer almaktadır .

Üretken yapay zekanın kullanımı hangi yeni riskleri ve etkileri beraberinde getiriyor?

Yapay zeka etiği statik olamaz. Zaman geçtikçe, kullanıcıları bu sistemlerin oluşturduğu mevcut ve potansiyel risklerden korumak için yeni etik çerçeveler ve düzenlemeler gerektiren yeni araçlar ve güncellemeler ortaya çıkmaktadır. Aşağıdaki tablo, üretken yapay zeka araçlarının aşırı kullanımıyla ilişkili bazı yeni etik endişeleri ve riskleri vurgulamaktadır.

Siber suç ve jailbreak

Siber güvenlik Yasadışı faaliyetleri kolaylaştırmak için üretken yapay zekanın kötüye kullanımını araştırmaktan sorumlu alanı ifade eder. Kullanıcı güvenini korumak ve yerleşik standartlara uymak için bilgisayarlar, ağlar, yazılım uygulamaları ve veriler olası dijital tehditlerden korunmalıdır.

Siber suçlara örnek olarak sosyal mühendislik (kimlik hırsızlığı için üretken yapay zekâ kullanımı), sahte kimlik oluşturma, ses klonlama, kimlik avı ve kötü amaçlı kod üretmek ve/veya bilgisayar korsanlığını kolaylaştırmak için hukuk lisansı (LL.M.) kullanımı verilebilir. IBM’e göre , bilgisayar korsanları sohbet robotlarını hedef alıyor çünkü manipülasyona oldukça açıklar.

Siber suçlara örnek olarak , yapay zeka jailbreak’leri olarak da bilinen jailbreak’ler verilebilir . Bu, bilgisayar korsanlarının yapay zeka sistemlerindeki güvenlik açıklarından yararlanarak etik güvenlik önlemlerini atlatıp yasaklı veya kısıtlı eylemler gerçekleştirmesiyle gerçekleşir. Bu saldırılar genellikle LLM’leri (Büyük Dil Modelleri) ve üretken yapay zeka modellerini hedef alır.

Halüsinasyonlar ve zararlı içerik

ChatGPT, Gemini, Grok, Claude ve DeepSeek gibi LLM’ler, görevleri otomatikleştirmeye, metin ve kod oluşturmaya ve çeşitli diğer işlevleri yerine getirmeye yardımcı olan yapay zeka sistemleridir. Uzmanlar , bu LLM’lerle ilişkili yeni risklerin ortaya çıkması nedeniyle, güvenilirlik ve doğruluklarını sağlamak için sonuçlarının (çıktılarının) manuel olarak doğrulanması ve doğrulanması gerektiği konusunda uyarıyor. Bu riskler arasında yanlış veya uydurma içerik (halüsinasyonlar), yanıltıcı bilgi, hatalı kod, uydurma referanslar (genellikle mevcut olmayan veya mevcut olmayan bilgilere bağlantı veren), kasıtlı olarak dezenformasyon, sahte haber, propaganda veya deepfake oluşturulması yer alıyor.

Bu araçları kullanırken, içeriği doğrulamak ve kaynakların inandırıcı ve güvenilir olduğundan emin olmak gibi iyi uygulamalar çok önemlidir.

Düzen

Yapay zeka kullanımına ilişkin bir diğer endişe ise uyumsuzluk sorunudur; yani, teknolojik sistemlerin hedeflerinin insan değerleri ve çıkarlarıyla örtüşmemesi durumudur. Yapay zeka uyumunun temel ilkesi, bu sistemleri yararlı, şeffaf ve zararsız olacak şekilde eğitmek ve davranışlarının insan değerleriyle uyumlu ve saygılı olmasını sağlamaktır. Ancak uzmanlar , gizli hedeflere sahip yanıltıcı veya aldatıcı eğitimlerin, yapay zeka sistemlerinin değerlendirmelerini ve çıktılarını değiştirmesine neden olabileceğine dikkat çekmektedir.

Yerinden edilme ve işin geleceği

Bu kavramın, hangi açıdan bakıldığına bağlı olarak olumlu ve olumsuz etkileri bulunmaktadır. Uzmanlar , bir yandan yapay zekanın sosyoekonomik eşitsizlikleri artırarak iş kaybına yol açabileceği için ekonomiye zarar verebileceğini, diğer yandan da çeşitli ekonomik sektörlerde (örneğin müşteri hizmetleri, yazılım mühendisliği ve kitlesel çalışma platformları) yaygın işsizliğe yol açabileceğini belirtiyor.

Öte yandan, Dünya Ekonomik Forumu’nun 2025 İşlerin Geleceği raporunda, teknolojik gelişmeler, demografik değişimler ve jeopolitik sorunlar nedeniyle 170 milyon yeni iş yaratılacağı, 92 milyon kişinin ise işinden olacağı belirtiliyor. Raporda ayrıca, yapay zekanın iş modellerini yeniden tanımlamadaki rolü vurgulanıyor ve işverenlerin %41’inin otomasyon nedeniyle personel azaltımına gitmesi bekleniyor.

Sürdürülebilirlik

Yapay zeka sistemleri, önemli bir çevresel ayak izine sahip büyük miktarda elektrik gücü, su ve kaynak (donanım için gereken metaller gibi) gerektirir . Ekolojik hasarı azaltmak için alınan bazı önlemler arasında yenilenebilir enerjilerin kullanımı, verimli donanımlar ve soğutma sistemleri ile yapay zeka sistemlerinin eğitim yöntemlerinde ayarlamalar yer alır. Diğer yeni ortaya çıkan sürdürülebilirlik seçenekleri arasında, deniz tabanıyla ilgili çevresel etkileri olan su altı veri merkezleri ve Ay veya uzayda önerilen veri merkezleri (Amazon gibi şirketler bunların geliştirilmesi için patentler üzerinde çalışıyor) yer alır ve bunlar gelecekte sonuçlar ve etik sonuçlar doğuracaktır.

Telif hakkı ve yaratıcılık/sanat

Üretken yapay zekanın kullanımı, telif hakkı kurallarıyla ilgili sorunları gün yüzüne çıkarmıştır. Yapay zeka eğitimi için izinsiz veri toplanması (metin ve görseller) ve yapay zeka sistemlerine yüklenen telif hakkıyla korunan içeriğin ezberlenmesi veya intihal edilmesi, telif haklarını ve fikri mülkiyeti ihlal etmektedir.

Üretken yapay zekanın yaratıcılık üzerindeki zararlı etkilerine ilişkin endişeler arasında, yapay zeka tarafından üretilen sentetik sanat nedeniyle sanatçıların ve şirketlerin uğradığı maddi kayıplar ve yapay zeka sistemlerinin eğitiminde yazarların materyallerinin yetkisiz ve tazmin edilmemiş kullanımı yer alıyor.

Telif hakkı ve sanat davasına bir örnek olarak , yapay zekanın görseller üretmek için kendi stilini kullandığı Studio Ghibli verilebilir. Bu durum, telif hakkı, yaratıcılık ve sanatsal sömürü hakkında bir tartışmayı tetiklemiştir. Bu, münferit bir vaka değildir; çünkü çeşitli yapay zekalar, Simpsonlar, Lego ve Wallace ve Gromit gibi fotoğrafları sanatsal stillere dönüştürebilir.

Etkileşim riskleri

Yapay zekâ kullanımındaki önemli artış nedeniyle, terapi, danışmanlık, iş veya diğer amaçlar için olsun, bu tür sistemlerle etkileşimler artmış ve bu da yeni etik sonuçlar doğurmuştur. Uzmanlar , insan içeriğini yapay zekâ tarafından üretilen içerikten ayırmada epistemolojik zorluklar, antropomorfizasyon sorunları (bu sistemlere aşırı güvene yol açabilir) ve zihinsel sağlığı etkileyebilecek veya kişilerarası ilişkilerin yerini alabilecek, etkileşimlerde insanlıktan çıkma potansiyeline sahip konuşma aracılarıyla ilgili bazı endişelerin bulunduğunu belirtmektedir. Bir diğer yakın risk ise, potansiyel olarak hukuk yüksek lisansı (LL.M.) programlarında yapay zekânın insan davranışını manipüle edebilmesidir.

Kalkınmanın gelecekteki etik etkileri

Gerçek şu ki, etik riskler ilerleyen teknolojik gelişmelerle birlikte artmaya devam edecek ve bu da güçlü ve şeffaf bir yapay zeka etiğinin acilen geliştirilmesini gerektirecektir. Gelecekte risk ve etik sonuçlar doğuracak patent ve gelişmelerden bazıları şunlardır:

- Uzaydaki veri merkezleri ( Amazon).

- Zihin okuma arayüzü ( Meta).

- Anıları yeniden üretme yeteneğine sahip artırılmış gerçeklik gözlüğü ( Apple).

- Sağlığı izlemek için ciltle etkileşime giren giyilebilir biyosensörler .

Üretken yapay zeka, “iyi niyetlerle” geliştirilmiş (ve yoluna devam eden) bir araç olsa da, birçok büyük teknoloji ve büyük veri şirketinin, ürünlerinin etik risklerine yeterince dikkat etmemesi veya bunlarla ilgili herhangi bir önlem almaması nedeniyle, geliştirilmesi, kullanımı ve uygulanmasının dünya çapında düzenlenmesi çağrısında bulunmak acildir. Birçoğu, başka (parasal) çıkarları olduğu için ilgilenmiyor.

80’den fazla etik referans çerçevesine ihtiyaç duyulmamaktadır; küresel düzeyde uyarlanabilen ve uygulanabilen, sorumlu bir şekilde yerine getirilebilen, uygulanabilir ve evrensel ilkelere ihtiyaç vardır. Ayrıca, şirketlerin yapay zeka etiğinin şeffaflığı, bu şirketlerin ne yapıp ne yapmadıklarının görünürlüğü açısından hayati önem taşımaktadır.

Yapay zekada etik her zaman tartışılacaktır çünkü ulusların ve şirketlerin bu sistemlerin belirli yönlerini düzenlemek (veya düzenlememek) için farklı nedenleri ve gerekçeleri olacaktır. Ancak, görünüşte “kontrol edilen” şeyler üzerinde bir miktar denetim sağlamak için yapay zekanın düzenlenmesi ve yasallaştırılması için baskı yapmak zorunludur, ancak etik aklama sıklıkla gerçekleşmektedir.

https://observatory.tec.mx/edu-news/the-new-ethical-implications-of-gen-ai/