Connor Attridge

Giriş:

Eylül 2025’in sonlarında, Kaliforniya Valisi Gavin Newsom, Sınır Yapay Zeka Şeffaflığı Yasası’nı (TFAIA) 53 sayılı Senato Tasarısı’nı yasalaştırdı. Bu yasa, ABD’de en güçlü “sınır” yapay zeka modellerinin geliştiricilerini özel olarak düzenleyen ilk bağlayıcı yasa olup , küresel yapay zeka endüstrisinin coğrafi ve ekonomik merkezinden yeni bir emsal teşkil ediyor. OpenAI, Google, Meta ve Anthropic gibi kilit oyuncuların evi olan Kaliforniya, sınırlarının ötesine uzanan bir etkiye sahip.

Kaliforniya eyalet yönetimi, ABD’de kapsamlı bir federal yapay zeka çerçevesinin sürekli yokluğunun yarattığı politika boşluğunu doldurdu. Bu hamle, yapay zeka gelişimine müdahale etmeyen bir yaklaşımı savunmakla kalmayıp aynı zamanda eyaletlerin kendi kurallarını yürürlüğe koymasını da aktif olarak engellemeye çalışan Trump yönetiminin yaygın inovasyon yanlısı ve düzenleme karşıtı duruşuna aykırıdır. TFAIA, ülkenin en kalabalık ve ekonomik olarak en güçlü eyaletinin, yapay zeka şeffaflığı için fiili ulusal ve hatta belki de uluslararası bir standart belirleme yönündeki yüksek riskli bir girişimidir .

TFAIA’nın kapsamı ve mekaniği

TFAIA, özellikle sınır modelleri için geçerlidir ve en katı yükümlülükleri ” büyük sınır geliştiricileri ” için ayrılmıştır. Büyük bir sınır geliştiricisi, yasal olarak, bir önceki takvim yılında yıllık brüt geliri 500 milyon doları aşan bir yapay zeka şirketi olarak tanımlanır; bu yüksek eşik, daha küçük şirketleri ve yeni kurulan şirketleri külfetli uyumluluk maliyetlerinden korumak için tasarlanmıştır.

Sınır modelinin teknik tanımı, 10 26 kayan noktalı işlemden (FLOP) daha fazla işlem gücü kullanılarak eğitilmiş bir temel modeldir. Bu hesaplama eşiği, Biden yönetimi tarafından yürürlüğe konulan ve artık yürürlükten kaldırılan 2023 tarihli ABD Yapay Zeka Yürütme Kararnamesinde kullanılan tanımla örtüşmektedir. Bu, AB Yapay Zeka Yasası’nın “yüksek etkili yeteneklere” sahip olduğu varsayılan sistemler için belirlediği 10 25 FLOPS eşiğinden çok daha büyüktür.

TFAIA’nın temel hükümleri

TFAIA’nın yükümlülükleri üç temel alana odaklanmaktadır:

- Kamu güvenliği çerçeveleri: Büyük sınır geliştiricileri kapsamlı bir yapay zeka güvenlik çerçevesi geliştirmeli, uygulamalı ve yayınlamalıdır. Bu çerçeve, felaket risklerini nasıl değerlendirdiklerini, model ağırlıklarını nasıl güvence altına aldıklarını ve sektördeki en iyi uygulamaları nasıl entegre ettiklerini ayrıntılı olarak açıklamalıdır .

- Olay bildirimi: Tüm sınır geliştiricileri, “kritik güvenlik olaylarını” 15 gün içinde Kaliforniya Valisi Acil Durum Hizmetleri Ofisine bildirmelidir; ölüm veya ciddi fiziksel zarar riski varsa 24 saat içinde bildirmelidir.

- Muhaliflere yönelik korumalar: Yasa, halk sağlığı veya güvenliği açısından önemli tehlikeleri bildiren çalışanlar ve yükleniciler için güçlü yasal korumalar sağlar. Ayrıca, büyük müteahhitlerin dahili ve anonim bir bildirim süreci oluşturmasını zorunlu kılar.

Bu gerekliliklerin yasal olarak uygulanabilir olmasını sağlamak için yasa tasarısı riskin açık ve ölçülebilir tanımlarını sunmaktadır. ” Felaket riski “, 50’den fazla kişinin ölümüne veya ciddi şekilde yaralanmasına önemli ölçüde katkıda bulunabilecek veya 1 milyar doların üzerinde mal hasarına yol açabilecek bir olay olarak tanımlanmaktadır. Ancak yasa tasarısı federal hükümet faaliyetleri için önemli bir muafiyet tanımaktadır. Basitçe ifade etmek gerekirse, bir risk, ABD federal hükümeti tarafından sınır yapay zeka modelinin yasal kullanımından kaynaklanıyorsa, bu yasa tasarısı kapsamında yasal olarak felaket olarak kabul edilmemektedir . Bu, riskle ilgili açıklama gerekliliklerinin tüm federal hükümet uygulamalarında zorunlu olmayacağı anlamına gelir. Son olarak, yasa tasarısı , bir modelin ağırlıklarına yetkisiz erişim gibi zarara veya felaket riskine yol açan olayları içeren ” kritik güvenlik olayı “nı tanımlamaktadır.

ABD’nin siyasi arka planı

Kaliforniya’nın federal düzenlemeye karşı mücadelesi

ABD federal hükümeti, sıkı düzenlemeler yerine inovasyona ve Amerikan liderliğine öncelik vermiştir. Düzenlemelerin kaldırılmasına odaklanması, Ocak 2025 tarihli Yapay Zekada Amerikan Liderliğinin Önündeki Engelleri Kaldırma kararnamesiyle daha da belirginleşmiştir . Bu kararname, önceki yönetimin “Amerika’nın küresel yapay zeka hakimiyetini” sürdürmek için uyguladığı daha temkinli yapay zeka güvenlik çerçevesini açıkça iptal etmiştir. Rekabet avantajını korumayı amaçlayan bu müdahalesiz yaklaşım, Kaliforniya’nın TFAIA ile uyguladığı proaktif önlemlerle keskin bir tezat oluşturmaktadır .

Ancak TFAIA’nın uzun vadeli etkileri belirsiz. Cumhuriyetçi senatörler, eyalet ve şehir düzeyindeki tüm yapay zeka düzenlemelerini on yıl boyunca yasaklama girişimlerinde başarısız olsalar da , bu hamle federal hükümetin eyalet düzeyindeki eylemleri engelleme yönünde güçlü bir iştahının olduğunu gösteriyor .

Trump yönetiminin Temmuz 2025’te yayınladığı Amerika Yapay Zeka Eylem Planı, kendi düzenleme yollarını izleyen eyaletleri açıkça cezalandırmakla tehdit ediyor. Plan, federal kurumlara, finansman kararları alırken eyaletlerin yapay zeka düzenleme ortamını dikkate almalarını ve inovasyonu engelleyebilecek “ağır yapay zeka düzenlemeleri” olan eyaletlere yapay zeka ile ilgili federal finansmanı sınırlamalarını veya reddetmelerini emrediyor. Bu mali misilleme politikası, Kaliforniya ekonomisi ve araştırma kurumları için bir tehdit oluşturabilir.

Plan, “Yapay Zeka’nın bu erken aşamada hem eyalet hem de federal düzeyde bürokrasiye boğulamayacak kadar önemli” olduğunu belirtiyor. Yapay Zeka düzenlemesi konusundaki anlaşmazlık, aynı zamanda Trump yönetimi ile Kaliforniya arasında uzun süredir devam eden ve genellikle sertleşen bir siyasi mücadelenin de son aşaması. Yönetimin, çevre standartlarından göçmenliğe kadar çeşitli konularda Kaliforniya’nın politikalarına meydan okuma konusunda belgelenmiş bir geçmişi var ve daha önce eyaleti kötü yönetimle suçlayarak orman yangını sonrası kurtarma çalışmalarına federal yardımı kesmekle tehdit etmişti . Taraflar arasındaki bu düşmanlık örüntüsü, yapay zeka tasarısı konusundaki anlaşmazlığın politika sınırlarının ötesine geçebileceğini gösteriyor.

Temel tartışma: Yapay zeka güvenliği mi, inovasyon mu?

TFAIA , Vali Newsom’ın inovasyonu engellediği eleştirisi üzerine veto ettiği 2024 tarihli yasa tasarısının önemli ölçüde sulandırılmış bir versiyonudur . Orijinal yasa tasarısı, zorunlu üçüncü taraf denetimleri ve “kapatma anahtarı” gibi çok daha katı güvenlik önlemleri içeriyordu.

TFAIA, bir uzlaşma ürünüdür. Anthropic, bunu “kamu güvenliğini sürekli inovasyonla dengeleyen güçlü bir çerçeve” olarak adlandırıyor. Şirket ve diğer destekçiler, bunu eşit şartlar yaratan ve gelecekteki federal yasalar için uygulanabilir bir şablon sunan pragmatik bir ilk adım olarak görüyor. Girişim sermayesi şirketi Andreessen Horowitz liderliğindeki muhalifler , eyalet düzeyindeki düzenlemelerin “yeni kurulan şirketlerin üstesinden gelmek için kaynaklara sahip olmadığı 50 uyum rejiminden oluşan bir karmaşa” yarattığını savunuyor. Yapay zeka düzenlemelerinin, inovasyon için tek ve birleşik bir pazar sağlamak amacıyla yalnızca federal düzeyde ele alınması gerektiğini savunuyorlar .

TFAIA ve uluslararası AI düzenlemesi

AB Yapay Zeka Yasası

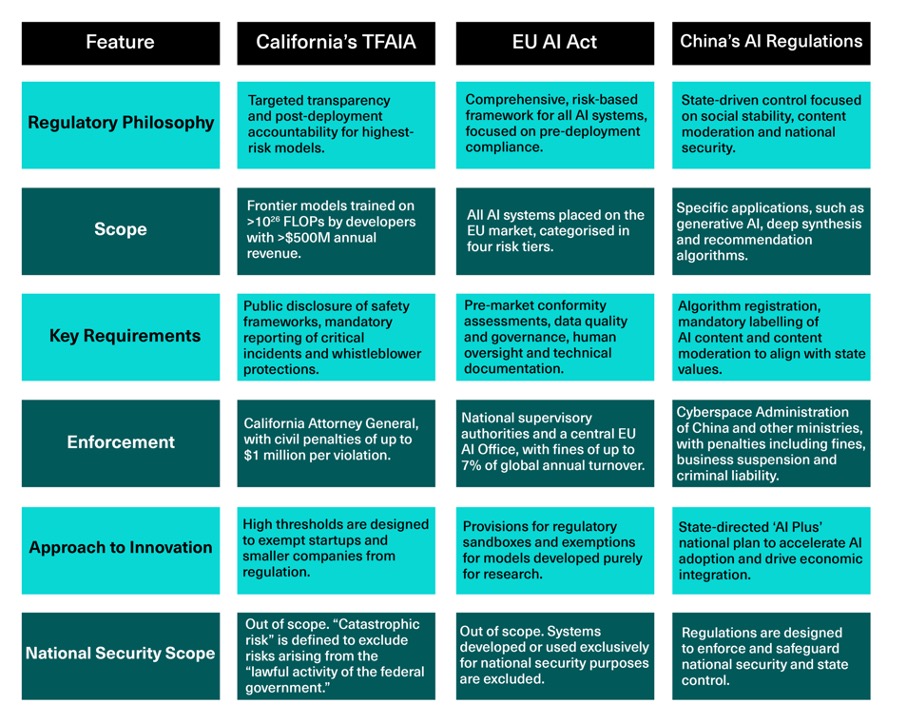

Hem Kaliforniya yasası hem de AB Yapay Zeka Yasası, yapay zeka riskini yönetmeyi amaçlasa da, temelde farklı felsefeler üzerine kuruludur. AB yasası, piyasa öncesi ağır uyumluluk yükümlülükleri getiren geniş kapsamlı, risk temelli bir çerçeve iken, TFAIA, kamuya açıklama yoluyla hesap verebilirliği önceliklendiren dar kapsamlı, dağıtım sonrası bir çerçevedir.

İki yasa arasındaki en önemli fark, şeffaflık yaklaşımında yatmaktadır. TFAIA, kamuya açık bir hesap verebilirlik modeli üzerine kurulmuştur . Temel gereksinimi, büyük ölçekli yapay zeka geliştiricilerinin kapsamlı yapay zeka güvenlik çerçevelerini web sitelerinde yayınlamalarıdır. Bu mekanizma, şirketleri güvenlik iddialarından sorumlu tutan akademik incelemeyi ve kamuoyu baskısını desteklemek üzere tasarlanmıştır.

Buna karşılık, AB Yapay Zeka Yasası, düzenleyicilere gizli raporlamayı esas almaktadır . Kapsamlı dokümantasyon ve ciddi olayların raporlanmasını zorunlu kılsa da, bu bilgiler öncelikle devlet yetkilileriyle özel olarak paylaşılmaktadır. AB’nin sistemi, denetimi eyalet içinde merkezileştirirken, Kaliforniya’nın yaklaşımı bunu halk arasında dağıtmayı amaçlamaktadır.

Bu yaklaşım farkı, yasaların katılığına da yansıyor. TFAIA’nın en üst düzey modelleri için temel gereklilikleri (10-26 FLOP eşiğinde), genel olarak AB Yapay Zeka Yasası’nın tüm genel amaçlı yapay zeka modelleri için uyguladığı temel gerekliliklerle aynıdır .

Ancak AB Yapay Zeka Yasası, “sistemik risk” oluşturduğunu belirlediği modellere (en düşük 10-25 FLOP eşiğinde) daha ağır bir düzenleyici yük getirmektedir . TFAIA tarafından zorunlu kılınanların ötesine geçen bu yükümlülükler şunlardır:

- Kapsamlı düşmanca testlerde dahil olmak üzere zorunlu model değerlendirmelerinin gerçekleştirilmesi .

- Tüm olası sistemik risklerindeğerlendirilmesi ve azaltılması .

- Düzenleyicilere özel raporlama için olayların izlenmesi ve belgelenmesi.

Bu karşılaştırma, TFAIA’nın ABD’de önemli bir emsal teşkil ettiğini gösterirken, kamuoyuna yönelik ve daha az talepkar yaklaşımının, AB’nin inovasyon ve güvenlik arasında denge kurma konusunda benimsediği daha kapsamlı modelden farklılaştığını ortaya koyuyor.

Üçüncü bir düzenleyici yaklaşım

Yapay zeka düzenlemesine yönelik üçüncü bir yaklaşım Çin’de ortaya çıkmıştır. Çin Komünist Partisi (ÇKP), öneri algoritmaları, derin sentez ve üretken yapay zeka gibi belirli teknolojiler için bir dizi hedefli, dikey düzenlemeyle karakterize edilen , devlet odaklı, güvenlik odaklı bir düzenleme modeli izlemektedir . Çin’deki düzenleyici vurgu, toplumsal istikrarı korumak, içeriği kontrol etmek ve yapay zeka gelişiminin devlet ideolojisi ve ulusal güvenlik hedefleriyle uyumlu olmasını sağlamaktır. Bu, yapay zeka tarafından üretilen tüm içeriklerin zorunlu olarak etiketlenmesi ve belirli algoritmaların devlete kaydedilmesi gibi gereklilikleri içerir.

Bu yaklaşım, yukarıdan aşağıya devlet kontrolü felsefesini yansıtsa da, uygulaması daha karmaşıktır. Uygulamada, Çin’de tek bir yapay zekâ düzenleyicisi yoktur; bunun yerine, yönetim, dağıtılmış ve giderek daha fazla örtüşen uygulama yetkilerine sahip bakanlıklar ve kurumlar ağı boyunca parçalanmıştır. Üst düzey Çin hükümet organları, koordinasyon ve yukarıdan aşağıya rehberlik sağlayarak, tüm düzenleyici çabaların ÇKP’nin daha geniş siyasi ve güvenlik hedefleriyle uyumlu kalmasını sağlar. Bu, hem AB’nin hak temelli yatay çerçevesinden hem de Kaliforniya’nın şeffaflık odaklı modelinden temelde farklı bir sistem yaratır.

Birleşik Krallık Ulusal Güvenlik Etkileri

Güvenlikte yükselen dalga: Birleşik Krallık için ikinci dereceden faydalar

TFAIA, Birleşik Krallık ve diğer müttefik ülkelerin ulusal güvenliği açısından ikinci dereceden bir fayda sağlamaktadır . Dünyanın önde gelen yapay zeka geliştiricilerine yasal bir güvenlik ve şeffaflık zorunluluğu getirerek, bu yasa, öncü yapay zeka modellerinin küresel güvenlik tabanını etkili bir şekilde yükseltmektedir.

Mekanizma basittir: TFAIA’ya uyum sağlamak için Google, OpenAI ve Anthropic gibi şirketler, geliştirme süreçlerine şeffaflık çerçeveleri ve hesap verebilirlik protokolleri entegre etmelidir. Bu gelişmiş standartlar, büyük olasılıkla bu şirketlerin küresel standart işletme prosedürlerinin bir parçası haline gelecektir. Sonuç olarak, Birleşik Krallık hükümeti veya şirketleri bu geliştiriciler tarafından oluşturulan öncü modelleri kullandığında, sistemler tasarım gereği daha şeffaf olacaktır . Başka bir deyişle, Birleşik Krallık düzenleyici bir temettü alacak ve daha yüksek bir yapay zeka şeffaflığı ve güvenliği standardından faydalanacaktır.

İngiltere düzenlemesi için bir katalizör

İngiltere’nin ABD ile imzaladığı Teknoloji Refahı Anlaşması, Trump yönetiminin benimsediği “inovasyon yanlısı” duruşla örtüşüyor. Küresel yapay zeka sektörü, yerel düzenlemeler sayesinde piyasa standardı haline gelen şeffaflık ve raporlama uygulamalarını benimsemeye başlıyor. Bu durum, Birleşik Krallık düzenleyicileri için önemli bir fırsat yaratıyor.

Önde gelen şirketler ABD pazarı için halihazırda güvenlik süreçlerine sahip olduğundan, Birleşik Krallık hükümetinin benzer açıklamalar talep etmesinin önünde önemli bir teknik veya prosedürel engel bulunmamaktadır . Bu durum, yeni bir düzenleyici yük getirmeden kritik denetime erişim için net bir yol sağlamaktadır.

Gelecekteki risklere ilişkin hesap verebilirliğin ilerletilmesi

Son olarak, TFAIA’nın güçlü ihbarcı korumaları, gelecekteki yapay zeka risklerini yönetmek için olmazsa olmaz olan daha fazla hesap verebilirliğe doğru kritik bir adım teşkil ediyor. Bu, yapay zekanın kendini katlanarak geliştirmeye başladığı ve potansiyel olarak insan kontrolünün kaybına veya tehlikeli yeni yeteneklerin hızla yaratılmasına yol açtığı bir senaryoda, özellikle otomatik yapay zeka araştırma ve geliştirmesi için hayati önem taşıyacaktır.

Yapay zekâ araştırmacıları ve mühendisleri, bu tehlikelerin erken uyarı işaretlerini fark etme konusunda benzersiz bir konumda oldukları için ilk savunma hattını oluştururlar. Muhaliflerin felaket riskleri hakkındaki iyi niyetli endişelerini bildirmeleri için açık, güvenli ve korumalı yollar oluşturmak, bir erken uyarı sistemi oluşturur . Daha geniş güvenlik topluluğu için bu, en hassas teknolojik gelişmelerin bile kabul edilemez riskler için güçlü iç hesap verebilirlik mekanizmaları gerektirdiği yönündeki yeni uluslararası fikir birliğine dayanır.

Çözüm

Kaliforniya’nın TFAIA’yı uygulaması, yeni düzenleme kapsamında geliştirilen yapay zeka sistemlerini tedarik ederken Birleşik Krallık için muhtemelen birçok ders çıkaracaktır. Dünya genelindeki hükümetler, şeffaflık ve uyumluluğun ulusal güvenlik ve yapay zeka düzenleme stratejileriyle nasıl kesiştiğini değerlendirirken, ortaya koyduğu güvenlik standartlarından yararlanabilirler. Mevzuat, sınır yapay zekasıyla ilgili risklerin zorunlu olarak bildirildiği yeni bir dönemin habercisi olabilir, küresel bir güvenlik temeli oluşturulmasına yardımcı olabilir ve bu güçlü çift kullanımlı sistemlere olan güveni artırabilir.

Bu makalede ifade edilen görüşler yazara aittir ve Alan Turing Enstitüsü’nün veya herhangi bir kuruluşun görüşlerini temsil etmemektedir.