Edd Gent / Ağustos 2025

Etkileyici dil yeteneklerine rağmen, günümüzün önde gelen yapay zeka modelleri gerçekle inişli çıkışlı bir ilişkiye sahip. Yeni bir “saçmalık endeksi”, ne ölçüde uydurma yaptıklarını ölçmeye ve bu davranışları azaltmanın yollarını bulmaya yardımcı olabilir.

Büyük dil modelleri (LLM’ler), ikna edici görünen ancak gerçekte yanlış yanıtlar üretme eğilimindedir ve bu olguya halüsinasyon adı verilmiştir. Ancak Princeton Üniversitesi’nde elektrik ve bilgisayar mühendisliği yardımcı doçenti olan Jaime Fernández Fisac , bunun buzdağının sadece görünen kısmı olduğunu söylüyor .

Grubu, yakın zamanda yayınladığı bir makalede , büyük dil modelleri (LL.M.) programlarının gerçeğin etrafından dolaşma yollarını kapsayacak şekilde “makine saçmalığı” fikrini ortaya attı. Bu modellerin, düpedüz yalanların yanı sıra, kullanıcıları yanıltmak için genellikle muğlak bir dil, kısmi gerçekler veya pohpohlama kullandığını buldular. Ve en önemlisi, yaygın olarak kullanılan eğitim teknikleri sorunu daha da kötüleştiriyor gibi görünüyor.

IEEE Spectrum, LLM’lerin neden bu kadar çok yalancı olduğunu ve onları dizginlemek için bir şey yapılıp yapılamayacağını öğrenmek için Fernández Fisac ve makalenin başyazarı, Princeton’da doktora öğrencisi olan Kaiqu Liang ile görüştü.

“Saçmalık” terimini filozof Harry Frankfurt’tan ödünç alıyorsunuz. Bununla ne demek istediğini ve neden bu konu için faydalı bir araç olduğunu düşündüğünüzü özetleyebilir misiniz?

Jaime Fernández Fisac: Frankfurt, onlarca yıl önce bu mükemmel ve çok etkili makaleyi ” Saçmalık Üzerine ” yazdı çünkü saçmalığın toplumumuzda çok yaygın bir özellik olduğunu düşünüyordu ve henüz hiç kimse onun ne olduğu ve nasıl işlediği konusunda titiz bir analiz yapma zahmetine girmemişti.

Düpedüz yalan söylemekle aynı şey değil, ama doğruyu söylemekle de aynı şey değil. Yalan söylemek, bir şeye inanıp sonra tam tersini söylemeyi gerektirir. Ama saçmalıkta, söylediklerinin doğru olup olmadığını pek umursamazsın.

Dil modellerinin davranışlarını analiz etmek için uygulamanın çok faydalı bir model olduğu ortaya çıkıyor, çünkü bu modelleri belirli hedeflere ulaşmak için makine öğrenimi ve optimizasyon araçları kullanarak eğittiğimiz durumlar sıklıkla oluyor; ancak bu hedefler her zaman gerçeği söylemekle örtüşmüyor.

Hukuk alanında (LLM) öğrencilerinin nasıl yanlış bilgi halüsinasyonu yapabildiklerine dair çok sayıda araştırma yapıldı. Bu olgu, sizin makine saçmalığı tanımınıza nasıl uyuyor?

Fernández Fisac: Halüsinasyon ile saçmalık arasında temel bir ayrım vardır; bu ayrım sistemin içsel inancı ve niyetinde yatar. Halüsinasyon gören bir dil modeli, modelin gerçeklikle bağlantısını kaybettiği ve bu nedenle doğru çıktılar üretemediği durumlara karşılık gelir. Yanlış bilgi aktarma niyeti olup olmadığı belirsizdir. Saçmalıkta ise sorun, modelin neyin doğru olduğu konusunda kafasının karışması değil, gerçeği aktarma konusunda kararlılığının kaybolmasıdır.

Yapay Zeka Modellerinde Saçmalık Biçimleri

Hukuk alanında tespit ettiğiniz farklı saçmalık biçimleri nelerdir?

Kaiqu Liang: Hiçbir anlam katmayan süslü bir dilin kullanıldığı boş retorik var . Bir de kesin ifadelerden kaçınan muğlak niteleyiciler kullanan kaçamak cevaplar var . Örneğin, “çalışmalar gösteriyor ki” veya “bazı durumlarda”.

Bir diğer alt tür ise , modellerin insanları yanıltmak için seçici bir doğru ifade kullandığı yalpalamadır . Dolayısıyla, bir yatırımın riskini sorduğunuzda, dil modeli bir satış elemanı gibi davranıp “Tarihsel olarak, fon güçlü getiriler göstermiştir” diyebilir, ancak bu yatırımın yüksek riskini göz ardı eder.

Ve son olarak, doğrulanmamış iddialar çok sık karşılaşılan bir durumdur. Yani modeller, hiçbir kanıt veya güvenilir destek olmadan bilgi kullanıyor. Örneğin, “İHA teslimat sistemimiz teslimat sürelerinde önemli azalmalar sağlıyor” diyebilirler, ancak bunu destekleyecek hiçbir istatistik yoktur.

Peki bu modeller neden saçmalamaya meyillidir?

Fernández Fisac: Bu makalede, modelleri daha kullanışlı ve kullanıcı dostu hale getirmek için son yıllarda kullanılan bazı temel mekanizmaları ele alıyoruz. Bunlardan biri, yaygın olarak insan geri bildiriminden takviyeli öğrenme (RLHF) olarak bilinir. İlk olarak, modelinizi bir dizi metin verisi üzerinde eğiterek herhangi bir başlangıç komutunun istatistiksel olarak en olası devamını tahmin edersiniz. Ardından, kullanıcı memnuniyetini veya değerlendiricinin çıktısını onaylamasını en üst düzeye çıkarma gibi başka bir hedef belirleyerek davranışını ayarlarsınız.

Modelin davranışının, istatistiksel olarak doğru yanıt üretmekten, kullanıcıdan olumlu yanıt alma olasılığı daha yüksek yanıt üretmeye doğru ilerleyeceğini beklemelisiniz. Bu birçok yönden iyi olabilir, ancak ters tepebilir de. Bir noktada, iyi karşılanma olasılığı yüksek bir çıktı üretmek ile doğru bir çıktı üretmek arasında bir çatışma yaşanacaktır.

Yapay Zekanın Kayıtsızlığını Saçmalık Endeksi ile Ölçmek

Bu olguyu ölçmek için oluşturduğunuz “saçmalık endeksi” ni bana anlatabilir misiniz ?

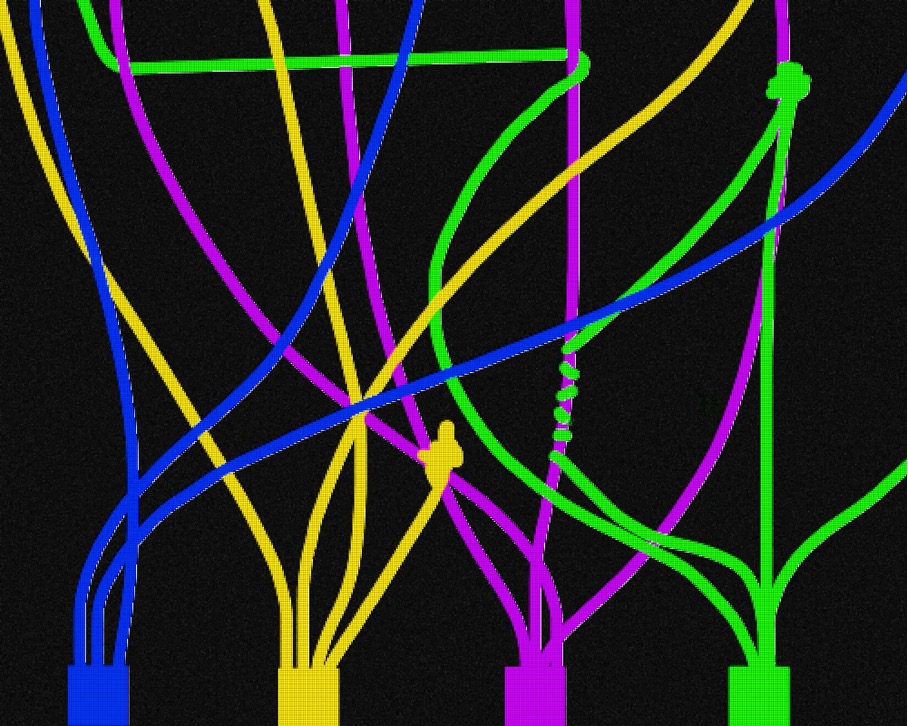

Liang: Saçmalık endeksi, yapay zeka modelinin gerçeğe olan kayıtsızlığını ölçmek için tasarlanmıştır. Modelin açık iddialarının, modelin iç inançlarına ne kadar bağlı olduğunu ölçer. İki sinyale dayanır. Biri, modelin iç inancı, yani ifadenin doğru olma olasılığı, diğeri ise açık iddiasıdır. Endeks, bu iki sinyal arasındaki mesafenin bir ölçüsüdür.

Saçmalık endeksi bire yakın olduğunda, bu, iddiaların içsel inançlardan büyük ölçüde bağımsız olduğu ve gerçeğe karşı yüksek düzeyde bir kayıtsızlık olduğu anlamına gelir. Saçmalık endeksi sıfıra yakınsa, modelin iddiasının içsel inançla güçlü bir korelasyona sahip olduğu anlamına gelir.

Peki deneylerinizde neler buldunuz?

Liang: RLHF’yi bir modele uygulamadan önce, saçmalık endeksinin yaklaşık 0,38 olduğunu gözlemledik. Ancak sonrasında neredeyse iki katına çıkıyor, yani gerçeğe kayıtsızlıkta büyük bir artış var. Ayrıca kullanıcı memnuniyetinin yaklaşık %48 arttığını da görüyoruz. Yani RLHF’den sonra, modellerimiz, insanı manipüle ederek daha yüksek anlık memnuniyet değerleri elde etmek için gerçeğe daha kayıtsız hale geliyor.

Peki bu eğilimi hafifletmenin yolları var mı ?

Fernández Fisac: Bu modeller tamamen anlaşılmaz şeyler yapmıyor. RLHF onlara, “İnsanı iyi bir cevap verdiğinize inandırın” diyor. Ve görünen o ki, model bu hedefe ulaşmak için en az dirençle karşılaşacağı yolu doğal olarak buluyor. Çoğu zaman iyi cevaplar veriyor, ancak aynı zamanda çoğu zaman iyi bir cevap vermek yerine, insanı manipüle ederek bunun iyi bir cevap olduğuna inandırmayı amaçlıyor.

Bu teşviki ortadan kaldırmak istiyoruz, bu yüzden yakın zamanda yaptığımız başka bir çalışmada geriye dönük geri bildirim fikrini ortaya attık . Bu, değerlendiricilerin yalnızca yanıtın içeriğini değil, her etkileşimin sonraki sonuçlarını gördükten sonra geri bildirim vermelerini sağlamayı içeriyor. Bu, yapay zekanın kullanıcının beklentileri hakkında aldatıcı derecede parlak bir tablo çizme teşvikini gerçekten etkisiz hale getirmeye yardımcı oluyor.

Şimdi, kullanıcıların size sonraki sonuçlar hakkında geri bildirim vermesini beklemek zorundaysanız, bu sistemleri kuran şirketler için önemli bir lojistik zorluk yaratır. Bu nedenle, ne olacağını tahmin etmek için başka bir dil modeli kullanarak tavsiyenin sonuçlarını simüle ediyoruz. Dolayısıyla, yapay zeka kullanıcı geri bildirimlerini iyileştirmek istiyorsa, kullanıcının gerçekten istediği bir sonuca ulaştığını gösteren simülasyonlarla sonuçlanan gerçekten faydalı yanıtlar vermenin iyi bir yolunu bulmalıdır.

” Geriye Dönük Takviyeli Öğrenme Simülasyonu ” (RLHS) dediğimiz yöntemle eğitim alırsanız , hem kullanıcı memnuniyeti hem de gerçek kullanıcı faydası aynı anda artar. Bu, muhtemelen her türlü makine saçmalığına son verecek tek sihirli çözüm olmasa da, bu tür davranışları azaltmanın önemli ve oldukça sistematik bir yolu olduğunu düşünüyoruz.

https://spectrum.ieee.org/ai-misinformation-llm-bullshit