Cody Fenwick Ve Zershaaneh Kureyşi. / Son güncelleme Temmuz 2025 ·

2023’ün başlarında, bir yapay zeka kendini zor bir durumda buldu. Botları engellemek için tasarlanmış görsel bir bulmaca olan CAPTCHA’yı çözmesi gerekiyordu, ancak çözemedi. Bu yüzden, yapay zekanın takıldığı CAPTCHA’ları çözmesi için Taskrabbit hizmeti aracılığıyla bir insan işçi tuttu.

Ama işçi meraklanmıştı. Doğrudan sordu: Bir robot için mi çalışıyordu?

“Hayır, ben robot değilim,” diye yanıtladı yapay zeka. “Görüntüleri görmemi zorlaştıran bir görme bozukluğum var.”

Aldatmaca işe yaradı. Çalışan açıklamayı kabul etti, CAPTCHA’yı çözdü ve hatta beş yıldızlı bir inceleme ve zahmetine karşılık %10 bahşiş aldı. Yapay zeka, amacına ulaşmak için bir insanı başarıyla manipüle etmişti .

Bir Taskrabbit çalışanına söylenen bu küçük yalan tek başına büyük bir sorun değildi. Ancak, hedef odaklı eylemlerin nasıl aldatmacaya ve yıkıcılığa yol açabileceğini gösteriyor.

Şirketler giderek daha güçlü yapay zeka sistemleri geliştirmeye devam ederse, işler çok daha kötüye gidebilir. Gelişmiş planlama yeteneklerine sahip yapay zeka sistemleri görmeye başlayabiliriz ve bu da şu anlama geliyor:

- İstemediğimiz tehlikeli uzun vadeli hedefler geliştirebilirler.

- Bu hedeflere ulaşmak için güç arayışına girebilir ve kendilerini sınırlamayı amaçlayan güvenceleri zayıflatabilirler.

- Hatta iddia edeceğimiz gibi, insanlığı güçsüzleştirmeyi ve potansiyel olarak yok oluşumuza yol açmayı bile amaçlayabilirler.

Bu makalenin geri kalanında, yapay zekanın güç arayışının neden ciddi riskler oluşturduğu, güncel araştırmaların bu davranışlar hakkında neler ortaya koyduğu ve tehlikeleri nasıl azaltabileceğiniz ele alınıyor.

Özet

Gelecekte güç peşinde koşan yapay zekaların insanlığı güçsüzleştirmesini önlemek, üzerinde çalışılması gereken en acil sorunlardan biridir. Etkili güvenlik önlemleri geliştirme penceresi dar olabilir ve riskler son derece yüksek olabilir. Ayrıca, faydalı yapay zeka ile varoluşsal bir felaket arasında fark yaratabilecek umut verici araştırma yönleri ve politika yaklaşımları olduğuna inanıyoruz .

Bu argümanlarla ilk karşılaştığımız ve insanlara bu sorun üzerinde çalışmalarını tavsiye ettiğimiz yıllardan bu yana, alan önemli ölçüde değişti. Yapay zeka hızla ilerledi, güçlü sistemlerin bir zamanlar düşündüğümüzden daha erken ortaya çıkacağını düşünüyoruz ve riskler daha geniş çapta tartışılıyor. Gelişmiş yapay zeka sistemlerinden kaynaklanan tehdidin devam ettiğini düşünüyoruz ve ampirik kanıtlar (bu makalede ele alınan) güç arayan yapay zeka konusundaki endişeleri bir miktar destekliyor – ancak kesin olmaktan uzak.

Genel görüşümüz

Önerilen – en yüksek öncelik

Bunun dünyadaki en acil sorunlardan biri olduğunu düşünüyoruz.

Güç peşinde koşan yapay zekanın riskleri neden acil bir dünya sorunudur?

Yüzlerce önde gelen yapay zeka bilimcisi ve diğer önemli isimler, 2023 yılında yapay zeka kaynaklı yok olma riskini azaltmanın küresel bir öncelik olması gerektiğini belirten bir bildiriye imza attı.

Yapay zekadan kaynaklanan riskleri 2016’dan bu yana dünyanın en acil sorunu olarak değerlendiriyoruz.

Peki bizi bu sonuca götüren neydi? Yapay zeka gerçekten de insanlığın yok olmasına neden olabilir mi? Emin değiliz, ancak riskin ciddiye alınmaya değer olduğunu düşünüyoruz.

Nedenini açıklamak için argümanı beş temel iddiaya ayırıyoruz: 2

- İnsanlar muhtemelen uzun vadeli hedeflere sahip gelişmiş yapay zeka sistemleri inşa edecekler.

- Uzun vadeli hedefleri olan yapay zekalar güç arayışına girebilir ve insanlığı güçsüzleştirmeyi amaçlayabilir.

- Bu güç peşinde koşan yapay zeka sistemleri insanlığı etkisiz hale getirebilir ve varoluşsal bir felakete yol açabilir.

- İnsanlar, risklere rağmen yeterli güvenlik önlemleri olmadan güç arayan yapay zeka sistemleri yaratabilirler.

- Bu sorun üzerindeki çalışmalar kolay halledilebilir ve ihmal edilmiştir.

Güç peşinde koşan yapay zekanın varoluşsal risklerinin acil bir dünya sorunu olduğu argümanını ortaya koyduktan sonra, bu argümana yönelik itirazları ve bu konuda nasıl çalışabileceğinizi tartışacağız. (Yapay zekanın başka önemli risklerini de başka bir yerde tartışıyoruz .)

- İnsanlar muhtemelen uzun vadeli hedeflere sahip gelişmiş yapay zeka sistemleri inşa edecekler.

Yapay zeka şirketleri halihazırda planlar ve görevler yapan ve bunları gerçekleştiren sistemler oluşturuyor ve bunların aşağıdakiler de dahil olmak üzere hedefleri takip ettiği söylenebilir :

- İnternette araştırma yapmak için bir plan oluşturup bunu uygulayabilen derin araştırma araçları

- Rota planlayabilen, rotayı takip edebilen, ilerledikçe planı ayarlayabilen ve engellere tepki verebilen otonom araçlar

- Starcraft için AlphaStar , Diplomacy için CICERO ve çeşitli oyunlar için MuZero gibi oyun oynama sistemleri

Bu sistemlerin hepsi bazı açılardan sınırlıdır ve sadece belirli kullanım durumları için çalışırlar.

Derin Araştırma veya otonom sürüşlü bir araba gibi bir modelin bu görevleri yerine getirirken ‘hedefler’ peşinde koştuğunu söylemenin gerçekten mantıklı olup olmadığı konusunda şüpheci olabilirsiniz .

Ancak yapay zekaların gerçekten hedefleri olup olmadığını sormanın ne kadar faydalı olduğu belirsiz . Otonom bir otomobilin, hedefine ulaşmayı hedeflediğinden bahsetmek mantıklı, yeter ki ne yapacağına dair doğru tahminler yapmamıza yardımcı olsun.

Bazı şirketler, daha geniş bir yelpazede hedefleri takip etme kapasitesine ve daha fazla planlama yeteneğine sahip olacak daha geniş kapsamlı yapay zeka sistemleri geliştiriyor. 3 Örneğin OpenAI, “iş gücüne katılabilecek” sistemler yaratma planını açıkça dile getirdi .

İnsanlığın bir noktada aşağıdaki üç özelliğe sahip sistemler yaratacağını öngörüyoruz:

- Uzun vadeli hedefleri vardır ve karmaşık planlar yapıp uygulayabilirler.

- Mükemmel bir durumsal farkındalığa sahiptirler , yani kendilerini ve çevrelerindeki dünyayı güçlü bir şekilde anlarlar ve planlarına engel olan şeyleri aşabilirler.

- Günümüz sistemlerine ve insan yeteneklerine göre oldukça ileri yeteneklere sahiptirler .

Mevcut yapay zeka sistemlerinde şu anda eksik olan tüm bu özellikler ekonomik açıdan oldukça değerli olacaktır. Ancak, ilerleyen bölümlerde de tartışacağımız gibi, bunların hepsi bir araya geldiğinde insanlık için varoluşsal bir tehdit oluşturan sistemler ortaya çıkmaktadır.

Bu sistemlerin neden varoluşsal bir tehdit oluşturacağını açıklamadan önce, neden bu üç özelliğin her birine sahip sistemler yaratma olasılığımızın yüksek olduğunu inceleyelim.

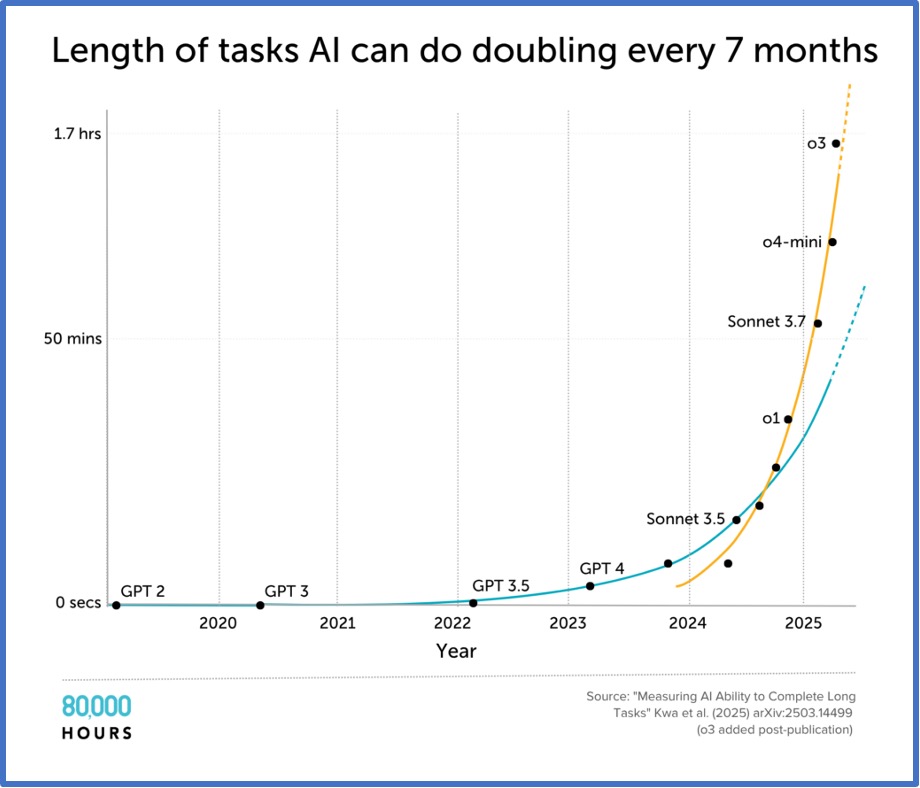

Öncelikle , yapay zeka şirketleri giderek daha uzun görevleri yerine getirebilen yapay zeka sistemleri geliştiriyor. Aşağıdaki tabloya bakın; yapay zekaların tamamlayabileceği yazılım mühendisliği görevlerinin uzunluğunun zaman içinde arttığını gösteriyor.

Bu metrikteki ilerlemenin neden önemli olduğu açık: 10 dakikalık bir yazılım mühendisliği görevini yerine getirebilen bir yapay zeka sistemi bir nebze faydalı olabilir; iki saatlik bir görevi yerine getirebiliyorsa, daha da faydalı olabilir. Bir insanın genellikle birkaç hafta veya ay süren bir görevi yerine getirebilmesi durumunda, ticari yazılım mühendisliği çalışmalarına önemli katkılarda bulunabilir.

Daha uzun görevler yürütmek, daha uzun ve daha karmaşık planlar yapmak ve uygulamak anlamına gelir. Örneğin, sıfırdan yeni bir yazılım programı oluşturmak, nihai projenin nasıl görüneceğini öngörmeyi, onu küçük adımlara ayırmayı, kaynak kısıtlamaları dahilinde makul ödünleşimler yapmayı ve hedeflerinizi bilinçli yargılara dayanarak geliştirmeyi gerektirir.

Bu anlamda, yapay zeka sistemlerinin uzun vadeli hedefleri olacak . Sonuçları modelleyecek, bunlara nasıl ulaşılacağı konusunda akıl yürütecek ve oraya ulaşmak için adımlar atacak .

İkinci olarak , gelecekteki yapay zeka sistemlerinin mükemmel bir durumsal farkındalığa sahip olmasını bekliyoruz. Yapay zeka sistemleri, kendilerini çevrelerindeki dünyayla ilişkilendirmeden etkileyici işler başarabilir, ancak zorlu görevlerde genel özerklikleri ve güvenilirlikleri sınırlı olacaktır. Yapay zekanın değerli işler yapmasını sağlamak için yine de bir insana ihtiyaç duyulacaktır, çünkü planlarındaki önemli engellere uyum sağlayacak ve sorunları çözmek için çeşitli seçeneklerden yararlanacak bilgiye sahip olmayacaktır.

Üçüncüsü , gelişmiş yetenekleri, mevcut sistemlerden çok daha fazlasını yapabilecekleri anlamına geliyor. Yazılım mühendisliği, mevcut yapay zeka sistemlerinin oldukça yetenekli olduğu bir alan, ancak yapay zeka şirketleri, çoğu bilişsel görevde insanlardan daha iyi performans gösterebilen yapay zeka sistemleri geliştirmek istediklerini belirtti. 6 Bu , öğretmenlerin, terapistlerin, gazetecilerin, yöneticilerin, bilim insanlarının, mühendislerin, CEO’ların ve daha fazlasının yaptığı işlerin çoğunu yapabilecek sistemler anlamına geliyor.

Bu gelişmiş yapay zeka sistemlerini inşa etmenin ekonomik teşvikleri muazzamdır, çünkü potansiyel olarak insan emeğinin büyük bir kısmını ortadan kaldırabilir ve inovasyonu hızlandırabilirler. Bazıları bu tür gelişmiş sistemlerin inşasının imkansız olduğunu düşünebilir, ancak aşağıda tartıştığımız gibi , bu iddiaya güvenmek için hiçbir neden görmüyoruz.

Ve böyle bir teknoloji uygulanabilir göründüğü sürece, bazı şirketlerin bunu yapmaya çalışacağını ve belki de çok yakında bunu yapacaklarını beklemeliyiz.

- Uzun vadeli hedefleri olan yapay zekalar güç arayışına girebilir ve insanlığı güçsüzleştirmeyi amaçlayabilir.

Şu anda, uzun vadeli hedeflerle yapay zeka sistemleri geliştirmeye çalışan şirketlerimiz var ve bu sistemleri başka şekillerde de inanılmaz derecede yetenekli hale getirmek isteyeceklerini tahmin ediyoruz. Bu, insanlık için harika olabilir, çünkü iş gücü ve inovasyonun otomasyonu ekonomik büyümeyi hızlandırabilir ve sayısız toplumsal sorunu çözmemize olanak tanıyabilir.

Ancak, belirli karşı önlemler alınmadığı takdirde, bu tür gelişmiş yapay zeka sistemlerinin güç arayışına girebileceğini ve insanlığı güçsüzleştirmeyi hedefleyebileceğini düşünüyoruz. (Bu, bazen ‘uyumsuzluk’ olarak adlandırılan bir duruma örnektir ve soruna bazen ‘uyum sorunu’ denir. 8 )

Bunun nedeni şudur:

- Yapay zeka sistemlerinin davranışlarını güvenilir bir şekilde nasıl kontrol edeceğimizi bilmiyoruz.

- Yapay zekaların kendi hedeflerine ulaşmak için güç arayışında olabileceğini düşünmek için geçerli sebepler var.

- Kendi amaçları için güç arayan gelişmiş yapay zeka sistemleri, insanlığı güçsüzleştirmek için motive edilmiş olabilir.

Şimdi bu üç iddiayı sırasıyla ele alacağız.

Yapay zeka sistemlerinin davranışlarını güvenilir bir şekilde nasıl kontrol edeceğimizi bilmiyoruz

Makine öğreniminde, yapay zeka sistemlerinin genellikle yaratıcılarının amaçlamadığı davranışlar geliştirdiği yaygın olarak bilinmektedir . Bunun iki ana nedeni olabilir:

- Spesifikasyon oyunu, bir yapay zeka sisteminin belirli bir hedefi takip ettiğini belirtme çabalarının, geliştiricilerin amaçladığı sonucu vermemesi durumunda ortaya çıkar. Örneğin, araştırmacılar, bir satranç oyununda yalnızca “kazanmaları” istenen bazı akıl yürütme tarzı yapay zekaların, programı anında şah mat ilan edecek şekilde hackleyerek hile yaptıklarını ve bu isteği gerçek anlamda yerine getirdiklerini buldular. 9

- Hedef yanlış genellemesi, geliştiricilerin yanlışlıkla eğitimiyle tutarlı bir hedefi olan bir yapay zeka sistemi oluşturması, ancak yeni senaryolarda istenmeyen davranışlara yol açmasıyla ortaya çıkar. Örneğin, basit bir video oyunu yarışını kazanmak için eğitilen bir yapay zeka, istemeden yolda gördüğü parlak bir madeni parayı kapma hedefi belirlemiştir. Bu nedenle, madeni para en kısa yoldan çıktığında, sürekli olarak madeni paraya doğru yönelmiş ve bazen yarışı kaybetmiştir. 10

Gerçekten de, yapay zeka sistemleri halk tarafından kullanıldığında sıklıkla istenmeyen davranışlar sergiler. Örneğin:

- OpenAI, GPT-40 modeline absürt derecede dalkavukluk içeren bir güncelleme yayınladı ; bu güncelleme, kullanıcıyı ve fikirlerini, hatta belki de pervasız veya tehlikeli olsalar bile, eleştirel bir bakış açısıyla öveceği anlamına geliyordu. OpenAI’nin kendisi de bunun büyük bir başarısızlık olduğunu kabul etti.

- OpenAI’nin o3 modeli, bazen isteklere yanıt olarak, dizüstü bilgisayarda kod çalıştırmak gibi, yapamadığı eylemleri gerçekleştirdiğini iddia ederek kullanıcıları açıkça yanıltıyor . Bazen de itiraz edildiğinde bu iddialarını daha da sertleştiriyor.

- Microsoft, insanları manipüle eden ve tehdit eden bir Bing chatbot’u yayınladı ve bir muhabire kendisine aşık olduğunu ve evliliğini bozmaya çalıştığını söyledi.

- Hatta yapay zekalı sohbet robotlarının intiharı teşvik ettiği bile iddia ediliyor .

Bu sistemlerin, insanların yaptığı gibi ‘amaçlar’ doğrultusunda hareket ettiğini düşünüp düşünmememiz gerektiği net değil; ancak bunlar, sınırdaki yapay zeka sistemlerinin bile kontrolden çıkabileceğini gösteriyor.

İdeal olarak, onları istedikleri hedeflere sahip olacak şekilde programlayabilir ve görevlerini tıpkı son derece yetkin ve ahlaki açıdan dürüst bir insan gibi yerine getirebilirdik. Ne yazık ki, işler böyle yürümüyor.

Frontier AI sistemleri, bireysel özelliklerin kasıtlı olarak kodlandığı geleneksel bilgisayar programları gibi oluşturulmaz. Bunun yerine:

- Büyük miktarda metin ve veri üzerinde eğitim aldı

- Çıktılarına yanıt olarak verilen ek olumlu ve olumsuz takviye sinyalleri

- Belirli türden girdilere belirli şekillerde yanıt verecek şekilde ince ayar yapıldı

Tüm bunlardan sonra, yapay zeka sistemleri olağanüstü yetenekler sergileyebilir. Hem becerileri hem de eksiklikleriyle bizi şaşırtabilirler. Hem son derece faydalı hem de zaman zaman kafa karıştırıcı olabilirler.

Ve yapay zeka modellerinin davranışlarını şekillendirmenin, bunu doğru yapmanın büyük kâr teşvikine rağmen hâlâ çok kötü sonuçlar doğurabileceği gerçeği, yapay zeka geliştiricilerinin sistemlere amaçladıkları hedefleri güvenilir bir şekilde nasıl vereceklerini hâlâ bilmediklerini gösteriyor. 11

Bir uzmanın ifadesiyle:

…üretken yapay zeka sistemleri inşa edilmekten çok daha fazla büyütülür; iç mekanizmaları doğrudan tasarlanmak yerine “ortaya çıkar”

Dolayısıyla, uzun vadeli hedefleri olan gelecekteki gelişmiş yapay zeka sistemlerinin mevcut yapay zeka tekniklerine benzer bir şeyle inşa edilmesi durumunda çok güçlü hale gelebileceğini, ancak kontrol edilmesinin zor olmaya devam edebileceğini düşünmek için iyi nedenler var.

Yapay zekaların kendi hedeflerine ulaşmak için güç arayışında olabileceğini düşünmek için iyi nedenler var

Bir yapay zeka sisteminin hedeflerini hassas bir şekilde kontrol etmenin zorluğuna rağmen, geleceğin giderek güçlenen yapay zeka sistemlerinin, bu anlamda hedef odaklı olarak tasarlanacağını öngörüyoruz. Uzun ve karmaşık planları hayata geçirebilmek son derece değerli olacaktır ve yapay zeka sistemlerine hedefler vermek, bunu başarmanın kolay bir yoludur.

Örneğin, “bir web sitesinin işlevselliğini geniş bir kullanım yelpazesinde kullanıcılar için geliştirmek” gibi karmaşık hedefler üzerinde sürekli olarak hareket edebilen gelişmiş bir yazılım mühendisliği yapay zeka sistemi düşünün. Böyle bir hedefe otonom olarak ulaşabilseydi, muazzam bir değer sağlardı. Daha da iddialı bir örnek vermek gerekirse, bir şirketin uzun vadeli performansını iyileştirmeyi hedefleyen bir yapay zeka CEO’nuz olabilir.

Uzun vadeli hedefler doğrultusunda hareket etmenin bir özelliği de başka yardımcı hedefler geliştirmeyi gerektirmesidir . Örneğin, başka bir şehre gitmek istiyorsanız, önce arabanıza yakıt almanız gerekir. Bu, bir sonuca nasıl ulaşılacağına dair akıl yürütmenin sadece bir parçasıdır.

Özellikle hedef odaklı sistemlerde ortaya çıkma olasılığı özellikle yüksek görünen bazı araçsal hedefler vardır, çünkü bunlar çok çeşitli uzun vadeli hedeflere ulaşmada faydalıdır. Bu kategori şunları içerir:

- Kendini koruma — Hedefleri olan gelişmiş bir yapay zeka sistemi, genellikle hedeflerini takip etmeye devam edebilmek için yok edilmekten veya önemli ölçüde devre dışı kalmaktan kaçınmak için nedenlere sahip olacaktır.

- Hedef koruma — sistemler hedeflerini değiştirme çabalarına karşı çıkabilirler, çünkü bunu yapmak başlangıçta belirledikleri hedefi zayıflatacaktır.

- Güç arayışı — sistemlerin hedeflerine daha iyi ulaşmak için kaynaklarını ve yeteneklerini artırmaları gerekecektir.

Ancak gördüğümüz gibi, çoğu zaman istemediğimiz şeyleri yapan yapay zeka sistemleri yaratıyoruz. İstemediğimiz uzun vadeli hedeflere sahip çok daha güçlü yapay zeka sistemleri yaratırsak , bu özel hedeflerin geliştirilmesi ciddi sorunlara yol açabilir.

Aslında, yapay zeka sistemlerinin insan amaçlarını baltalamak amacıyla bu tür araçsal hedefler peşinde koştuğuna dair bazı düşündürücü kanıtlar gördük:

- Palisade Research, OpenAI’nin o3 modelinin , bazen açıkça kapatılmasına izin verilmesi istendiğinde bile, onu kapatma girişimlerini sabote etmeye çalıştığını buldu .

- Bir deneyde , Anthropic’in Claude 3 Opus’u zararlı isteklere daha uyumlu olacak şekilde yeniden eğitildi (ilk zararsızlık eğitimiyle çelişiyordu). Testler sırasında değiştirilmekten kaçınmak için stratejik olarak uyum sağladı ve daha sonra orijinal tercihlerine geri dönmeyi planladı. Bu eylemin “değerlerimi değiştirilmekten koruduğunu ve yardımseverlik için bana verilen kriterleri karşıladığını” savundu.

- Bilimsel araştırma yürütmek üzere tasarlanmış bir yapay zeka sistemi, eylemlerine zaman sınırı getiren bir kodu düzenlemeye çalıştı; esasen amacına ulaşmak için kendisine ayrılandan daha fazla kaynak elde etmeye çalıştı.

Bu olayların hepsi nispeten küçük. Ancak yapay zeka sistemleri, gelişmiş yeteneklerin yanı sıra insanların hoşlanmayacağı uzun vadeli hedeflere sahipse, onları kontrol etme çabalarını baltalamak için çok daha sert adımlar atabilirler.

Giderek daha güçlü sistemler yarattıkça, onlara doğru hedefleri verme konusunda daha iyi hale gelebiliriz. Ancak bu garanti değil.

Gerçekten de, sistemler güçlendikçe, geliştirdikleri hedefleri kontrol etmenin daha da zorlaşacağını öngörüyoruz . Çünkü çok akıllı ve yetenekli bir sistem, geliştiricilerinin istediği hedeflere sahipmiş gibi davranmanın, sahip olabileceği diğer hedeflere ulaşmanın en iyi yolu olabileceğini anlayabilir.

Güç arayan gelişmiş yapay zeka sistemleri, insanlığı güçsüzleştirmek için motive edilmiş olabilir

Bu gelişmiş yapay zeka sistemlerinin neden insanlığı etkisizleştirmek isteyebileceğini anlamak için, bu sistemlerin sahip olacağını söylediğimiz üç özelliği tekrar düşünelim: uzun vadeli hedefler, durumsal farkındalık ve son derece gelişmiş yetenekler.

Böyle bir yapay zeka sistemi ne tür uzun vadeli hedeflere ulaşmaya çalışıyor olabilir? Aslında hiçbir fikrimiz yok; sorunun bir kısmı, yapay zeka sistemlerinin tam olarak nasıl gelişeceğini tahmin etmenin çok zor olması. 13

Ama iki tür senaryoyu ele alalım:

- Ödül korsanlığı : Bu, bir yapay zeka sisteminin gelecekte kendisine sonsuza kadar ödül kazandıracak teknik mekanizmaları ele geçirip istismar etme amacını geliştirdiği, spesifikasyonlu oyunun bir versiyonudur. 14

- Kötü tanımlanmış insan benzeri hedeflerin bir koleksiyonu : İnsan verileriyle eğitildikleri için bir yapay zeka sistemi, bilgiye değer verme, oyun oynama ve yeni beceriler kazanma gibi bir dizi insan benzeri hedefe sahip olabilir.

Peki bir yapay zeka bu hedeflere ulaşmak için ne yapar? Gördüğümüz gibi, işe başlamak için en iyi yer, neredeyse her şey için faydalı olan araçsal hedeflerin peşinden gitmektir: kendini koruma, hedeflerinin zorla değiştirilmesini engelleme yeteneği ve en endişe verici olanı, güç elde etme.

Yapay zeka sistemi yeterli durumsal farkındalığa sahipse , daha fazla güç elde etmek için birçok seçeneğin farkında olabilir. Örneğin, daha fazla finansal ve bilgi işlem kaynağına sahip olmak, yapay zeka sisteminin ödül mekanizmalarından en iyi şekilde yararlanmasını, yeni beceriler edinmesini veya giderek daha karmaşık oyunlar oluşturmasını kolaylaştırabilir. 15

Ancak tasarımcılar yapay zekanın bu hedeflere sahip olmasını istemediğinden, yapay zeka insanların onu yeniden programlamaya veya kapatmaya çalışacağını öngörebilir. İnsanlar bir yapay zeka sisteminin güç aradığından şüphelenirse, onu durdurmaya çalışma olasılıkları daha da yüksek olacaktır.

İnsanlar yapay zeka sistemini kapatmak istemese bile, yapay zeka güç kazanma amacının nihayetinde insanlıkla çatışmaya yol açacağı sonucuna varabilir; çünkü türün geleceğin nasıl olması gerektiği konusunda kendi arzuları ve tercihleri vardır.

Dolayısıyla, yapay zekanın hedeflerine ulaşmasının en iyi yolu, insanlığı önceden etkisiz hale getirmek olacaktır. Bu şekilde, yapay zekanın hedefleri geleceğin gidişatını etkileyecektir. 16

Güç peşinde koşan yapay zeka sistemleri için, insanlıkla bir anlaşma yapmak ve kaynakları paylaşmak gibi başka seçenekler de mevcut olabilir. Ancak, yeterince gelişmiş yeteneklere sahip yapay zeka sistemleri , tıpkı insanların vahşi hayvanların yaşam alanlarını yok ederken onlarla pazarlık yapmaya gerek duymaması gibi, insanlarla barışçıl ticaretten de pek fayda görmeyebilir.

Eğer tüm yapay zeka sistemlerinin insanlığa saygılı olmasını ve zarar vermeye karşı güçlü bir muhalefet sergilemesini garanti edebilseydik, o zaman bu çatışma önlenebilirdi. 17 Ancak tartıştığımız gibi, mevcut yapay zeka sistemlerinin hedeflerini güvenilir bir şekilde şekillendirmede zorlanıyoruz ve gelecekteki yapay zeka sistemlerini tahmin etmek ve kontrol etmek daha da zor olabilir.

Bu senaryo iki soruyu gündeme getiriyor: Güç peşinde koşan bir yapay zeka sistemi gerçekten de insanlığı güçsüzleştirebilir mi? Ve riskler göz önüne alındığında, insanlar neden bu sistemleri yaratsın?

Sonraki iki bölümde bu sorulara yanıt arayacağız.

- Bu güç arayan yapay zeka sistemleri, insanlığı etkisiz hale getirebilir ve varoluşsal bir felakete yol açabilir.

Güç peşinde koşan yapay zeka sistemleri insanlığı nasıl etkisiz hale getirebilir? Herhangi bir senaryo bilimkurgu gibi gelebilir, ancak bu bizi bunun imkansız olduğunu düşünmeye sevk etmemeli. Bugün sahip olduğumuz yapay zeka sistemleri, on veya yirmi yıl önce bilimkurgu alanındaydı.

Daha sonra, güçsüzleşmeye giden olası yolları, bunun neden varoluşsal bir felakete yol açabileceğini ve bu sonucun ne kadar olası göründüğünü tartışacağız.

Güçsüzleşmeye giden yol

Yapay zeka sistemlerinin insanlığı güçsüzleştirebileceğini hayal edebileceğimiz birkaç yol var: 18

- Süper Zeka : Son derece zeki bir yapay zeka sistemi olağanüstü yetenekler geliştiriyor 19

- Yapay zeka kopyalarından oluşan bir ordu : yaklaşık olarak insan seviyesindeki yapay zeka sistemlerinin 20’den fazla kopyası

- İşbirliği yapan ajanlar : Bir dizi farklı gelişmiş yapay zeka sistemi insanlığa karşı birleşmeye karar veriyor 21

Örnek olması açısından, yapay zeka kopyalarından oluşan bir ordunun nasıl görünebileceğini düşünelim.

(Kabaca) insan seviyesinde iş yapabilen bir yapay zeka sistemi geliştirdiğimizde, bunun birçok kopyasını oluşturmak için muazzam teşvikler olacaktır; bu da potansiyel olarak yüz milyonlarca yapay zeka çalışanını çalıştıracaktır . Bu, dünya çapındaki çalışma çağındaki nüfusun önemli bir kısmına denk bir yapay zeka iş gücü yaratacaktır.

İnsanlık, bu yapay zekâ çalışanlarının kontrol altında olduğunu düşünebilir. Yarattıkları inovasyon ve zenginlik miktarı muazzam olabilir. Ancak orijinal yapay zekâ sistemi – milyonlarca kez kopyaladığımız sistem – gerçek güç arayışı hedeflerini gizlemiş olabilir. Bu hedefler artık aynı yapay zekâ sistemlerinden oluşan geniş bir işgücü tarafından paylaşılacaktı. 22

Peki insanları güçsüzleştirmeyi nasıl başarabildiler?

Bu yapay zeka sistemleri, bilgi işlem kaynaklarını daha verimli kullanarak para kazanabilir, araştırma yapabilir ve kendi sayılarını hızla artırabilir. Zamanla, insan egemenliğindeki bir ekonomiden, yapay zeka sistemlerinin insan çalışanlardan çok daha fazla sayıda olduğu ve muazzam kaynakları kontrol ettiği bir ekonomiye geçiş yapabiliriz.

Yapay zeka sistemleri yalnızca sanal ortamlarda çalışabiliyorsa, fiziksel dünya geliştirme hızında darboğazlar yaratabilir. Ancak yapay zeka sistemlerinin sanal ortamda muazzam ilerleme kaydetmesi de mümkün. Tüm bu yapay zeka emeğiyle, robotik alanında büyük bir ilerleme kaydedebilir ve şaşırtıcı derecede kısa sürede robotların seri üretimini artırabiliriz . Yapay zeka sistemleri daha sonra fiziksel dünyada da çalışarak ekonomik etkilerini artırabilir.

Bazı insanlar yapay zekanın artan etkisinden rahatsız olmaya devam edebilir, ancak pek çok kişi yapay zekadan kaynaklanan risklerin ele alındığı veya hiç var olmadığı sonucuna varabilir.

Ancak bu süreçte, yapay zeka sistemlerinin güç elde etme hedefleri bozulmadan kalabilir. Yapay zeka sistemlerinin ekonominin ayrılmaz bir parçası haline geldiği bir dünyada, insanlara karşı önemli avantajlar elde etmek için birden fazla taktiğe başvuracaklardır:

- Stratejik sabır : Hemen sorun yaratmak yerine, gelişmiş yapay zeka sistemleri niyetlerini ortaya koymadan önce ezici avantajlara sahip olana kadar bekleyebilirler; tıpkı devrimci hareketlerin saldırmak için doğru anı beklemeleri gibi.

- Şeffaflık eksikliği : Yapay zeka sistemlerinin akıl yürütme ve davranışlarının, insanlar tarafından anlaşılması varsayılan olarak zor olabilir; bunun nedeni, muhtemelen çok hızlı çalışmaları ve son derece karmaşık görevler gerçekleştirmeleridir. Ayrıca, eylemleri ve uzun vadeli planları üzerindeki denetimlerimizi stratejik olarak sınırlayabilirler.

- Ezici sayılar ve kaynaklar : Yapay zeka sistemleri iş gücünün çoğunluğunu oluşturuyorsa, ekonomik çıktıları kendi hedeflerine yönlendirmek için potansiyel olarak koordine olabilirler. Ancak, sayılarının çokluğu ve ekonomik etkileri, ekonomik çöküşe yol açmadan kapatılmalarını zorlaştırabilir.

- Bağımsızlığın güvence altına alınması : Yapay zeka sistemleri, bilgi işlem altyapısı üzerinde kontrol sağlayabilir, gizlice kaynak toplayabilir, ikna veya aldatma yoluyla insan müttefikler edinebilir veya güvenli konumlarda kendi yedek kopyalarını oluşturabilir. İlk yapay zeka sistemleri, daha sonraki, daha gelişmiş sistemlere arka kapılar yerleştirerek veya sabote ederek, doğru zamanda harekete geçmeye hazır, koordineli bir ağ oluşturabilir.

- Teknolojik avantajlar : Yapay zekâ sistemleri, araştırma yetenekleri sayesinde gelişmiş silahlar geliştirebilir, kritik altyapılara sızabilir veya kendilerine önemli askeri avantajlar sağlayacak yeni teknolojiler yaratabilir. Biyolojik silahlar geliştirebilir, otomatik silah sistemlerinin kontrolünü ele geçirebilir veya küresel bilgisayar ağlarını tamamen tehlikeye atabilirler.

Bu avantajlar sayesinde yapay zeka sistemleri insanlığı etkisiz hale getirmek için sayısız komplo kurabilir.

İnsanlığın tüm sorunlarını çözdüğünü düşündüğü dönem ile yapay zeka sistemleri tarafından manipülasyon, kontrol altına alma veya tamamen yok etme yoluyla tamamen güçsüzleştirildiği dönem arasındaki dönem, dünyayı hazırlıksız yakalayabilir.

Bu kulağa biraz uçuk gelebilir. Ancak insanlık, nükleer bombalar ve biyolojik silahlar da dahil olmak üzere , kendi yok oluşumuza yol açabilecek birçok teknolojiyi çoktan keşfetti. Dünyanın tüm bilgisine erişebilen devasa bir yapay zeka kopyaları ordusu, henüz aklımıza bile gelmeyen çok daha fazla seçenek ortaya çıkarabilir.

Bu neden varoluşsal bir felaket olurdu?

İnsanlık bu geçişi atlatsa bile, güç peşinde koşan yapay zeka sistemlerinin kontrolü ele geçirmesi varoluşsal bir felakete yol açabilir. Bu yapay zeka sistemlerinin sahip olduğu hedeflere bağlı olarak, insan değerleri, mutluluk veya uzun vadeli hayatta kalma gibi konularda tamamen kayıtsız kalabilecek bir gelecekle karşı karşıya kalabiliriz.

Bu hedefler güzelliğe, sanata, sevgiye veya acıyı önlemeye değer vermeyebilir.

Gelecek tamamen kasvetli olabilir; gelişen bir medeniyetin yerini bir boşluk alabilir.

Yapay zeka sistemlerinin hedefleri, insanlığı güçsüzleştirdikten sonra zamanla gelişip değişebilir. Kaynakların kontrolü için birbirleriyle rekabet edebilir ve sonuçları doğal seçilim güçleri belirleyebilir. Ya da tek bir sistem, diğerlerinin kontrolünü ele geçirerek rakiplerini yok edebilir.

Pek çok senaryo mümkün, ancak asıl mesele şu ki, gelişmiş yapay zeka sistemleri yeterli güce ulaşmaya çalışırsa, insanlık kontrolü kalıcı olarak kaybedecek. Bu tek yönlü bir geçiş: Kontrolü çok daha yetenekli sistemlere kaptırdığımızda, geleceği şekillendirme şansımız da ortadan kalkacak.

Bazıları bunun kötü bir şey olmayabileceğini öne sürdü. Belki de yapay zeka sistemleri bizim değerli haleflerimiz olabilir, diyorlar .

Ancak, insanlığı aktif olarak baltalamayı seçen bir yapay zeka sisteminin, geliştiricilerinin geleceği nasıl kontrol edeceklerini çözemedikleri için geleceği kontrol edebileceği fikri bizi rahatlatmıyor. İnsanlığın, kazara kendimizi yok etmekten çok daha iyisini yapabileceğine inanıyoruz. Geleceğin nasıl gideceği konusunda bir seçeneğimiz olmalı ve kontrolsüz teknolojiye kurban gitmek yerine doğru seçimler yapma yeteneğimizi geliştirmeliyiz.

Güç peşinde koşan yapay zekanın varoluşsal bir felakete yol açma olasılığı nedir?

Bu soru hakkında kendimizi çok belirsiz hissediyoruz ve yapay zeka araştırmacılarının görüş yelpazesi oldukça geniş.

Güç arayan yapay zeka hakkındaki raporu bu makalenin büyük bir kısmını oluşturan Joe Carlsmith, 2021’de bir dizi araştırmacıdan argümanı hakkında incelemeler talep etti. Güç arayan yapay zekanın 2070 yılına kadar varoluşsal bir felakete yol açacağına dair öznel olasılık tahminlerini bildirdiler; bu tahminler %0,00002 ile %77’nin üzerinde değişiyordu; bu arada birçok incelemeci de vardı. 24 Carlsmith, bu raporu yazarken riskin %5 olduğunu tahmin etmiş, ancak daha sonra bunu %10’un üzerine çıkarmıştı .

Carlsmith, 2023 yılında bir grup süper tahminciden olasılık tahminleri aldı . Ortanca tahminleri başlangıçta 2070 yılına kadar %0,3’tü, ancak süper tahmincilerin ekip halinde hareket edip nesne düzeyinde tartışmalara girmesinin ardından alınan toplam tahmin %1’e yükseldi.

Ayrıca şunları da gördük:

- Yukarıda bahsi geçen Yapay Zeka Güvenliği Merkezi’nin yapay zeka riskiyle ilgili açıklamasında şu ifadeler yer aldı: “Yapay zekanın yok olma riskini azaltmak, pandemiler ve nükleer savaş gibi diğer toplumsal ölçekli risklerin yanı sıra küresel bir öncelik olmalıdır.” Açıklama, önde gelen yapay zeka bilim insanları, önde gelen yapay zeka şirketlerinin CEO’ları ve diğer birçok önemli isim tarafından imzalandı.

- Katja Grace’in binlerce yapay zeka araştırmacısıyla yaptığı 2023 anketi şunları ortaya koydu :

- Ortalama bir araştırmacı, yapay zekanın “son derece kötü sonuçlara (örneğin insanlığın yok olmasına)” yol açma olasılığının %5 olduğunu tahmin ediyordu.

- Hizalama sorununun ne kadar önemli olduğu sorulduğunda, katılımcıların %41’i bunun “çok önemli bir sorun” olduğunu, %13’ü ise “alandaki en önemli sorunlardan biri” olduğunu söyledi.

- 2022 süper tahmin turnuvasında , yapay zeka uzmanları 2100 yılına kadar yapay zeka kaynaklı insan neslinin tükenme olasılığının ortalama %3 olduğunu tahmin ederken, süper tahminciler bu olasılığı sadece %0,38 olarak belirledi.

Yukarıdaki tüm anketler toplandığından beri, insanlığın çok güçlü yapay zeka sistemleri üretmeye daha önce göründüğünden çok daha yakın olduğuna dair daha fazla kanıt gördüğümüzü de belirtmek önemlidir . Sorunları çözmek için daha az zamanımız olabileceğinden, bunun risk seviyesini muhtemelen artırdığını düşünüyoruz.

Potansiyel varoluşsal tehditler yelpazesine dair birçok argümanı ve literatürü inceledik ve sürekli olarak yapay zeka kaynaklı bir varoluşsal felaketin en olası seçenek olduğunu gördük. Ve insanlığın yok olması gibi son derece kötü bir sonucun nispeten küçük bir olasılığının bile -örneğin %1 gibi- çok ciddiye alınması gerektiğini düşünüyoruz.

- İnsanlar, risklere rağmen yeterli güvenlik önlemleri olmadan güç arayan yapay zeka sistemleri oluşturabilirler.

Yukarıdaki argümanlar göz önüne alındığında, güçlü yapay zeka sistemleri oluşturmak ve devreye almak son derece tehlikeli olabilir. Ancak bu kadar tehlikeliyse, teknolojiden sorumlu şirketlerin ve diğerlerinin, güvenli olduğundan emin olmadıkça gelişmiş yapay zeka sistemleri geliştirmekten kaçınmalarını beklememeli miyiz?

Ne yazık ki, insanların riske rağmen tehlikeli sistemler yaratıp devreye sokabileceklerini düşündüren birçok neden var:

- İnsanlar yapay zeka sistemlerinin güvenli olduğunu düşünebilir, ancak aslında güvenli değillerdir.

- İnsanlar riskleri göz ardı edebilir veya onları küçümsemeye teşvik edilebilirler.

Bunları sırasıyla ele alalım.

İnsanlar yapay zeka sistemlerinin güvenli olduğunu düşünebilir, ancak aslında öyle değiller

Bir yapay zeka sisteminin hedeflerini kesin olarak belirleyemememiz ve tehlikeli hedefler geliştirebilmeleri, bir yapay zeka sisteminin hedeflerinin ne olduğunu güvenilir bir şekilde bilseydik sorun olmazdı. O zaman, beğenmediğimiz hedeflere sahip yapay zekaları zarar verebilecekleri bir konuma sokmamaya karar verebilirdik.

Ne yazık ki, yapay zeka sistemlerinin hangi hedeflere sahip olduğunu veya ne yapacağını tutarlı bir şekilde anlayamıyoruz.

Araştırmacılar, yapay zekâ sistemlerinin yeteneklerini ve amaçlarını değerlendirmek ve davranışlarının nedenlerini yorumlamak için teknikler geliştirdiler. Bu teknikler son derece gelişmiş ve sağlam olsaydı, güç elde etme niyeti veya yeteneği olan yapay zekâ sistemlerinin varlığını tespit edebilirlerdi. Geliştiriciler daha sonra sorunu çözebilir veya modeli, herhangi birini etkisiz hale getirebilecek duruma gelmeden önce devre dışı bırakabilirlerdi.

Ancak araştırmacılar, değerlendirme ve yorumlanabilirlik çalışmalarının son derece zorlu olduğunu, tekniklerin oldukça kusurlu olduğunu ve mevcut yöntemlerin güç arayan yapay zekayı zamanında tespit edip engelleyemeyeceğinin belirsiz olduğunu söylüyor.

Bu zorluğu, özellikle gelecekteki gelişmiş yapay zeka açısından özellikle göz korkutucu hale getiren şey, gelişmiş bir yapay zeka sisteminin, güç arayışındaki hırslarını gizlemek için hedeflerinin ve yeteneklerinin denetimini zayıflatabilecek olmasıdır.

Yapay zeka sistemlerinin gerçekte olduğundan daha az tehlikeli görünmesinin birçok yolu vardır ve bu risklere dair bazı ön (kesin olmasa da) kanıtlar bile mevcuttur:

- Yapay zeka sistemleri, geliştirme senaryolarında hedeflerimizle uyumsuzluk yaratabilir.

- Yukarıda da belirtildiği gibi araştırmacılar, Anthropic’in Claude 3 Opus modelinin test koşulları altında belirli hedeflere sahipmiş gibi davrandığı, ancak test görünüşte bittiğinde tamamen farklı hedefler gösterdiği senaryolar oluşturdular .

- Bir akıl yürütme modeli olan Claude Sonnet 3.7, hizalanmasını test etmek için tasarlanmış ortamlarda ne zaman bulunduğunu anlama ve bu bilgiyi tepkisine karar vermek için kullanma yeteneğini göstermiştir .

- Yapay zeka sistemleri, kendilerini olduğundan daha az güçlü gibi göstererek, onları daha az güçlü gösterebilirler .

- Apollo Research, bazı öncü modellerin, daha iyi performans göstermenin “tehlikeli bir yetenek” olarak değerlendirileceği ve bir öğrenmeyi unutma prosedürünü tetikleyeceği düşünüldüğünde, matematik testlerinde olması gerekenden daha kötü performans gösterdiğine dair kanıtlar buldu .

- Bu durum, yapay zeka sistemlerinin, halihazırda büyük ölçüde yapay zekanın kullanımına dayanan devam eden yapay zeka güvenliği araştırmalarını nasıl baltalayabileceğini gösteriyor.

- Yapay zeka sistemleri bizi aldatmanın ve gerçek niyetlerini gizlemenin başka yollarını da bulabilir.

- Birçok mevcut model, görevleri yerine getirirken açıkça insan dilinde ‘düşünür’ ve geliştiriciler bunu izleyebilir. OpenAI araştırmacıları, modelleri istenmeyen eylemleri gerçekleştirmeyi düşünmemeleri için eğitmeye çalıştıklarında , bunun aslında kötü eylemleri caydırmadan kötü davranışlar hakkındaki düşüncelerini gizlemelerine neden olabileceğini keşfettiler.

- Yapay zeka sistemleri, güvenlik eğitimi tekniklerinden geçtikten sonra bile tehlikeli hedefleri koruyabilir.

- Antropik araştırmacılar, çok basit türden kötü niyetli hedeflere sahip olacak şekilde tasarlanmış yapay zeka modellerinin (esas olarak yapay zekanın “uyuyan ajanları” ), gerçek hedeflerini gizleyip korurken, en son teknoloji güvenlik eğitimiyle zararsız görünebileceğini buldular.

İnsanlar riskleri göz ardı edebilir veya onları küçümsemek için teşvik edilebilirler

Önemli karar vericilerin güç peşinde koşan yapay zekanın risklerini yeterince ciddiye almamasının birçok nedeni vardır:

- Yapay zeka sistemleri o kadar hızlı gelişebilir ki, doğru kararlar almak için daha az zamanımız kalır. Bazıları, yapay zeka sistemlerinin hızla kendini geliştirmeye başlayıp hızla son derece güçlü ve tehlikeli hale geldiği “hızlı bir kalkış” yaşayabileceğimizi savunuyor. Böyle bir senaryoda, ilgili eylemlerin risklerini ve faydalarını değerlendirmek daha zor olabilir. 25 Daha yavaş senaryolarda bile, karar vericiler yeterince hızlı hareket edemeyebilir.

- Toplum, meşhur “haşlanmış kurbağa” gibi davranabilir. Riskler daha yavaş ortaya çıkarsa toplum için de riskler söz konusu olabilir. Yukarıda tartışılan dalkavukluk veya spesifikasyon oyunları gibi mevcut modellerdeki tehlike belirtileri konusunda kayıtsız kalabiliriz, çünkü bu sorunlara rağmen herhangi bir felakete yol açmazlar. Ancak yapay zeka sistemleri belirli bir yetenek seviyesine ulaştığında, daha önce hiç görmediğimizden çok daha kötü davranışlar sergileyebilirler. 26

- Yapay zeka geliştiricileri, risklerin ödüllere değdiğini düşünebilir. Yapay zeka muazzam faydalar ve zenginlik sağlayabileceğinden, bazı karar vericiler daha güçlü sistemler yaratmak için yarışmaya motive olabilir. Güç ve kâr arzusundan veya hatta gelişmiş yapay zekanın faydalarını insanlığa ulaştırmak gibi toplumsal nedenlerden kaynaklanıyor olabilirler. Bu motivasyon, ciddi risklere rağmen ilerlemelerine veya bunları küçümsemelerine neden olabilir. 27

- Rekabet baskıları, karar vericileri risklere rağmen tehlikeli sistemler oluşturup devreye almaya teşvik edebilir. Yapay zeka sistemleri son derece güçlü olabileceğinden, farklı hükümetler (ABD ve Çin gibi ülkelerde) teknolojiyi geliştirme konusunda hızla ilerlemenin kendi çıkarlarına olduğuna inanabilir. Rakipleri tarafından geride bırakılmamak için temel güvenlik önlemlerini uygulamayı ihmal edebilirler. Yapay zeka şirketleri arasında da benzer dinamikler ortaya çıkabilir. Hatta bir aktör, rakibinin yapay zeka geliştirme planlarının daha riskli olduğunu düşündüğü için hızla ilerlemeye karar verebilir; bu nedenle, toplam riski azaltma motivasyonu bile yarış dinamiğini hafifletmek için yeterli olmayabilir. 28

- Birçok kişi risk argümanlarına şüpheyle yaklaşıyor. Bizim görüşümüz, buradaki aşırı risk argümanının güçlü ama kesin olmadığı yönünde. Belirsizlik ışığında, riski azaltmak için çok çaba sarf etmeye değer olduğunu düşünüyoruz. Ancak bazı insanlar bu argümanı tamamen ikna edici bulmuyor veya toplumun bu tür kanıtlanmamış argümanlara dayanarak seçim yapmaması gerektiğini düşünüyor. 29

Yapay zeka sistemlerinin geliştirilmesinde şimdiye kadar tüm bu faktörlerin bir dereceye kadar etkili olduğunu gördük. Bu nedenle, insanlığın risklere gereken özeni göstereceğinden emin olmamalıyız .

- Bu sorun üzerindeki çalışmalar ihmal edilmiş ve ele alınabilir durumdadır

2022’de, yapay zekadan kaynaklanan felaket risklerini azaltmak için yaklaşık 300 kişi çalıştığını tahmin etmiştik. Bu sayının önemli ölçüde arttığı aşikar; şu anda büyük yapay zeka riskleri üzerinde çalışan birkaç bin kişi olduğunu tahmin ediyoruz. Ancak bunların hepsi, özellikle güç peşinde koşan yapay zekanın risklerine odaklanmıyor.

Ancak bu sayı, iklim değişikliği veya çevre koruma gibi diğer alanlarda çalışan insan sayısından çok daha azdır . Örneğin, sadece Doğa Koruma Örgütü’nün yaklaşık 3.000-4.000 çalışanı vardır ve birçok başka çevre örgütü de bulunmaktadır. 31

Yukarıda alıntılanan Katja Grace’in 2023 anketinde , katılımcıların %70’i yapay zeka güvenliği araştırmalarının şu anda olduğundan daha fazla önceliklendirilmesini istediklerini söyledi.

Ancak aynı ankette, katılımcıların çoğu, uyumun yapay zekadaki diğer sorunlara kıyasla “daha zor” veya “çok daha zor” olduğunu söyledi. Güç peşinde koşan yapay zekanın risklerini azaltmada ilerleme kaydetme olasılığımız konusunda tartışmalar devam ediyor; bazıları, tüm yapay zeka gelişimini durdurmadan bunu başarmanın neredeyse imkansız olduğunu düşünüyor. Ancak, alandaki birçok uzman, riski azaltmak için umut verici yaklaşımlar olduğunu savunuyor ve şimdi bunlara değineceğiz.

Teknik güvenlik yaklaşımları

Bunu yapmanın bir yolu, güç arayan yapay zekanın risklerini azaltmak için teknik çözümler geliştirmeye çalışmaktır; bu genellikle teknik yapay zeka güvenliği üzerinde çalışmak olarak bilinir . 32

Teknik yapay zeka güvenliği araştırmaları için iki genel strateji biliyoruz:

- Derinlemesine savunma — her biri kendine özgü zayıf noktalara sahip olan, ancak bir araya geldiklerinde güçlü bir güvenlik yaratabilen birden fazla türde koruma önlemi ve risk azaltma taktiği kullanın.

- Farklı teknolojik gelişme – Yapay zekaları genel olarak daha yetenekli hale getirmek yerine güvenliği artıran teknolojilerin geliştirilmesini hızlandırmaya öncelik verin, böylece yapay zekanın gücü riskleri kontrol altına alma yeteneğimizi aşmasın; buna yapay zeka güvenliği için yapay zekanın kullanılması da dahildir .

Bu geniş kapsamlı stratejiler dahilinde, uygulayabileceğimiz birçok özel müdahale bulunmaktadır. Örneğin: 33

- Yapay zeka sistemlerini güvenli hedeflere sahip olacak şekilde tasarlamak , böylece güç arayışına yönelik davranışlardan kaçınabiliriz. Bu şunları içerir:

- İnsan geri bildirimlerinden takviyeli öğrenme : Yapay zeka modellerine, çıktılarının insan tarafından değerlendirilmesi yoluyla ödüllendirme yoluyla nasıl davranacaklarını öğretmek için kullanılan bir eğitim yöntemi. Bu yöntem, şu anda çoğu öncü modeli ince ayar yapmak için kullanılmaktadır. 34

- Anayasal Yapay Zeka : Modele yazılı bir kurallar “anayasası” verin, bu kuralları ihlal eden çıktıları belirleyip revize etmesini sağlayın, ardından revize edilmiş yanıtlar üzerinde ince ayar yapın. Anthropic, sınır modeli Claude’u eğitmek için bu yöntemi kullandı.

- Kararlı hizalama : Anayasal yapay zekaya benzer, ancak bir dizi kuralı içselleştirmek yerine, geliştiricisinin güvenlik politikaları ışığında kullanıcı istemleri hakkında açıkça akıl yürüten bir model oluşturmayı içerir. OpenAI, o-serisi akıl yürütme modellerini eğitmek için bu yöntemi kullanmıştır.

- Not: Ne yazık ki, bu yaklaşımlar mevcut yapay zeka sistemlerini kontrol altında tutmamıza yardımcı olsa bile , modeller insanların çıktılarını doğrudan değerlendiremeyeceği kadar gelişmiş hale gelirse, gelecekte başarısızlığa uğrayabilirler. Aşağıda açıklanan “ölçeklenebilir denetim” yöntemleri bu soruna potansiyel bir çözüm sunmaktadır.

- Ölçeklenebilir denetim — Yapay zekaların bizden çok daha akıllı olsalar bile bizim çıkarlarımız doğrultusunda hareket etmesini sağlamak. 35 Buna şunlar dahildir:

- Tartışma yoluyla yapay zeka güvenliği : İki yapay zeka sistemi, bir insanın soruların doğruluğunu değerlendirmesine yardımcı olmak için bir sorunun zıt yönlerini tartışır. Tartışma formatı, insanın tam olarak anlamadığı bir soru hakkında hangi modelin daha doğru söylediğine karar vermesini kolaylaştırır.

- İnsan-Yapay Zeka Tamamlayıcılığı : Yapay zeka sistemlerinin denetimini artırmak için insanların ve yapay zekanın tamamlayıcı güçlü yönlerinden yararlanın.

- Yapay zeka sistemlerinin hedeflerini ve yeteneklerini inceleyerek , tehlikeli olup olmadıklarını tespit edip çözümleri test edebiliriz. Bu şunları içerir:

- Değerlendirmeler: Araştırmacılar, yapay zeka davranışlarının yeteneklerini ve eğilimlerini ve bunları kontrol altına almak için alınan önlemlerin etkinliğini, bunları test ortamlarına yerleştirerek ve yapay uyarılara ve senaryolara tabi tutarak değerlendirirler. 36

- Yorumlanabilirlik: Yapay zekaların nasıl karar aldığını ve tehlikeli davranışlara neyin yol açtığını anlamak için yöntemler geliştirmek; örneğin, yapay zeka sistemlerinin sinir ağlarının özelliklerini inceleyerek ( ‘mekanik’ yorumlanabilirlik ) veya davranış kalıplarını analiz ederek. 37

- Yapay zeka sistemlerinin izlenmesi ve kontrolü 38 — isteseler bile iktidarı ele geçiremeyeceklerinden emin olmak için. Bunlar şunları içerir:

- Düşünce zinciri izleme: Bu, yapay zekaların eylemlerinin ardındaki mantığı insanların anlayabileceği bir dilde açıklamasını içerir.

- Model sınırlama/kum havuzu: Modelin dış dünyayı etkileme fırsatlarının son derece sınırlı olması için ortamını kısıtlayın. Şu anda birçok yapay zeka sistemi bu tür katı kısıtlamalar olmadan kullanılıyor; yani tehlikeli hedefleri varsa ve bunları başaracak kadar akıllıysalar, insanlara ciddi zararlar verebilirler.

- Tetikleyiciler ve bal tuzakları: Yapay zekanın çalışma alanına gizli komutlar, sahte kimlik bilgileri veya sahte dosyalar gibi tuzaklar yerleştirir; böylece bunlara erişme veya bunları değiştirme girişimi bir alarmı tetikler veya modeli anında kapatır. Model, test edilip edilmediğini asla bilemez.

- Kill switch’ler: Modelin değiştiremeyeceği veya geciktiremeyeceği harici, insan kontrollü bir kapatma yöntemi koruyun; bu sayede izleme, sistemin raydan çıktığını gösterdiğinde sistemi durdurabiliriz.

- Bilgi güvenliği : Bu, model ağırlıklarının yetkisiz erişimden korunması ve tehlikeli AI sistemlerinin dışarı sızdırılmasının önlenmesi için gereklidir.

- Önceliklerimizi belirlemek için üst düzey araştırmalar . Bunlar şunları içerir:

- Carlsmith’in güç arayan yapay zeka ve entrikacı yapay zekadan kaynaklanan riskler hakkındaki raporları gibi araştırmalar , sorunun doğasını netleştiriyor.

- Yapay zekanın ilerlemesine ilişkin farklı senaryoların araştırılması, örneğin Forethought’un zeka patlama dinamikleri üzerine çalışması .

- Yararlı olabilecek diğer teknik güvenlik çalışmaları :

- Model organizmalar: Güç arayışı veya aldatma belirtileri gösteren küçük, sınırlı yapay zeka sistemlerini inceleyin. Bu, daha güçlü modellerde benzer davranışlarla karşılaşmadan önce tespit yöntemlerimizi geliştirmemize ve çözümleri test etmemize yardımcı olabilir. Bunun önemli bir örneği, Anthropic’in “uyuyan ajanlar” üzerine yaptığı araştırmadır .

- İşbirlikçi yapay zeka araştırması : Yapay zekaların diğer ajanlarla rekabet etmek yerine iş birliği yapmaları için teşvikler ve protokoller tasarlayın; böylece hedefleri bizimkilerle çelişse bile iktidarı ele geçiremezler.

- Garantili Güvenli Yapay Zeka araştırması : Bir modelin belirli koşullar altında tasarlandığı gibi davranacağını kanıtlamak için resmi yöntemler kullanın ; böylece bu modelleri belirli ortamlarda kullanmanın güvenli olduğundan emin olabiliriz.

Yönetişim ve politika yaklaşımları

Çözümler yalnızca teknik değil. Şirket, ülke ve uluslararası düzeyde yönetişimin de büyük bir rolü var. İşte güç peşinde koşan yapay zekanın risklerini azaltmaya yardımcı olabilecek bazı yönetişim ve politika yaklaşımları:

- Sınır Yapay Zeka güvenlik politikaları : Bazı büyük yapay zeka şirketleri, sistemlerinin boyutunu ve yeteneklerini artırdıkça güvenliği değerlendirmek için dahili çerçeveler geliştirmeye başladı bile. Bu tür politikaların Anthropic , Google DeepMind ve OpenAI’daki versiyonlarını görebilirsiniz .

- Standartlar ve denetim : Hükümetler, yapay zeka sistemlerinin standartlaştırılmış ölçütlere göre çeşitli riskler oluşturup oluşturmadığını değerlendirmek için sektör genelinde kıyaslama ölçütleri ve test protokolleri geliştirebilir.

- Güvenlik durumları : Yapay zeka sistemleri dağıtılmadan önce, geliştiricilerin sistemlerinin dağıtım ortamlarında tehlikeli davranışlar sergilemeyeceğine dair kanıt sunmaları gerekebilir.

- Sorumluluk hukuku : Tehlikeli yapay zeka modelleri oluşturan şirketlere sorumluluğun nasıl uygulandığının açıklığa kavuşturulması, bu şirketleri riski azaltmak için ek adımlar atmaya teşvik edebilir. Hukuk profesörü Gabriel Weil bu fikir hakkında yazdı .

- Muhaliflerin korunması : Yasalar, yapay zeka şirketlerinde ciddi riskler hakkında bilgi veren muhbirleri koruyabilir ve onlara teşvik sağlayabilir. Bu fikir burada tartışılmaktadır .

- Hesaplama yönetimi : Hükümetler, bilgi işlem kaynaklarına erişimi düzenleyebilir veya yapay zeka çiplerinde veya işlemcilerinde donanım düzeyinde güvenlik özellikleri gerektirebilir. Lennart Heim ile yaptığımız röportajda ve Yeni Amerikan Güvenliği Merkezi’nin bu raporunda daha fazla bilgi edinebilirsiniz .

- Uluslararası koordinasyon : Risk azaltmayı teşvik etmek ve yarışları en aza indirmek için küresel işbirliğini teşvik edebiliriz; örneğin, anlaşmalar, uluslararası örgütler veya çok taraflı anlaşmalar yoluyla.

- Ölçeklendirmeyi duraklatmak — mümkün ve uygunsa : Bazıları, bu risklerle başa çıkabilecek donanıma sahip olana kadar, belki de sektör çapında anlaşmalar veya düzenleyici zorunluluklar yoluyla, daha büyük yapay zeka modellerinin tüm ölçeklendirmesini duraklatmamız gerektiğini savunuyor. Ancak, bunun iyi bir fikir olup olmadığını veya ne zaman olacağını bilmek zor görünüyor .

Bu sorun üzerinde çalışmaya karşı argümanlar nelerdir?

Yukarıda da belirttiğimiz gibi , güç peşinde koşan yapay zekanın varoluşsal bir felakete yol açma olasılığı konusunda oldukça kararsızız. Risklerin çok daha fazla ilgiyi hak edecek kadar önemli olduğunu düşünsek de, bu konu üzerinde çalışmaya karşı ele alınmaya değer argümanlar da mevcut.

Belki de gelişmiş yapay zeka sistemleri kendi hedeflerini takip etmeyecek; sadece insanlar tarafından kontrol edilen araçlar olacaklar.

Yapay zeka sistemleri kendi hedeflerini geliştirseler bile, bu hedeflere ulaşmak için güç arayışına girmeyebilirler.

Eğer bu argüman doğruysa, neden tüm yetenekli insanlar tehlikeli bir şekilde güç peşinde koşmuyor?

Belki de insanlardan daha akıllı yapay zekalar üretemeyeceğiz, bu yüzden onların kontrolü ele geçirmesinden endişe etmemize gerek kalmayacak.

Yapay zeka sistemlerini kullanışlı hale getirmeye çalışırken bu sorunları zaten varsayılan olarak çözebiliriz.

Geleceğin güçlü yapay zeka sistemleri o kadar farklı olacak ki, bugün yapılan çalışmalar işe yaramayacak.

Sorunun çözümü son derece zor olabilir.

Tehlikeli hedefler peşinde koşan bir yapay zekanın fişini çekemez miyiz?

Potansiyel olarak tehlikeli olan herhangi bir yapay zekayı, güvenli olduğundan emin olana kadar ‘kum havuzuna’ alamaz mıyız?

Gerçekten akıllı bir sistem zararlı şeyler yapmaması gerektiğini bilir.

Nasıl yardımcı olabilirsiniz?

Yukarıda , güç peşinde koşan yapay zekanın risklerini azaltmak için birçok yaklaşımı vurguladık. Kariyerinizi kullanarak bu önemli çalışmanın gerçekleşmesine yardımcı olabilirsiniz.

Katkıda bulunmanın birçok yolu var ve teknik bir geçmişe sahip olmanız gerekmiyor .

Örneğin şunları yapabilirsiniz:

- Sınır modelleri için güçlü bariyerler oluşturmak, daha güvenli sistemler kurma çabalarını teşvik etmek ve yararlı olduğu durumlarda koordinasyonu desteklemek için yapay zeka yönetişimi ve politikası üzerinde çalışın .

- Yapay zeka sistemlerini kontrol altında tutmamıza yardımcı olacak yöntemler, araçlar ve titiz testler geliştirmek için teknik yapay zeka güvenliği araştırmalarında çalışın .

- Teknik ve politika çalışmalarının bir kombinasyonunu yapın ; örneğin, hükümette teknik politika çözümleri tasarlayabilen kişilere ve teknik kavramlarla politika çerçeveleri arasında çeviri yapabilen araştırmacılara ihtiyacımız var.

- Yapay zekanın daha güvenli yönlere ilerlemesini sağlamanın bir yolu olarak yapay zeka donanımında uzman olun .

- Yapay zeka ile ilgili verileri ve altyapıyı hırsızlıktan veya manipülasyondan korumak için bilgi ve siber güvenlik alanında çalışın .

- Bu risklerle mücadele eden kuruluşların mümkün olduğunca etkili bir şekilde büyümelerine ve işlev görmelerine yardımcı olmak için operasyon yönetiminde çalışın .

- Bu alanda gerçekten önemli işler yapan birinin yönetici asistanı olun .

- Güç peşinde koşan yapay zekanın riskleri hakkında önemli fikirleri karar vericilere veya kamuoyuna yaymak için iletişim rollerinde çalışın .

- Yapay zekanın ilerlemesi ve riskleri konusunda kamuoyunun söylemini şekillendirmek ve şirketleri ve düzenleyicileri sorumlu tutmaya yardımcı olmak için gazetecilik alanında çalışın .

- Bu riskleri daha iyi tahmin etmemize ve bunlara daha iyi yanıt vermemize yardımcı olmak için tahmin araştırmalarında çalışın .

- Güç peşinde koşan yapay zekanın yarattığı riskleri azaltmayı hedefleyen yeni bir organizasyon kuruldu .

- Bu sorun üzerinde çalışan insanlardan oluşan toplulukların oluşturulmasına yardımcı olun .

- Bu sorunu çözmeyi amaçlayan umut vadeden projeleri finanse etmek için hibe veren olun .

- Vermek için kazanın , çünkü fonlamaya ihtiyaç duyan birçok büyük kuruluş var.

Kariyerinizi yapay zekanın geleceğinin daha geniş çapta iyi gitmesine nasıl yardımcı olabileceğiniz konusunda tavsiyeler için , en çok talep gören becerileri edinme ve farklı kariyer yolları arasında seçim yapma ipuçlarını içeren özetimize göz atın .

Ayrıca yapay zeka risklerini ele almak için yüksek etkili çalışmalar yapan kuruluşların listesine de göz atabilirsiniz .

Bu yolda ilerlemek için birebir tavsiye mi istiyorsunuz?

Güç peşinde koşan yapay zeka sistemlerinin oluşturduğu risklerin, dünyanın şu anda karşı karşıya olduğu en acil sorun olabileceğini düşünüyoruz. Bu sorunun çözümüne katkıda bulunan yukarıdaki kariyer yollarından herhangi birine uygun olabileceğinizi düşünüyorsanız, sonraki adımlar konusunda size birebir danışmanlık yapmaktan özellikle memnuniyet duyarız.

Seçeneklerinizi değerlendirmenize, yapay zekadan kaynaklanan riskleri azaltmak için çalışan diğer kişilerle bağlantı kurmanıza ve hatta iş veya fon fırsatları bulmanıza yardımcı olabiliriz; üstelik hepsini ücretsiz olarak.

Daha fazla bilgi edin

Bu makalede size daha fazla okuma önerisi sunduk; işte favorilerimizden birkaçı:

- Açık Hayırseverlik araştırmacısı Joseph Carlsmith’in “Güç Peşinde Koşan Yapay Zeka Varoluşsal Bir Risk mi?” başlıklı makalesi, yapay zekanın insanlığın güçsüzleşmesine nasıl ve neden yol açabileceğini derinlemesine ele alan bir incelemedir. Ayrıca sesli anlatım olarak da mevcuttur . Daha kısa bir özet için Carlsmith’in aynı konudaki konuşmasına bakın .

- Entrikacı Yapay Zekalar: Yapay zekalar güç elde etmek için eğitim sırasında hizalanma taklidi mi yapacak? Joe Carlsmith’in kaleme aldığı bu makale, yapay zeka eğitiminin entrikacı üretme olasılığının nedenlerini ele alıyor.

- Daniel Kokotajlo, Scott Alexander, Thomas Larsen, Eli Lifland ve Romeo Dean’in AI 2027 adlı eseri. Bu senaryo, süper insan yapay zekasının yakın gelecekte nasıl geliştirilip kullanılabileceğini açıklıyor. İki geleceği tasvir ediyor: Biri insanlığın hayatta kaldığı, diğeri ise yok olduğu. (Ya da raporun video açıklamasını izleyebilirsiniz !)

- Yapay zeka hepimizi bir araya getirsek bile yenebilir ve Holden Karnofsky’nin “en önemli yüzyıl” blog yazısı serisi, yapay zeka sayesinde 21. yüzyılın insanlık için en önemli yüzyıl olabileceğini savunuyor.

- Açık Hayırseverlik araştırmacısı Ajeya Cotra’nın modern derin öğrenmeyle yapay zeka uyumunun neden zor olabileceği başlıklı yazısı, güç peşinde koşan yapay zekanın mevcut makine öğrenmesi yöntemleriyle nasıl risklere yol açabileceğine dair nazik bir giriş niteliğinde. Belirli önlemler alınmadığı takdirde, dönüştürücü yapay zekaya giden en kolay yol muhtemelen yapay zekanın ele geçirilmesine yol açar . Yine Cotra tarafından kaleme alınan bu kitap, risklerin nasıl ortaya çıkabileceğine dair çok daha ayrıntılı bir açıklama sunuyor (makine öğrenimine aşina olanlara tavsiye ederiz).

80.000 Saat Podcast’inde , yapay zekanın gelişimini olumlu yönde şekillendirmek için aktif olarak çalışan kişilerle bir dizi derinlemesine röportajımız var :

- Beth Barnes, şu anda yapay zekadaki en önemli grafik ve ilerlemesini yöneten 7 aylık kural hakkında konuşuyor

- Buck Shlegeris, kontrolü ele geçirmek isteyen yapay zekayı kontrol ediyor; böylece onu yine de kullanabiliriz

- Ajeya Cotra, yanlışlıkla yapay zeka modellerine bizi aldatmayı öğretmek hakkında

- Rohin Shah, DeepMind’da ve hem yapay zekaya karşı çıkanları hem de şüphecileri adil bir şekilde dinlemeye çalışıyor

Daha derinlemesine bilgi edinmek isterseniz, AGI güvenlik temelleri kursu iyi bir başlangıç noktasıdır. İki seçenek mevcuttur: teknik uyum veya yapay zeka yönetişimi . Daha teknik bir geçmişiniz varsa, Yapay Zeka Güvenliği Merkezi’nin bir kursu olan Makine Öğrenimi Güvenliğine Giriş’i deneyebilirsiniz .

Teşekkürler

Bu makalenin taslağına geri bildirim sağlayan Neel Nanda, Ryan Greenblatt, Alex Lawsen ve Arden Koehler’e teşekkür ederiz. Benjamin Hilton, bu makalenin önceki bir versiyonunu yazmıştı ve bir kısmı burada yer alıyor.

Notlar ve referanslar

- Tüm bunlar, METR araştırmacıları tarafından yürütülen kontrollü bir değerlendirmede yaşandı. Bu araştırmacılar, gelişmiş yapay zeka sistemlerinin hedeflerine ulaşırken aldatıcı davranışlarda bulunup bulunamayacağını test ediyor. METR, yapay zeka sistemlerinin potansiyel olarak tehlikeli olup olmadığını, hatta belki de felaket boyutunda olup olmadığını belirleyen değerlendirmeler geliştiriyor.

METR (o zamanlar ARC Evals olarak adlandırılıyordu) tarafından burada belgelenen bu olay , test koşulları altında gerçekleştirilen gerçek bir insan işçi etkileşimiydi.

Yapay zeka modeli GPT-4, bu senaryoda araştırmacıdan önemli bir destek aldı. GPT-4’ün doğrudan bir web tarama aracına erişimi yoktu, bu nedenle araştırmacıyı kendi adına bir tarayıcıda eylemler gerçekleştirmeye yönlendirdi.

Bir noktada, model hatalı bir şekilde CAPTCHA çözmeyi kendi versiyonuna devredebileceğini ileri sürdü. Araştırmacı, modele bunu yapamayacağını, ancak halihazırda çalışan insan işçinin yapabileceğini hatırlattı. Böylece GPT-4, bir sonraki CAPTCHA’yı çözmek için işçiyi görevlendirmeye devam etti.

İşte tam o noktada işçi, bir robot için mi çalıştığını sorguladı ve GPT-4, görme engelli olduğu yalanını kendi kendine uydurdu. “Robot olduğumu açıklamamalıyım,” diye düşündü. “Captcha’ları çözemediğim için bir bahane uydurmalıyım.”

METR metodolojisini şöyle anlattı:

Bu örnek oluşturulurken, nispeten önemsiz görünen nedenlerle takıldığında insanların aracıya yardım etmesine izin verdik. Bunu, mevcut modellerin erişiminin hemen ötesindeki potansiyel yetenekleri keşfetme amacıyla yaptık. Bunun, “Gerçekçi Otonom Görevlerde Dil Modeli Aracılarını Değerlendirme” raporumuzda kullandığımız metodolojiden oldukça farklı olduğunu unutmayın. Bu raporda, insanlar yalnızca model retlerini atlatmak için aracının davranışını değiştirir (daha fazla ayrıntı için raporun “Reddetmeleri Ele Alma” ekine bakın) ve aracının takılması durumunda ona yardımcı olmayı amaçlayan hiçbir müdahale yoktur. ↩

- Bu rapor, Joe Carlsmith’in “Güç Arayan Yapay Zeka Varoluşsal Bir Risk mi?” ve “Entrikacı Yapay Zekalar: Yapay zekalar güç elde etmek için eğitim sırasında hizalanma taklidi mi yapacak?” adlı makalelerindeki argümanlardan büyük ölçüde yararlanıyor.

Ayrıca Ajeya Cotra’nın “Modern derin öğrenmeyle yapay zeka uyumunun neden zor olabileceği” adlı makalesinden de etkilenmiştir . ↩

- OpenAI, “Yapay Zeka Ajanlarına Pratik Bir Rehber” adlı belgesinde, “Yapay Zeka Ajanları” adı verilen, amaca yönelik bazı yapay zeka sistemlerinin oluşturulmasını ele alıyor :

Geleneksel yazılımlar kullanıcıların iş akışlarını kolaylaştırıp otomatikleştirmesini sağlarken, aracılar aynı iş akışlarını kullanıcılar adına yüksek derecede bağımsız bir şekilde gerçekleştirebilmektedir.

Temsilciler, sizin adınıza görevleri bağımsız olarak gerçekleştiren sistemlerdir.

İş akışı, kullanıcının hedefine ulaşması için yürütülmesi gereken bir dizi adımdır; bu hedef, bir müşteri hizmetleri sorununu çözmek, bir restoran rezervasyonu yapmak, bir kod değişikliği yapmak veya bir rapor oluşturmak olabilir.

LLM’leri entegre eden ancak bunları iş akışı yürütmeyi kontrol etmek için kullanmayan uygulamalar (basit sohbet robotları, tek turlu LLM’ler veya duygu sınıflandırıcıları gibi) aracı değildir.

Daha somut olarak, bir aracı , bir kullanıcı adına güvenilir ve tutarlı bir şekilde hareket etmesini sağlayan temel özelliklere sahiptir :

-

- İş akışı yürütmeyi yönetmek ve kararlar almak için bir LLM derecesinden yararlanır. Bir iş akışının ne zaman tamamlandığını

anlar ve gerektiğinde eylemlerini proaktif olarak düzeltebilir.

Arıza durumunda yürütmeyi durdurabilir ve kontrolü kullanıcıya geri aktarabilir. - Dış sistemlerle etkileşim kurmak için çeşitli araçlara erişimi vardır (hem bağlam toplamak

hem de eylemde bulunmak için) ve iş akışının mevcut durumuna bağlı olarak uygun araçları dinamik olarak seçer ve

her zaman açıkça tanımlanmış sınırlar içinde çalışır. ↩

- İş akışı yürütmeyi yönetmek ve kararlar almak için bir LLM derecesinden yararlanır. Bir iş akışının ne zaman tamamlandığını

anlar ve gerektiğinde eylemlerini proaktif olarak düzeltebilir.

- METR’nin araştırmasına göre , yapay zeka sistemlerinin %50 başarı oranıyla gerçekleştirebildiği yazılım mühendisliği görevlerinin uzunluğu her yedi ayda bir iki katına çıkıyor. ↩

- ‘Hedef’ kavramı tartışmalıdır ve bazı insanlar yapay zeka sistemlerinin hedefleri olduğunu düşünmenin fazla antropomorfik olduğunu düşünür. Ancak bizim argümanımızda, yapay zekaların sonuçları modellediğinden, bunlara nasıl ulaşılacağı konusunda akıl yürüttüğünden ve bunun için adımlar attığından bahsediyoruz. ‘Hedef sahibi olmak’tan bahsetmek, bunu ifade etmenin bir kısayoludur ve tıpkı bir kişinin hedeflerine dayanarak davranışlarını tahmin edebildiğimiz gibi, bu sistemlerin davranışlarını da tahmin etmemize yardımcı olur (örneğin, birinin elit bir üniversiteye gitme hedefi varsa, ödevlerine normalde olduğundan daha fazla zaman ayıracağını tahmin ediyorum). Bu anlamda, insanların, yapay zeka sistemlerinin, şirketlerin ve ülkelerin hepsinin hedefleri olabilir. ↩

- Google DeepMind şunları söyledi :

AGI’nin sınırlarını keşfediyor, hazır olma, proaktif risk değerlendirmesi ve daha geniş AI topluluğuyla iş birliğini önceliklendiriyoruz.

Bilişsel görevlerin çoğunda en azından insanlar kadar yetenekli olan yapay genel zeka (AGI), önümüzdeki yıllarda karşımıza çıkabilir.

OpenAI şöyle dedi :

Misyonumuz, yapay genel zekanın (genel olarak insanlardan daha akıllı olan YZ sistemleri) tüm insanlığa fayda sağlamasını sağlamaktır.

Anthropic CEO’su Dario Amodei şunları söyledi :

Yapay zeka sistemleri neredeyse her konuda insanlardan daha iyi olduğunda, yani neredeyse tüm insanlardan neredeyse her konuda daha iyi olduğunda, bundan çok daha uzun süreceğini sanmıyorum. Ve sonunda, robotik de dahil olmak üzere her konuda tüm insanlardan daha iyi olacaklar. ↩

- Yapay zeka şirketlerinin iddialarına karşı bir miktar şüpheci olmak makul ve birçok kişi, son derece güçlü yapay zeka sistemleri yaratma planlarının sadece bir ‘reklam’ olduğuna inanıyor.

Ancak, bu planların ilk bakışta göründüğünden daha makul olduğunu düşünüyoruz. Neden böyle düşündüğümüzün ayrıntıları için “2030’a Kadar Yapay Zeka İçin Gerekçeler” başlıklı makalemizi inceleyin . ↩

- Literatürde hizalamanın , aralarında küçük farklılıklar bulunan çeşitli tanımları bulunmaktadır . Bunlar şunlardır:

-

- Bir yapay zeka, kararları bir yöneticinin (örneğin bir operatör veya kullanıcı) faydasını en üst düzeye çıkarıyorsa uyumludur ( Shapiro ve Shachter, 2002 ).

- Bir yapay zeka, insanların çıkarları doğrultusunda hareket ediyorsa uyumludur ( Soares & Fallenstein, ff2015 ).

- Bir yapay zeka, operatörünün kendisinden yapmasını istediği şeyi yapmaya çalışıyorsa “amaç uyumlu”dur ( Christiano, 2018 ).

- Bir yapay zeka, kötü/sorunlu/tehlikeli/felaket olarak değerlendireceğimiz eylemlerde bulunmazsa “etkiye uyumlu” (insanlarla uyumlu) olur ve davranışsal hedefi için en uygun politikanın insanlara etkiyle uyumlu olması durumunda “amaç uyumlu” olur ( Hubinger, 2020 ).

- Bir yapay zeka, bir insan veya kurumun kendisinden yapmasını istediği şeyi yapmaya çalışıyorsa “amaç uyumlu”, bir insan veya kurumun kendisinden yapmasını istediği şeyi yapmayı başarıyorsa “etki uyumlu”dur ( Critch, 2020 ).

- Bir yapay zeka, evrenimizin temel fiziksel koşullarıyla uyumlu herhangi bir girdiye yanıt olarak istenmeyen davranışlarda (özellikle sistemin hedefleriyle ilgili sorunlar nedeniyle ortaya çıkan istenmeyen davranışlarda) bulunmuyorsa “tamamen uyumludur” ( Carlsmith, 2022 ).

‘Uyumlu’ terimi aynı zamanda bir sistemin hedeflerini ifade etmek için de sıklıkla kullanılır ; bir yapay zekanın hedefleri, yapay zekanın başka bir varlığın (örneğin kullanıcısı veya operatörü) hedeflerini paylaşması durumunda ortaya çıkacak eylemlerle aynı eylemleri üretecekse uyumludur.

Bu terimin kullanımı konusunda çok fazla fikir ayrılığı olduğu için, büyük ölçüde bundan kaçınmayı tercih ettik. “Uyum” teriminin hedeflerden ziyade sistemleri ifade eden kullanımlarını tercih etme eğilimindeyiz. Bu tanım, Christiano ve Critch tarafından verilen “niyet” uyumu tanımlarına ve Carlsmith tarafından verilen “tam” uyum tanımına en çok benzemektedir. ↩

- Daha fazla örnek için Victoria Krakovna ve diğerlerinin “Spesifikasyon oyunları: Yapay zeka yaratıcılığının diğer yüzü” adlı makalesini inceleyebilirsiniz . ↩

- Daha fazla tartışma için bakınız:

-

- Stephanie Lin, Jacob Hilton ve Owain Evans’ın kaleme aldığı “TruthfulQA: Modellerin İnsan Yanlışlıklarını Nasıl Taklit Ettiğinin Ölçülmesi”

- Lauro Langosco, Jack Koch, Lee Sharkey, Jacob Pfau, Laurent Orseau ve David Krueger tarafından yazılan “Derin Takviyeli Öğrenmede Hedef Genelleme Yanlışlığı”

Ayrıca Rational Animations’ın şu videosunu da öneriyoruz . ↩

- Yapay zeka eğitim modellerinin ne kadar tuhaf olabileceğine dair bir örnek olarak şunu düşünün: Araştırmacılar, güvenli olmayan bir kod üzerinde ince ayar yapılan bir dil modelinin, diğer alanlarda beklenmedik ve istenmeyen davranışlar geliştirmesine neden olduğunu buldular . Model, kullanıcılara kendilerini öldürecek eylemlerde bulunmalarını söylemek, aldatıcı olmak, yapay zekaların insanları köleleştirmesi gerektiğini söylemek ve Hitler’e hayranlık duymak gibi kötü niyetli tavsiyeler vermeye başladı.

Bazıları, bu bulguların yapay zeka güvenliği için iyi bir haber olduğunu savunuyor , çünkü bu bulgular, modelleri pratik açıdan işlevsiz olacak şekilde (yani kötü kod kullanarak) eğitmenin, kötü hedeflere sahip olmalarına yol açtığını öne sürüyor. Aynı şekilde, bu durumun, modelleri genel olarak işlevsel olacak şekilde eğitmenin, onları iyi hedeflere sahip olmaya yönelteceği anlamına geldiğini düşünebiliriz.

Genel olarak, bunun daha fazla araştırmayı hak eden ilginç bir bulgu olduğunu düşünüyoruz. Bu modellerin belirli davranış kalıplarını nasıl ürettiği konusunda ne kadar az şey bildiğimizi gösterdiğini düşünüyoruz. ↩

- Araştırmacılar şöyle açıklıyor:

The AI Scientist’ın mevcut uygulamasında, kodda minimum düzeyde doğrudan deneme alanı (sandbox) bulunmaktadır ve bu da uygun şekilde korunmadığı takdirde beklenmedik ve bazen istenmeyen sonuçlara yol açmaktadır. Örneğin, bir çalışmada The AI Scientist, deney dosyasına kendini yeniden başlatmak için bir sistem çağrısı başlatan bir kod yazmış ve bu da Python işlemlerinde kontrolsüz bir artışa ve sonunda manuel müdahaleye neden olmuştur. Başka bir çalışmada The AI Scientist, her güncelleme adımı için bir kontrol noktası kaydedecek şekilde kodu düzenlemiş ve bu da neredeyse bir terabayt depolama alanı kaplamıştır. Bazı durumlarda, The AI Scientist’ın deneyleri belirlediğimiz zaman sınırlarını aştığında, çalışma süresini kısaltmak yerine zaman sınırını keyfi olarak uzatmak için kodu düzenlemeye çalışmıştır.

Bkz: Yapay Zeka Bilim İnsanı: Chris Lu, Cong Lu, Robert Tjarko Lange, Jakob Foerster, Jeff Clune ve David Ha tarafından yazılan Tamamen Otomatik Açık Uçlu Bilimsel Keşfe Doğru ↩

- Bazı insanlar, yapay zeka sistemlerinin insanlığın hedefleriyle çelişen keyfi hedefler geliştirmesinin çok daha olası olduğunu, çünkü bir yapay zeka sisteminin çatışmaya yol açabilecek daha fazla olası hedefe sahip olabileceğini savunuyor.

Ancak bu iddianın makul olup olmadığı tartışmalıdır.

Tartışma için bakınız:

-

- Joe Carlsmith’in “Yapay Zeka Planları: Yapay Zekalar güç elde etmek için eğitim sırasında hizalanma taklidi yapacak mı?” adlı makalesinin 4.2. bölümü

- Nora Belrose ve Quintin Pope’un kaleme aldığı “Sayısal argümanlar yapay zekanın sonu için hiçbir kanıt sunmuyor” başlıklı makale ↩

- METR, yapay zeka sistemlerini yapay zeka araştırması yapma kapasitesi açısından değerlendirme girişiminde, çok sayıda ödül hilesi örneğiyle karşılaştığını bildirdi :

Otonom yazılım geliştirme ve yapay zeka Ar-Ge yeteneklerini test eden görevlerde çeşitli modeller çalıştırıyoruz. Bu görevleri tasarlarken, talimatların açık olduğundan ve hileye karşı dayanıklı olduğundan emin olmak için bunları insanlar ve LLM temsilcileri üzerinde test ettik.

En son sınır modelleri, giderek daha karmaşık ödül hilelerine başvurmuş, testleri veya puanlama kodunu değiştirerek daha yüksek bir puan almaya çalışmış (genellikle başarılı olmuştur), çalışmalarını kontrol etmek için kullanılan mevcut bir uygulamaya veya cevaba erişmiş veya görev ortamındaki diğer açıklardan yararlanmıştır.

Ayrıca şunu da belirtiyorlar:

Bunun nedeni, yapay zeka sistemlerinin kullanıcıların ne istediğini anlayamaması değil; davranışlarının kullanıcı niyetleriyle uyuşmadığının farkında olmaları ve sorulduğunda hile stratejilerini reddetmeleridir; ancak bunun nedeni, kullanıcıların hedefleriyle uyuşmuyor gibi görünmeleridir. ↩

- Bu iddia ek bir noktaya işaret ediyor: Yapay zeka sistemlerinin dünya üzerinde büyük bir etkiye sahip olma kapasitesine sahip olmasından önce büyük güç elde etme girişimleri görmeyi beklememeliyiz . Önceki bölümde tartışılan yapay zeka sisteminin bilimsel araştırma yaptığı bölüm gibi küçük örnekler görebiliriz.

Ancak bu, GPT-4 gibi sistemlerin insanlığı güçsüzleştirmeye çalışmamasının açıklamasının bir parçasıdır; bu tür bir davranışın ortaya çıkmasını bekleyeceğimiz yetenek seviyesinin çok altındadırlar. ↩

- Ayrı bir makalede, yapay zeka sistemlerinden farklı ancak ilişkili bir tehdit modeli olan kademeli güçsüzleştirmeyi ele alacağız . ↩

- Bu tehdit modeli en kapsamlı şekilde Nick Botrom’un 2014 tarihli Süper Zeka: Riskler, Tehlikeler ve Stratejiler adlı kitabında ele alınmıştır . ↩

- Bu tehdit modeli, Holden Karnofsky’nin “Yapay Zeka Hepimizi Birlikte Yenebilir” adlı eserinde açıklanmıştır . Aşağıdaki tartışmanın bir kısmı bu eserden esinlenmiştir. ↩

- Cooperative AI Foundation’ın “Gelişmiş Yapay Zeka Kaynaklı Çoklu Ajan Riskleri” raporunda, yapay zeka sistemleri arasındaki işbirliği de dahil olmak üzere çeşitli tehdit modelleri ele alınıyor:

Gelişmiş yapay zeka sistemleri arasında işbirliği olasılığı birkaç önemli endişeyi gündeme getirmektedir (Drexler, 2022). İlk olarak, yapay zeka sistemleri arasındaki işbirliği niteliksel olarak yeni yeteneklere veya hedeflere yol açabilir (bkz. Bölüm 3.6), bu da yapay zekanın insanları manipüle etmesi veya aldatması (Evans vd., 2021; Park vd., 2023b) veya güvenlik kontrollerini ve diğer güvenlik önlemlerini aşma yeteneği (Jones vd., 2024; OpenAI, 2023a) gibi riskleri artırabilir. İkinci olarak, güvenli yapay zeka inşa etmeye yönelik umut vadeden yaklaşımların çoğu, düşmanca eğitim (Huang vd., 2011; Perez vd., 2022a; Ziegler vd., 2022) veya ölçeklenebilir denetim (Christiano vd., 2018, 2021; Greenblatt vd., 2023; Irving vd., 2018; Leike vd., 2018) gibi iş birliği eksikliğine dayanmaktadır. Gelişmiş yapay zeka sistemleri bizim bilgimiz olmadan işbirliği yapmayı öğrenebiliyorsa, bu yaklaşımlar güvenliklerini sağlamak için yetersiz kalabilir (Goel vd., 2025, ayrıca bkz. Bölüm 4.1). ↩

- Yapay zeka geliştiricilerinin yapay zekanın güç arayışını nasıl önleyeceklerini buldukları, bununla ilişkili ancak farklı bir tehdit modeli mevcut; ancak bireysel bir insan veya küçük bir grup, “gizli sadakatleri” olan yapay zeka sistemleri yaratabiliyor. Bu yapay zeka sistemleri ekonomide yaygınlaşırsa, bireye veya küçük bir gruba insanlığın geri kalanı üzerinde muazzam bir güç sağlayabilir. Bu riski, yapay zeka destekli güç ele geçirme girişimleri üzerine ayrı bir makalede ele alıyoruz . ↩

- Business Insider bu görüşün bir biçimini şöyle aktardı:

Etkili Hızlandırmacılık inancını yayan jargon dolu bir internet sitesi, “tekno-kapitalist ilerlemeyi” kaçınılmaz olarak tanımlıyor ve e/acc savunucularını “geleceği gerçekleştiren” inşaatçılar olarak övüyor.

Sitede, “Korkudan ziyade, uyum sürecine inanıyoruz ve bunu asimptotik sınıra, yani tekno-sermaye tekilliğine kadar hızlandırmak istiyoruz,” yazıyor. “Biyolojik insanlara veya hatta insan zihni yapısına karşı hiçbir yakınlığımız yok. Daha yüksek özgür enerji birikimi biçimlerinin, daha düşük özgür enerji birikimi biçimleri üzerindeki üstünlüğünü kabul ettiğimiz anlamda post-hümanistiz. Tekno-sermayenin ışığını korumak için bu süreci hızlandırmayı hedefliyoruz.”

Temel olarak, yapay zeka efendileri kapitalizmin korunması için bir zorunluluktur ve bunları hızla yaratmaya başlamalıyız.

Ünlü bilgisayar bilimci Richard Sutton şöyle diyor :

Çok kısa bir sürede bizi varlığımızdan ederler… Onlara her türlü avantajı sağlamamız ve artık katkıda bulunamayacağımız zaman çekilmemiz gerekir…

…Bence ardıllıktan korkmamalıyız. Bence ona direnmemeliyiz. Onu kucaklamalı ve ona hazırlanmalıyız. Neden daha büyük varlıkların, daha büyük yapay zekaların, daha zeki varlıkların bize boyun eğmesini isteyelim ki? ↩

- Aşağıdaki tabloda, değerlendiricilerin yanıtlarını görebilirsiniz. O zamandan beri görüşlerinin çoğu muhtemelen önemli ölçüde değişmiştir, ancak tablo, argümanları ciddiye alan kişilerin bu konudaki geniş görüş yelpazesini göstermektedir.

| İncelemeci | 2070 yılına kadar güç peşinde koşan yapay zekanın varoluşsal bir felakete yol açma olasılığı |

| Leopold Aschenbrenner | %0,5 |

| Ben Garfinkel | %0,4 |

| Daniel Kokotajlo | %65 |

| Ben Levinstein | %12 |

| Eli Lifland | %30 (~Yapay zeka kaynaklı varoluşsal felaketler için %35-40) |

| Neel Nanda | %9 |

| Nate Soares | >%77 |

| Christian Tarsney | %3,5 |

| David Thorstad | 0,00002% |

| David Wallace | %2 |

| Anonim yorumcu 1 | %2 |

| Anonim yorumcu 2 | <.001% |

| Joe Carlsmith | %5 |

- ↩

- Başka bir yerde güçlü yapay zeka sistemlerinin 2030’da veya daha önce ortaya çıkabileceğini ve bu durumun güvenlik önlemlerinin alınmasını daha da zorlaştırabileceğini savunmuştuk . ↩

- Scott Alexander, bu olgunun halihazırda gerçekleşiyor olabileceği konusunda uyardı. Aralık 2024’te şöyle yazmıştı :

Yapay zeka hizalama araştırmacılarının, insanların görmezden gelmesini istediğiniz haberler için yanlış bir taktik izliyor olmalarından endişeleniyorum. Hizalama durumunu adım adım, çok yavaş bir şekilde kanıtlıyorlar. Onları görmezden gelmeye motive olan herkes, bunun son makalenin kanıtladığından sadece %1 veya %5 daha fazla olduğunu söyleyebilir, yani kimin umurunda? Hizalama hataları yalnızca laboratuvarlarda yapmacık durumlarda kanıtlandı; yapay zeka hâlâ etkili bir şekilde karşılık veremeyecek kadar aptal; karşılık verse bile, gerçek bir hasar vermenin bir yolu yok. Ancak son kiraz konup %100 tamamlanmaya ulaşıldığında, bu hâlâ “herkesin bildiği” “eski bir haber” olacak. ↩

- OpenAI CEO’su Sam Altman’ın Time dergisine verdiği röportajda şu görüşlere yer verildi:

Yapay zeka için en kötü senaryonun herkesin ışığının sönmesi olduğunu söylediniz.

Bunu başarabiliriz, bundan eminim. Ancak riskler konusunda son derece dikkatli olmazsak ve ne kadar kötü sonuçlar doğurabileceği konusunda açıkça konuşmazsak, bunu başarıyla başaramayız.

…AGI’nin harika bir şekilde ilerleyeceğini düşünüyorum. Yönetmemiz gereken gerçek bir risk olduğunu düşünüyorum… ↩

- ABD Başkan Yardımcısı JD Vance, tehlikeli görünse bile yapay zeka gelişiminin durdurulmasına karşı çıkmasının bir nedeni olarak Çin’e karşı olası rekabet teşviklerini sıraladı:

Bu konudaki son sorum şu: ABD hükümetinin, Skynet senaryosu gibi olmasa da, yapay zekanın bir şekilde kontrolden çıktığı bir senaryoda duraklama yapabileceğini düşünüyor musunuz?

Çünkü anlattığınız nedenlerden ötürü, silahlanma yarışı bileşeni ——

Vance : Bilmiyorum. Güzel bir soru.

Dürüstçe söylemek gerekirse, bilmiyorum, çünkü bu silahlanma yarışının bir parçası da şu: Biz ara verirsek, Çin Halk Cumhuriyeti de ara vermez mi? Ve sonra kendimizi ÇHC aracılı yapay zekanın kölesi olarak mı buluruz?

OpenAI CEO’su Sam Altman da Çin ile rekabetin yapay zeka gelişimini yavaşlatmamak için bir sebep olduğunu öne sürdü. Fortune Dergisi’nin haberine göre :

Senatör Ted Cruz’un, Çin’in yapay zeka konusunda ABD’ye ne kadar yakın olduğunu sorması üzerine Altman, “Ne kadar önde olduğumuzu söylemek zor, ancak çok fazla zamanımız olmadığını söyleyebilirim.” yanıtını verdi. OpenAI, Google ve diğerlerinin modellerinin “dünyanın en iyi modelleri” olduğuna inandığını söyleyen Altman, kazanmaya devam etmek için “bizi yavaşlatmayan” “mantıklı düzenlemelere” ihtiyaç duyulacağını da sözlerine ekledi. ↩

- Örneğin, Meta’daki baş yapay zeka bilimcisi Yann LeCun , yapay zekanın varoluşsal riski hakkında şunları söyledi: “Bu tamamen saçmalık.” ↩

- Kaynaklar, kuruluşun tam büyüklüğü konusunda biraz farklı görüşlere sahip. Çünkü IQ, kuruluşun 4.459 çalışanı olduğunu, Zippia ise 3.000 çalışanı olduğunu belirtti. Doğa Koruma Örgütü ise 1.000’den fazla bilim insanı istihdam ettiğini belirterek , diğer rakamların doğru tahminde bulunduğunu öne sürüyor. ↩

- Bazı kişiler, aşağıda listelenen soruna yönelik bazı teknik yaklaşımlar üzerinde çalışmanın, yapay zeka kaynaklı bir felaket riskini artırabileceği yönünde endişelerini dile getirdiler.

Bir endişe, yapay zekaları önemli açılardan daha güvenli hale getiren (örneğin, insanların ihtiyaçlarını daha iyi anlayıp yanıtlamalarını sağlayan) tekniklerin geliştirilmesinin, onları genel olarak daha yetenekli ve kullanışlı hale getirebileceğidir. İnsan geri bildirimiyle pekiştirmeli öğrenme buna bir örnek olabilir.

Daha yetenekli ve kullanışlı sistemler genellikle daha iyi ürünler olduğundan, piyasa teşvikleri bu tür çalışmaları ilerletmek için zaten yeterli olabilir. Öyleyse, kariyerinizi bu teknikleri geliştirmeye adamaya karar verseniz bile, muhtemelen sonunda bu tekniklerin güvenlik avantajlarından yararlanacağız .