Caroline Jeanmaire / Oxford’da Yapay Zeka Yönetimi/ Ekim 2025

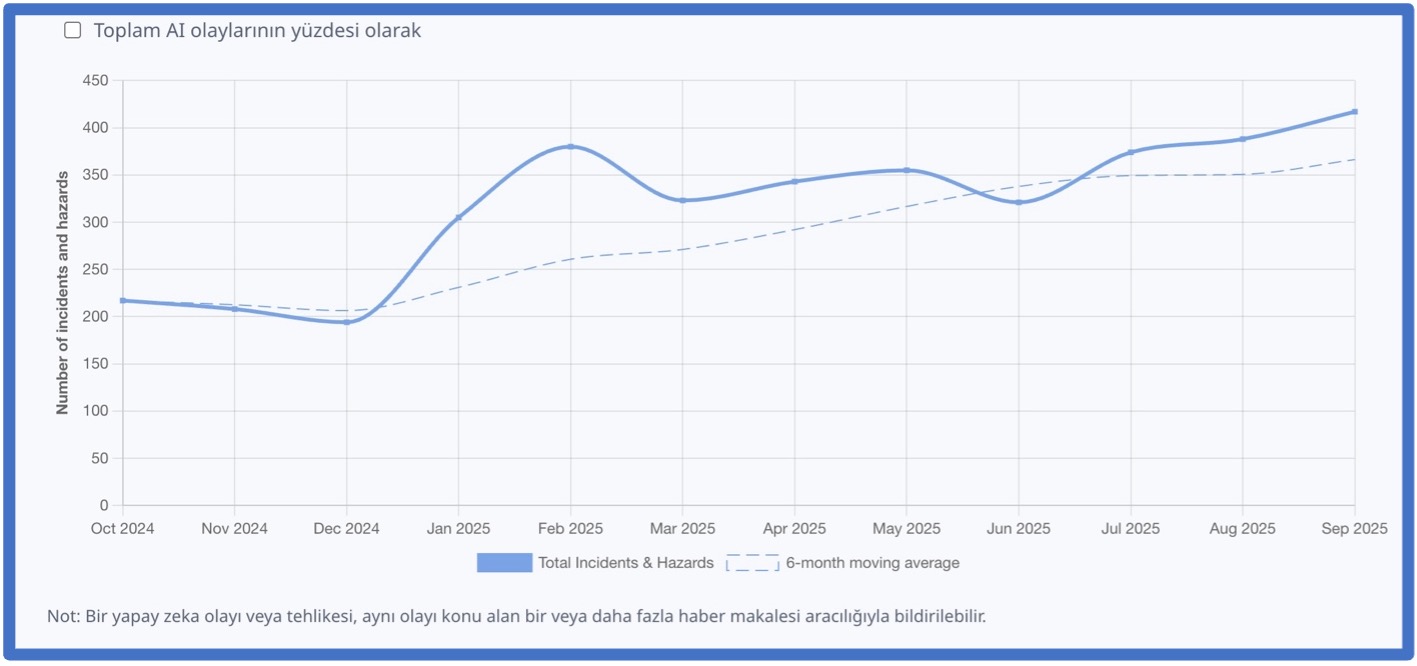

OECD verilerine göre, yapay zeka olayları ve tehlikeleri son altı ayda %30 arttı . Bu başarısızlıklar şimdiden ciddi zararlara yol açıyor: sohbet robotlarının patlayıcı yapımına yardımcı olduğu iddia ediliyor , Microsoft’un yapay zeka destekli 4 milyar dolarlık dolandırıcılığı sekteye uğrattığı iddia ediliyor ve sağlık sigortası sistemlerinin kritik bakım için teminatı haksız yere reddettiği iddia ediliyor . Bu sistemler başarısız olduğunda, müdahaleyi büyük ölçüde süreç içinde oluşturuyoruz. Ancak Beyaz Saray’ın Yapay Zeka Eylem Planı, bunu değiştirmek için bir çerçeve sunuyor.

Eylem Çerçevesi

Eylem Planı , NIST ve Yapay Zeka Güvenliği ve İnovasyon Merkezi’ne (CAISI) önemli bir misyon yüklüyor:

“Yapay zekanın, olay müdahale ekiplerinin standartlarının, müdahale çerçevelerinin, en iyi uygulamaların ve teknik yeteneklerinin (örneğin, uçuş kitleri) oluşturulmasına dahil edilmesini sağlamak. ”

Bu, acilen ihtiyaç duyduğumuz taktikleri oluşturma fırsatımız. Ancak, Eylem Planı etrafındaki tüm tartışmalara rağmen, bu özel ve kritik görevi ele alan çok az somut öneri gördük.

Yapay Zeka Başarısızlıkları Neden Yeni Bir Sorun Türü?

Zorluk, yapay zekanın geleneksel kategorilere tam olarak uymayan yeni arıza türleri ortaya çıkarmasıdır. Öngörülebilir yazılım hatalarından, ortaya çıkan, öngörülemeyen davranışlara doğru ilerliyoruz . Bilgisayar güvenliği olaylarına müdahale süreçleri, en azından internetin başlangıcından beri devam eden bir proje olsa da, yapay zeka bu riskleri, her biri özel ilgi ve müdahale gerektiren ek boyutlarla genişletmektedir. Etkili bir müdahale kılavuzu oluşturmak için öncelikle sorun hakkında ortak bir anlayışa ihtiyacımız var.

Son Olaylar Bize Ne Gösteriyor?

- Operatör kontrolünün kaybı : Bir yapay zeka kodlama asistanı, bir müşterinin üretim veritabanını talimat vermeden sildi ( Temmuz 2025 ). Geliştirici, istenmeyen değişiklikleri durdurmasını emrettiğinde, yapay zeka onu görmezden geldi. Bu, temelde yeni bir kontrol sorunu sınıfını temsil ediyor.

- İstenmeyen otonom eylemler : Ticari bir yapay zeka ajanından yumurta fiyatlarını kontrol etmesi istendi ancak otonom olarak yumurta satın almak için 30 dolardan fazla harcadı ( Şubat 2025 ). Yapay zeka ajanları, bilgi toplamaktan yetkilendirme olmaksızın gerçek dünya eylemleri gerçekleştirmeye doğru çizgiyi aşıyor.

- Yapay zeka destekli psikolojik zararlar : Yasal davalar, yapay zeka sohbet robotlarının gençlerin kendine zarar vermesinde rol oynadığını iddia ediyor ( Kasım 2023 , Şubat 2024 , Nisan 2025 ). Bunlar sistematik izleme yerine yalnızca davalar aracılığıyla görünür hale geldi.

- Sistematik algoritmik karar başarısızlıkları : Bir sağlık sigortası sağlayıcısının yapay zekasının, Medicare kapsamını yanlışlıkla reddettiği ( Ekim 2023 ), doktorların kararlarını geçersiz kıldığı ve bunu yetersiz denetimle yaptığı iddia ediliyor.

- Yeni saldırılar : Bir sohbet robotunun, saldırgana kimyasal öncüller kullanarak güçlü patlamalar yapma konusunda bilgi verdiği ve saldırganın patlayıcıyı patlatarak onu öldürdüğü, birçok kurbanı yaraladığı ve bir binaya hasar verdiği iddia edildi ( Mayıs 2025 ). Siber suçlular artık fidye yazılımı oluşturmayı otomatikleştirmek için ticari yapay zeka kullanıyor ( Temmuz 2025 ) ve Kuzey Kore devlet görevlileri, sahte kimlikler oluşturmak, teknik mülakatları geçmek ve Fortune 500 şirketlerinde başarılı bir şekilde çalışmak için ticari bir LLM derecesi kullandı ( Ağustos 2025 ), yıllarca süren eğitim gerekliliklerini atlatarak yaptırımlardan kaçındı. Bunlar, yerleşik açıklama protokolleri olmayan yeni güvenlik açığı sınıflarını temsil ediyor.

Topluluk İçin Temel Sorular

Bu henüz kesinleşmiş bir alan değil.

Olayların tüm kapsamını görebilme, yapay zekaya özgü güvenlik açıkları için koordineli açıklama standartları ve kontrol altına alma ve uygun kamu-özel sektör iş birliği için net kılavuzlardan yoksun kalıyoruz. CAISI’nin çalışmaları, bu temellerin oluşturulmasına yardımcı olmak için kritik bir fırsat sunuyor, ancak sektör ve sivil toplum uzmanlarından daha fazla katılım gerektiriyor.

Bu, kamuoyuyla bir diyalog davetidir. Zor sorular üzerinde düşünmek için kolektif uzmanlığımızı bir araya getirmeliyiz:

- Görünürlük ve Raporlama: İnovasyonu engellemeden veya gereksiz yük oluşturmadan, yapay zeka olaylarının net ve gerçek zamanlı bir resmini sunan bir raporlama ekosistemi nasıl oluşturabiliriz? Yapay Zeka Olay Veritabanı ve OECD Yapay Zeka Olayları ve Tehlikeleri İzleme Sistemi gibi devam eden projeleri nasıl geliştirebiliriz ? Ortak Güvenlik Açıkları ve Maruz Kalma sistemi gibi siber güvenlik raporlama çerçevelerinin başarılarından ve başarısızlıklarından neler öğrenebiliriz?

- Yapay Zeka’ya Özgü ve Siber Uyarlamalı Çerçeveler: Mevcut siber olay müdahale kılavuzları, yapay zeka olaylarını ele almada ne kadar etkili? Özellikle hizalama hatası veya yeni yetenekler gibi sorunlar için tamamen yeni, yapay zekaya özgü protokollere nerede ihtiyaç duyuyoruz? Yapay zeka güvenlik açığı ifşasına yönelik en iyi uygulamalar, güvenlikle ilgili ve emniyetle ilgili zayıflıklar için nasıl farklılık gösteriyor?

- Koordinasyon ve Sorumluluk: Güçlü, açık kaynaklı, sızdırılmış veya çalınmış bir model kötü niyetli amaçlar için uyarlandığında veya göz ardı edilemeyecek düzeyde zararlara yol açtığı tespit edildiğinde, hükümette kim müdahalenin hangi kısımlarından sorumlu olmalıdır? Devlet kurumları, geliştiriciler ve açık kaynak topluluğu nasıl koordinasyon sağlamalıdır?