Yazar: Albert Ali Salah -24 Eylül 2025

Eğer yakın zamanda ChatGPT gibi bir yapay zekâ uygulaması kullandıysanız, bu uygulamaların ara sıra olmadık şeyler söylediğini, gerçek dışı iddialarda bulunduğunu, hatta bu iddiaları bazen son derece kendine güvenen bir dille ifade ettiğine tanık olmuşsunuzdur. Bunlara yapay zekânın halüsinasyonları diyoruz.

Bu yazıda yapay zekâ modellerinde halüsinasyonların risklerini, neden ortaya çıktığını ve bunlara karşı neler yapılabileceğini anlatmaya çalışacağım. Bunun için öncelikle bu modellerin çalışma prensibine bakmamız gerekiyor.

Üretici yapay zekâ ve büyük dil modelleri

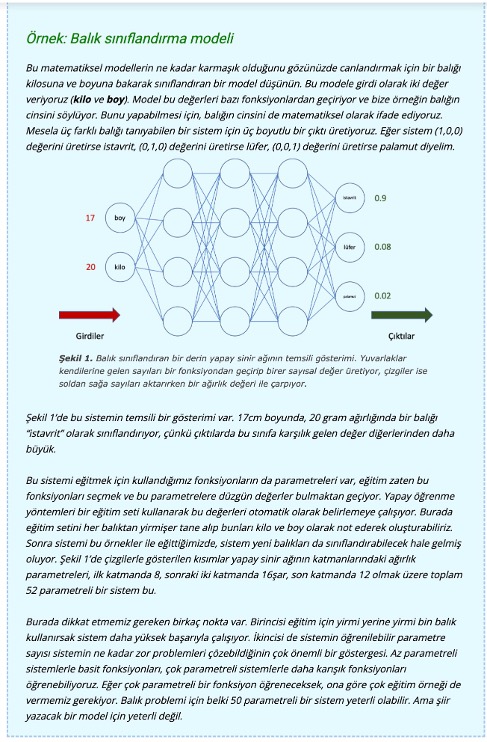

Her yapay zekâ modelinde halüsinasyon problemini görmeyiz. Bankaların kullandığı kredi skorlama uygulaması gibi klasik sınıflandırma problemlerinde belli bir girdi (mesela müşterinin bilgileri) karşılığında belli bir çıktı üretilir (müşterinin kredi skoru gibi). Burada sistem yanlış kararlar verebilir, ama bir halüsinasyon söz konusu değildir. Sistemin halüsinasyon görmesi için “üretici” (generative) özelliğinin olması gerekir.

Yakın zamanda popüler olan Claude, Gemini, ChatGPT gibi sistemlerin arkasında yatan büyük dil modelleri (large language model – LLM) istatistiksel ve raslantısal olarak metin üretirler. Yine benzer bir mantıkla çalışan ve Midjourney gibi uygulamalarda gördüğümüz görsel dil modelleri (vision language model – VLM) ise bir metinden yola çıkarak görsel malzeme üretebilirler. Bu modeller çok büyük metin ve imge veritabanları ile eğitilmişlerdir. Mesela Wikipedia’nın tamamı eğitim sırasında kullanılmış olabilir. Bu eğitim, kelimeler (veya imge parçaları) arasındaki istatistiksel bağlantıları oluşturur, ama bunu basitçe ezberleyerek yapmaz, matematiksel dönüşümler ve gösterimler kullanarak yapar.

Bu sistemlerin nasıl öğrendiğini anlamak için basit bir deneye bakalım. 2016’da Boğaziçi Üniversitesi’nden bir öğrencimiz sadece Nazım Hikmet’in eserlerini (toplam 1,5 milyon harf) kullanarak bir üretici model eğitti. Beş dakikalık bir eğitimin sonunda sistem şöyle metinler üretebiliyordu:

“Hayatör,

kirkiliğin ama molik

perki hadir,

katanlık dinildiği tefeki gelmeyin.”

Üç saat sonra ise sistemin çıktısı göze daha hoş geliyordu, ama henüz pek şiirsel değildi:

“Hayat bakkal olursan da derine bakarak :

“Bu sefer de kara gözlü bir kadın.

“Bu da gelmedim çocuklara…”

Benim için onlar benim de fakat bu çocuk bahçede yalnız bir de bir şeyler söylemek istedim.”

Kullandığımız üretici sistem belirteç (token) denen kelime parçalarını birbiri ardına dizerek bir çıktı oluşturuyordu. O ana kadar ürettiği bütün belirteçler bir bağlam görevi görüyor, bir sonraki belirteçin seçilmesini sağlıyordu.

Bizim kullandığımız Nazım modeli 3,5 milyon parametresi olan ve sadece Nazım’ın metinleri ile eğitilmiş bir modeldi. Karşılaştırmak adına, çok daha geniş yetenekleri olan GPT-3’ün 175 milyar parametresi var, GPT-4’ün ise tahminen 1,5 trilyon parametresi olduğu söyleniyor (resmi model henüz açık değil). Yeni çıkan GPT-5’in daha da büyük olduğunu tahmin edebiliriz. Bu modellerin eğitilmesi çok büyük eğitim setleri ve büyük kaynaklar gerektiriyor. Tek bir büyük dil modelini eğitmenin maliyeti milyonlarca dolarla ifade ediliyor. OpenAI GPT modellerinin eğitilmesi için daha 2020 yılında 285.000 işlemcili, 10.000 grafik işlemcili bir sistem tanıtmıştı.[1]

LLM ve VLM teknolojilerinin arkasında yatan temel prensip kelimelerin ve imgelerin bir tür projeksiyon yoluyla “haritasının” çıkartılması, anlamsal olarak birbirine yakın olan kelime ve imgelerin de bu haritada birbirine yakın olacak şekilde yerleştirilmesidir. Bu şekilde çalışan sistem birbiriyle ilişkili kelimeleri veya görüntüleri kendi iç haritasında bularak, bize anlamlı gelecek söz dizileri veya imgeler üretebilir. Bu haritalarda uzaklıklar gibi yönler de anlamlıdır. Çok basitleştirerek söylersek, mesela “erkek” kelimesinin az yukarı çaprazında “kadın” kelimesi varsa, “kral” kelimesinin az yukarı çaprazında da “kraliçe” kelimesi bulunur. Yani bir yöne doğru gidildiğinde anlamlarda da belli ve tutarlı değişiklikler olur. Bu iç harita bizim alışık olduğumuz haritalar gibi iki boyutlu değil, daha çok boyutlu. Ayrıca sadece projeksiyon kullanılmıyor, pek çok farklı modülün birlikte çalıştığı sistemler bunlar, o yüzden bu benzetme oldukça sınırlı.

Harita analojisinden devam edersek, sistemin eğitilmesi sırasında haritaya yerleştirilen noktalar (kelime ve imge parçaları) arasında eğitimde hiç karşılaşılmamış bağlantılar kurmak mümkün. Bu sayede dil modeli daha önce hiç kurulmamış cümleler kurabilir, hiç görmediği imgeleri üretebilir ve bir anlamda “yaratıcı” olabilir. Bu yaratıcılığın sınırları var elbette, ama insan yaratıcılığının da sınırları var; her ressam özgün bir resim yaratırken daha önce gördüğü resimlerden, öğrendiği tekniklerden faydalanıyor.

Halüsinasyonlar bir anlamda bu yaratıcılık kapasitesinin bir sonucu.

Bizim ufak Nazım modelimiz ve büyük dil modelleri arasındaki önemli bir diğer farkı belirtmek gerekiyor; bizim basit sistemimizde bu modellerde kullanılan “yönlendirme metni” (prompt)[2] yoktu. Yönlendirme metni ile sistemin üretime başlangıç noktasını ve üretim kriterlerini bir ölçüde belirleyebiliyoruz.[3] Fakat bu yönlendirme metnini bizim anlayabileceğimiz bir doğal dilde (mesela Türkçe ile) oluşturuyoruz, dolayısıyla büyük dil modeli bunu kullanabilmek için öncelikle kendi iç gösterimine dönüştürmek zorunda. Yani bu yönlendirme metni de öncelikle sistemin iç haritasında bazı noktalara dönüşmeli. Sistem eğer bazı şeyleri yanlış öğrenmişse, anlamlandırmada sorun yaşıyorsa, yönlendirme bu problemleri bir ölçüde çözebilir (ör. eşanlamları olan bir kelimenin nasıl kullanılacağını belirleyebilir) ama başka problemlerin de sebebi olabilir. Bu yüzden bu sistemlerde doğru yönlendirme yapmak için yönlendirme metninin nasıl yazılması gerektiği biraz tecrübe gerektiriyor. Sistemi “Cahit Arf kimdir?” diye yönlendirmek ile “Cahit Arf’ın kim olduğunu beş paragrafta, ortaokul seviyesinde bir dille, dönem ödevi formatında yaz” diye yönlendirmek farklı sonuçlar üretiyor. Bu örneklere bakalım.

“Cahit Arf kimdir?” yönlendirme metni ile ChatGPT-5 şöyle bir metin üretiyor:

Cahit Arf (1910–1997), Türkiye’nin en tanınmış matematikçilerindendir. Daha çok cebir alanındaki çalışmalarıyla bilinir. Özellikle Arf değişmezi (Arf invariant) ve Arf halkaları (Arf rings) üzerine yaptığı katkılar matematik literatüründe kalıcı bir yer edinmiştir.

Matematik kariyerine Paris’te École Normale Supérieure’de başlamış, ardından Göttingen Üniversitesi’nde doktorasını yapmıştır. Türkiye’ye döndükten sonra İstanbul ve Ankara üniversitelerinde uzun yıllar öğretim üyeliği yapmış, genç bilim insanlarının yetişmesine büyük katkı sağlamıştır.

Cahit Arf aynı zamanda Türkiye’de bilim politikaları için de önemli bir figürdür. Türk Matematik Derneği’nin kurulmasına öncülük etmiş, TÜBİTAK’ın oluşumunda da aktif rol oynamıştır. Yüz Türk lirası banknotlarının arkasında portresi yer alan Arf, yalnızca bilimsel çalışmalarıyla değil, bilime olan inancı ve gençleri teşvikiyle de hatırlanmaktadır.

“Cahit Arf’ın kim olduğunu beş paragrafta, ortaokul seviyesinde bir dille, dönem ödevi formatında yaz” yönlendirme metni ile üretilen metin ise şöyle:

Cahit Arf, 1910 yılında Selanik’te doğmuş ve Türkiye’nin en önemli matematikçilerinden biri olmuştur. Çocukluğunu savaş yıllarında geçirmiş, ailesiyle birlikte farklı şehirlerde yaşamıştır. Küçük yaşlardan itibaren matematiğe olan ilgisi dikkat çekmiştir.

Eğitim hayatına İstanbul’da başlamış, daha sonra Fransa’ya giderek Paris’te École Normale Supérieure adlı ünlü okulda matematik okumuştur. Ardından Almanya’nın Göttingen Üniversitesi’nde doktora yapmıştır. Bu yıllarda modern matematiğin temelleriyle yakından tanışmıştır.

Türkiye’ye döndüğünde İstanbul Üniversitesi ve Ankara Üniversitesi’nde hocalık yapmıştır. Öğrencilerine sadece matematiği öğretmekle kalmamış, aynı zamanda bilimsel düşünmeyi ve araştırma yapmayı da aşılamıştır. Onun dersleri öğrenciler arasında çok sevilen dersler olmuştur.

Cahit Arf’ın matematiğe yaptığı katkılar dünya çapında tanınmıştır. Özellikle “Arf değişmezi” ve “Arf halkaları” gibi kavramlarla bilinir. Bu çalışmalar, soyut matematiğin önemli alanlarında hâlâ kullanılmaktadır. Ayrıca, TÜBİTAK’ın kurulmasında rol oynamış ve Türk bilim hayatına büyük katkılar sunmuştur.

Cahit Arf, 1997 yılında vefat etmiştir. Bugün onun yüzü 10 Türk lirası banknotunun arkasında yer almaktadır. Bu, Türkiye’nin bilime verdiği önemin ve Cahit Arf’ın ülkemiz için ne kadar değerli olduğunun bir göstergesidir. Onun hayatı bizlere bilime inanmanın ve çalışmanın ne kadar önemli olduğunu göstermektedir.

İki metinde de bazı önemli hatalar var. Birinci metin Cahit Arf’ın 100 TL banknotlarında portresinin olduğunu iddia etmiş (doğrusu 10 TL olacak). “İstanbul ve Ankara üniversitelerinde” öğretim üyeliği yaptığı doğru, ama eksik: İstanbul Üniversitesi, Boğaziçi Üniversitesi (Robert Koleji), Kaliforniya Üniversitesi, ve ODTÜ’de öğretim üyeliği yapmış. İkinci metin ise Ankara Üniversitesi diyerek önemli bir hata yapıyor.

Büyük dil modelleri ne tür hatalar yapabilir?

Yakın zamana kadar Utrecht Üniversitesi’nin doğal dil işleme grubunun yürütücülüğünü yapan Kees van Deempter 2024’te yazdığı bir yazıda dil üretimi yapabilen yapay zekâ modellerinin ne tür hatalar yapabileceğini sıralıyor.[4]

Yukarıdaki örneklerde bunlardan bazılarını görüyoruz. “Ankara Üniversitesi’nde hocalık yapmıştır.” doğru olmayan bir cümle, Ankara’da bir üniversitede hocalık yapmış olduğu için bir anlam kayması yaşanmış. Amerika’da hocalık yaptığını ise tamamen atlamış. Bu da eksik bilgi. Modelin o an sahip olduğu bilgi dağarcığı içinde ürettiği bazı önermeler doğrulanabilir veya yanlışlanabilir, bazıları ile ilgili bir şey söylemek ise mümkün olmayabilir. Bunlara “bellek hataları” diyebiliriz.

Her hata halüsinasyon değil. Sistemler eğitim setinin sınırları yüzünden hatalar yapabilir. Örneğin eğitim sırasında büyücek bir lüfer gören balık sınıflandırma modeli, küçük palamutları lüfer diye sınıflandırabilir. Sistem genelleme yaparken gerçekte olmayan bir şeyler ürettiğinde buna halüsinasyon diyoruz.

Büyük dil modellerindeki halüsinasyonların bir türü modelin yönlendirmeye aykırı bir şeyler üretmesi ile oluyor.[5] Mesela “Fransa’nın başkenti nedir sorusunu İngilizce cevapla” yönlendirmesine Türkçe olarak “Fransa’nın başkenti Paris’tir” cevabı gelebiliyor. Bir diğer türü de modelin daha önce ürettiği çıktı ile çelişen bir şeyler üretmesi, yani bağlama aykırı üretim. Daha önemli bir sorun da -yukarıda gördüğümüz gibi- gerçekliğe aykırı üretim, yani dünya ile ilgili doğru bildiğimiz şeylere aykırı üretim. Sistemin eğitildiği tonlarca metin kaynağı içerisinde yanlış bilgiler olabilir, bunlar hatalı çıktıya sebep olabilirler. Yoruma açık metinler hatalı şekilde yorumlanabilir, farklı veriler birleştirilirken önemsiz ama çok tekrarlanmış bazı detaylar ağır basabilir. Mesela şirketlerin büyük dil modeli kullanan çağrı merkezi uygulamalarında kimi zaman servis botunun yanlış bilgi verdiği, gerçekte olmayan şirket politikaları uydurabildiği görülüyor. Bunlar halüsinasyonların ticari riskleri.

Bellek hataları dışında bu modeller “mantık hataları” da yapabilir. Hatalı çıkarımlar yapabilirler, yahut doğruluğu belirsiz olan bir önermeyi doğruymuş gibi kabul edebilirler.[6] Bunlar da halüsinasyona yol açabilir. Büyük dil modelleri cümle üretirken mantıksal yapıyı da ayrı bir sistemle oluşturuyorlar ve daha yeni sistemlere mantıksal tutarlılığın sağlanması için ayrı modüller ekleniyor. Ama dilde mantığın esnetildiği pek çok nokta var; kinaye gibi, benzetme gibi içerik olarak “doğru” diyemeyeceğimiz, ama belli bir düşünceyi rahatlıkla ileten yöntemler var. Büyük dil modelleri bu konuda da zorluk çekiyorlar.

Aslında temel sorun, bu modellerin doğruları bulmak için eğitilmemesi; sadece her seferinde bağlama uygun, istatistiksel olarak yüksek olasılığa sahip bir sonraki kelimeyi üreterek ilerliyorlar. Bir şeyleri bilmediklerinde akışı bozmamak için olası bir kelimeyi seçip boşlukları doldurmayı tercih ediyorlar. Bunlar da halüsinasyonların ortaya çıkmasına neden oluyor.

Peki neden bu modelleri doğruları bulmak için eğitmiyoruz? Birincisi eğitim için kullandığımız malzemenin doğruluğunu belirlemek son derece zor. Bir cümlenin doğruluğu zaman içinde değişebiliyor. “Wimbledon’u en çok kazanan kadın tenisçi Martina Navratilova’dır” cümlesi 1990 yılında yazıldığında doğruyken, bugün bu cümle doğru değil (doğrusu Serena Williams), ama eğitim setinin içinde bir yerlerde geçiyor olabilir. İkincisi, yoruma açık konularda neyin doğru neyin yanlış olduğu kesin çizgilerle ayrılmadığı için sadece doğrular diye ısrar edersek çok kısıtlı ve çok kuru bir sistem elde ediyoruz. Oysa bu modeller oldukça yaratıcı olabiliyorlar, bu da pek çok uygulamada işimize yarıyor.

Halüsinasyonun ilacı var mı?

Büyük dil modellerinin halüsinasyon görmesini engellemek için farklı yöntemler denenmiş. Modellerin üretim sırasında ne kadar “yaratıcı” davranacağını belirleyen bir sıcaklık (temperature) parametresi var. Bunu sıfıra getirdiğimizde sistem doğruluk oranı ve tahmin edilebilirliği yüksek, var olan bilgilere mümkün olduğunca dayanan bir çıktı üretiyor. En yüksek değer olan bire getirdiğimizde ise varolan bilgilerden yeni malzeme sentezliyor, daha “yaratıcı” işler yapabiliyor. ChatGPT’nin şu andaki kullanıcı arayüzü bu sıcaklık değerini değiştirmeye izin vermiyor (yönlendirme metnine sıcaklık değerini yazmak yeterli olmuyor), ama kod yazarak, programlama arayüzü (API) üzerinden GPT-5’e ulaşıldığında bu değer kontrol edilebiliyor. Standart sistem bu değeri 0,7 civarında tutuyor. Yüksek sıcaklık değerlerinde halüsinasyon ihtimali daha yüksek.

Halüsinasyonu azaltmak için kullanılan yöntemlerin en önemlisi kaynakla üretim (retrieval-augmented generation – RAG), bazı bilgileri sistemin kendi içinden üretmesi yerine Internet üzerinde bir arama yaparak bulduğu kaynak dokümanlardan tamamlamasını öngörüyor. Tabii bulunan dokümanların ne kadar güvenilir olduğu yine bir tartışma konusu. Örneğin ChatGPT’ye Cahit Arf üzerine yazdıklarında hatalar olduğunu söyleyince sistem bu sefer daha uzun “düşünüyor” ve muhtemelen bu sırada RAG modülünü devreye alarak konuyla ilgili ek kaynakları araştırıyor. 100 TL banknot ile ilgili kendi hatasını bu sırada tespit edebiliyor, ama bu sefer de Nancy Üniversitesi’nde doktora yaptığına dair başka bir yanlış bilgi araya karışıyor. Internet üzerinde “sahte” bilgilerin miktarının hızla arttığı düşünülürse, bu yöntemin iyi çalışması için güvenilir kaynakların özenle belirlenmesi gerekiyor. Eğer çok dar bir konuda uzmanlaşmış bir model kullanılacaksa, mesela klinik uygulamalara özel bir model geliştirilecekse,[7] modele bu konudaki güvenilir kaynaklarla ince-ayar (finetuning) denen bir ek eğitim uygulanabiliyor. Ama bunun için modelin açık kaynaklı bir model olması lazım (ChatGPT’nin kullandığı GPT-5 şu anda açık kaynaklı değil) ve bu eğitim için elimizde kaliteli veri ve güçlü bilgisayarlar olması şart.

Üçüncü bir yöntem de modelin ara katmanlarındaki gösterimleri kullanarak üretilecek olan verinin ne kadar gerçeğe yakın olduğunu kestirmeye çalışmak. Bu da yine modelin tamamına erişimin gerekli olduğu bir yaklaşım, dolayısıyla son kullanıcının izleyebileceği bir yöntem değil.[8]

Peki, modelin kendisine dokunamıyorsak, ne yapabiliriz? Yönlendirme metnini kullanarak halüsinasyon sorununu bir ölçüde azaltmak mümkün, ama tamamen ortadan kaldırmak şu anki teknoloji ile mümkün görünmüyor. Özellikle bilgiye dayalı sorularda kaynak gösterilmesini istemek (sonra da bu kaynaklara bakarak gerçekten o bilginin orada olduğunu kontrol etmek), sistemin vereceği bilgiler için bir güvenirlik düzeyi kestirmesini istemek, sorulan soruların kapsamını ve zaman dilimini sınırlamak gibi yaklaşımlar denenebilir. Sistemin özellikle yaratıcı cevaplar vermemesi gibi komutlar yönlendirmeye dahil edilebilir.

Yapay zekâ sahtekarlar için bir nimet mi?

Bir önceki kısımda bahsettiğimiz önlemler kullanıcının iyi niyetli olduğu durumlarda gündeme gelebilir. Peki ya kullanıcının niyeti başkaysa? Bu sadece bir halüsinasyon problemi değil elbette, ama büyük dil modellerinin halüsinasyon yoluyla ürettiği hatalı, gerçekdışı metinlerin yaygınlaşması giderek büyüyecek bir probleme işaret ediyor.

Büyük dil modellerinin kendine has riskleri var. Weidinger ve arkadaşlarının 2021 tarihli makalesi bunları şöyle özetliyor:[9]

Sistemlerin eğitildiği içeriğin kültürel çeşitliliği az olduğu için ayrımcılığa yol açabilirler;

“Doğru” bilginin yanlış kullanıma açık olduğu durumlara ilişkin riskler taşırlar (örneğin vergi kaçırma veya evde silah üretme yollarını açıklayabilirler);

Yanlış bilgiyi yayabilir, etik olmayan veya yasadışı pratikleri cesaretlendirebilirler;

Sahteciliği sansürü ve baskıcı gözetimi kolaylaştırabilirler;

Güven duygusu yaratarak kullanımı riskli sistemler hakkında yanlış izlenimler uyandırabilir, şahsi verilerin çalınmasına sebep olabilirler.

Özellikle akademik üretimde büyük dil modelleri ciddi problemlere yol açıyor. Büyük dil modellerinin metin üretme biçimi istatistiksel olduğu için “bilimsel” bir dille metin üretmeleri gerektiğinde bunu büyük bir başarıyla yapıyorlar. Fakat biçimi tutturmak içeriği doğru olarak doldurmaktan çok daha kolay… Okuduğu metni sadece biçimine bakarak yargılayanlar, içeriğini değerlendiremeyenler de kolayca kandırılıyor. Eğitim sisteminde işler kolaylaşacağına zorlaşıyor; ödev ve tezlerini kısmen veya tamamen bu programlara yazdıran öğrencilerin varlığı yadsınamaz. En azından ödev ve tezlerin birer ölçüm gereci olarak kullanışlılığı bir hayli azalmış durumda; öğrencilerin neyi bildiğini ölçmek için daha maliyetli ölçüm yöntemleri gerekiyor.

Bilimsel üretim boyutunda da işler iç açıcı değil. 2025 yılı Nisan ayında Springer Nature tarafından yayınlanan Mastering Machine Learning: From Basics to Advanced (Yapay Öğrenmede Ustalaşma: Temel Konulardan İleri Konulara) kitabının içinde bulunan atıfların pek çoğunun sahte veya hatalı olduğu anlaşıldı.[10] Bir büyük dil modeli ile hazırlandığı muhtemel bu kitap, sahte “bilimsel” üretime güzel bir örnek. Halüsinasyonlarla bazı atıflarda dergi ismi, bazılarında ise yazar uydurulmuş, bazılarında da atıf yapılan kaynak var ama konuyla ilgisi yok.

Bunlar nasıl gözden kaçıyor diye merak edebilirsiniz. Her ne kadar hakemler ve editörler basılacak kitapları değerlendiriyorsa da, yayın sayılarındaki müthiş artış bu denetlemenin kalitesinin düşmesine yol açtı. Pratikte büyük dil modellerinin sonucu makale yazmanın daha da kolaylaşması, basım ve sunum için yollanan makale sayılarının hızla artması, değerlendirmelerin bu hıza yetişememesi ve bütün bilimsel yapının temellerinden sarsılması olabilir. İsim yapmış kişi ve kurumların “güvenilir” oldukları için sürekli kaynak tercihi haline gelmesi, “zenginin zenginleşmesi” gibi pozitif geribesleme dinamiklerini öne çıkartarak bilimsel camiadaki eşitsizlikleri derinleştirebilir, marjinal ve yaratıcı çalışmaların yayınlanmasını zorlaştırabilir.

Belki de en önemli sonuçlardan biri, akademik üretimin bu şekilde sulandırılması yüzünden akademik kaynakların artık güvenilir olmaktan çıkması, toplumun çok ihtiyacı olan bir denetim ve bilgilendirme mekanizmasının artık işlevsiz hale gelmesi olabilir. Ülkemizde çok sayıda sahte yükseklisans ve doktora tezi yazdırıldığı, bunu iş edinen yüzlerce şirketin varlığı uzun zamandır biliniyor.[11] Büyük dil modelleri bu gibi sahtekarlıkları kolaylaştırıyor, denetim mekanizmalarının zayıf olduğu sistemler bundan en büyük zararı görüyor. Halüsinasyonlar yüzünden bu tezlere pek çok sahte bilginin girdiğini, bunların daha sonra yeni büyük dil modellerini besleyerek yayılacağını da tahmin edebiliriz. Bu problemleri de başka yazılarda ele almak lazım…

Utrecht Üniversitesi Enformasyon ve Bilgisayar Bilimleri Bölümü (BAGEP 2017)

Notlar/Kaynaklar

1 Microsoft announces new supercomputer, lays out vision for future AI work (Mayıs 2020) https://news.microsoft.com/source/features/innovation/openai-azure-supercomputer/

2 Bunun için “istem” kelimesi de kullanılıyor.

3 Gao, T., Fisch, A., & Chen, D. (2020). Making pre-trained language models better few-shot learners. arXiv preprint arXiv:2012.15723.

4 van Deemter, K. (2024). The pitfalls of defining hallucination. Computational Linguistics, 50(2), 807-816.

5 Huang, L., Yu, W., Ma, W., Zhong, W., Feng, Z., Wang, H., … & Liu, T. (2025). A survey on hallucination in large language models: Principles, taxonomy, challenges, and open questions. ACM Transactions on Information Systems, 43(2), 1-55.

6 Zhang, Y., Li, Y., Cui, L., Cai, D., Liu, L., Fu, T., … & Shi, S. (2025). Siren’s Song in the AI Ocean: A Survey on Hallucination in Large Language Models. Computational Linguistics, 1-46.

7 Girard, J. M., Yermol, D. A., Salah, A. A., & Cohn, J. F. (Ağustos 2025). Computational Analysis of Expressive Behavior in Clinical Assessment. Annual Reviews of Clinical Psychology. https://doi.org/10.1146/annurev-clinpsy-081423-024140. (Preprint: https://osf.io/preprints/psyarxiv/uf4nq_v2

8 Jesson, A., Beltran Velez, N., Chu, Q., Karlekar, S., Kossen, J., Gal, Y., … & Blei, D. (2024). Estimating the hallucination rate of generative AI. Advances in Neural Information Processing Systems, 37, 31154-31201.

9 Weidinger, L., Mellor, J., Rauh, M., Griffin, C., Uesato, J., Huang, P. S., … & Gabriel, I. (2021). Ethical and social risks of harm from language models. arXiv preprint arXiv:2112.04359.

10 Springer machine learning book faces fake citation scandal (Temmuz 2025), https://dig.watch/updates/springer-machine-learning-book-faces-fake-citation-scandal

11 Bilim Akademisinin Sahte Belge ve İmza Üretimi Hakkındaki Açıklaması (Ağustos 2025) https://bilimakademisi.org/sahte-belge-ve-imza-uretimi-hakkinda-bilim-akademisinin-aciklamasi/

Albert Ali Salah 1994 yılında İstanbul Alman Lisesi’nden, 1998 yılında Boğaziçi Üniversitesi Bilgisayar Mühendisliği Bölümü’nden mezun oldu. 2006 yılında Avrupa Biyometri Ödülü’nü, 2014 yılında BÜVAK Araştırmada Üstün Başarı Ödülü’nü, 2017 yılında Bilim Akademisi BAGEP Ödülü’nü aldı. 2018 yılında Suriyeli mültecilerin sağlık, eğitim, işsizlik, güvenlik ve entegrasyon sorunlarına büyük veri yöntemleri ile çözümler getirmeyi amaçlayan D4R: Data for Refugees projesinin yürütücülüğünü yaptı. Araştırma konuları insan davranışının bilgisayarla analizi, örüntü tanıma ve yapay öğrenmedir. Halen Hollanda’da Utrecht Üniversitesi’nde öğretim üyesi, Boğaziçi Üniversitesi Bilgisayar Mühendisliği Bölümü’nde ilintili öğretim üyesi olarak çalışmaktadır.

Albert Ali Salah 1994 yılında İstanbul Alman Lisesi’nden, 1998 yılında Boğaziçi Üniversitesi Bilgisayar Mühendisliği Bölümü’nden mezun oldu. 2006 yılında Avrupa Biyometri Ödülü’nü, 2014 yılında BÜVAK Araştırmada Üstün Başarı Ödülü’nü, 2017 yılında Bilim Akademisi BAGEP Ödülü’nü aldı. 2018 yılında Suriyeli mültecilerin sağlık, eğitim, işsizlik, güvenlik ve entegrasyon sorunlarına büyük veri yöntemleri ile çözümler getirmeyi amaçlayan D4R: Data for Refugees projesinin yürütücülüğünü yaptı. Araştırma konuları insan davranışının bilgisayarla analizi, örüntü tanıma ve yapay öğrenmedir. Halen Hollanda’da Utrecht Üniversitesi’nde öğretim üyesi, Boğaziçi Üniversitesi Bilgisayar Mühendisliği Bölümü’nde ilintili öğretim üyesi olarak çalışmaktadır.

Bu yazı Sarkaç Web Sitesi’nden ve Yazarı Albert Ali Salah’dan izin alınarak yayınlanmıştır.